作者:肖桐 (Tong Xiao) 朱靖波 (Jingbo Zhu)

单位:东北大学自然语言处理实验室 (NEUNLPLab) / 小牛翻译 (NiuTrans Research)

顾问:姚天顺 (Tianshun Yao) 王宝库 (Baoku Wang)

网站:https://opensource.niutrans.com/mtbook/homepage.html

GitHub:https://github.com/NiuTrans/MTBook

百度网盘: https://pan.baidu.com/s/1a0OG5Qnb9WGlitPsvbtx6A 提取码:MTBK

豆瓣评分:pencil2:: 豆瓣

这是一个教程,目的是对机器翻译的基础知识和建模方法进行较为系统的介绍,并在此基础上对机器翻译的一些前沿技术展开讨论(前身为《机器翻译:统计建模与深度学习方法》)。其内容被编纂成书,可以供计算机、人工智能相关专业高年级本科生及研究生学习之用,亦可作为自然语言处理,特别是机器翻译相关研究人员的参考资料。本书用tex编写,所有源代码均已开放。

本书共分为四个部分,每部分由若干章节组成,章节的顺序参考了机器翻译技术发展的时间脉络,同时兼顾了机器翻译知识体系的内在逻辑。各部分的主要关系如下(如果无法显示图片可以稍后再试):

Part I 机器翻译基础

- 机器翻译简介

- 统计语言建模基础

- 词法分析和语法分析基础

- 翻译质量评价

Part II 统计机器翻译

- 基于词的机器翻译建模

- 基于扭曲度和繁衍率的模型

- 基于短语的模型

- 基于句法的模型

Part III 神经机器翻译

- 人工神经网络和神经语言建模

- 基于循环神经网络的模型

- 基于卷积神经网络的模型

- 基于自注意力的模型

- 12.1 自注意力机制

- 12.2 Transformer 架构

- 12.3 位置编码

- 12.4 基于点乘的多头注意力机制

- 12.5 残差网络和层标准化

- 12.6 前馈全连接网络子层

- 12.7 训练

- 12.8 推断

- 12.9 小结及拓展阅读

Part IV 机器翻译前沿

- 神经机器翻译模型训练

- 神经机器翻译模型推断

- 神经机器翻译结构优化

- 低资源神经机器翻译

- 多模态、多层次机器翻译

- 机器翻译应用技术

- 18.1 机器翻译的应用并不简单

- 18.2 增量式模型优化

- 18.3 交互式机器翻译

- 18.4 翻译结果的可干预性

- 18.5 小设备机器翻译

- 18.6 机器翻译系统的部署

- 18.7 机器翻译的应用场景

Part V 附录

注:本书的pdf版本可以从GitHub仓库获取https://github.com/NiuTrans/MTBook/blob/master/mt-book.pdf

本书的tex源代码地址为:https://github.com/NiuTrans/MTBook/tree/master/src

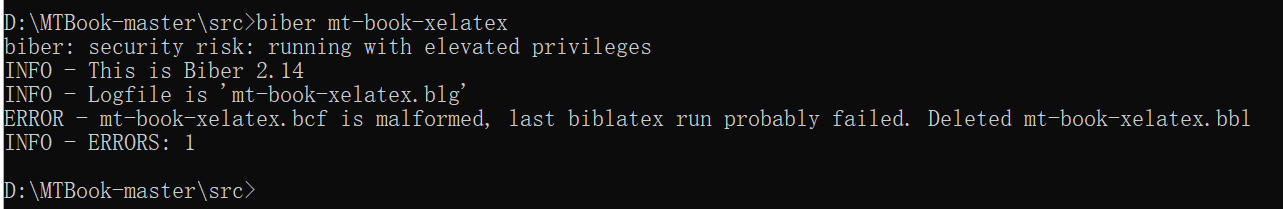

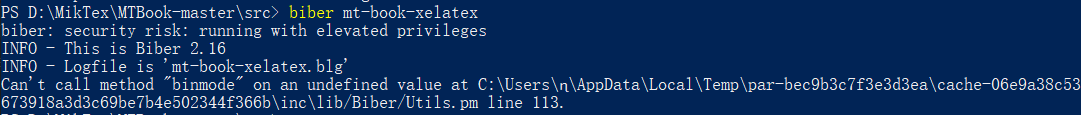

编译前需要安装MikTeX,并在MikTeX Console中下载并更新编译所需宏包。之后,编译src目录下的mt-book-xelatex.tex即可得到pdf文件,编译指令如下:

xelatex mt-book-xelatex

biber mt-book-xelatex

makeindex mt-book-xelatex

xelatex mt-book-xelatex

xelatex mt-book-xelatex在编译中可能会遇到内存不足的问题,可以通过以下方式解决:

-

运行cmd打开命令行窗口,输入:

initexmf --edit-config-file=xelatex -

在弹出的文件中输入以下内容:

main_memory=5000000 extra_mem_bot=5000000 font_mem_size=5000000 pool_size=5000000 buf_size=5000000 -

在cmd窗口输入:

initexmf --dump=xelatex更新latex格式文件

-

打开texmf.cnf文件,更改其内容为:

main_memory=5000000 extra_mem_bot=5000000 font_mem_size=5000000 pool_size=5000000 buf_size=5000000 -

调用texhash更新latex格式文件

注1:编译tex文件会依赖一些宏包。如果有任何编译错误,建议将宏包更新至最新版本。

注2:部分系统可能需要安装中文字体,在网站https://www.wfonts.com/搜索字体,如:SimSun(宋体)和Microsoft YaHei(微软雅黑),安装字体即可。

肖桐 朱靖波,机器翻译:基础与模型,电子工业出版社, 2021.bib文件

@book{xiao-and-zhu-mtbook-2021,

title = {机器翻译:基础与模型},

publisher = {电子工业出版社},

year = {2021},

author = {肖桐 and 朱靖波},

address = {北京},

isbn = {9787121335198}

}本教程部分章节的课件已开放(我们对部分章节进行了合并,课件的顺序与书中章节的顺序并不完全一致)。pdf版本的地址为https://github.com/NiuTrans/MTBook/tree/master/slides

本书的开源内容基于The Creative Commons Attribution-NonCommercial 4.0 Unported License(link)

2021年8月25日 勘误与部分内容修正 V0.32

2021年2月1日 修复大量的文字错误 V0.31

2021年2月1日 《机器翻译:基础与模型》,完整版 V0.3

2020年12月1日 《机器翻译:基础与模型》(更名后),基础篇 V0.2

2020年5月21日 《机器翻译:统计建模与深度学习方法》,第一版 V0.1

感谢为本书做出贡献的小牛团队(部分)成员

曹润柘、曾信、孟霞、单韦乔、周涛、周书含、许诺、李北、许晨、林野、李垠桥、王子扬、刘辉、张裕浩、冯凯、罗应峰、魏冰浩、王屹超、李炎洋、胡驰、姜雨帆、田丰宁、刘继强、张哲旸、陈贺轩、牛蕊、杜权、张春良、王会珍、张俐、马安香、胡明涵

有任何问题请联系xiaotong [at] mail.neu.edu.cn (肖桐) 或 caorz0628 [at] qq.com(曹润柘)