点击本页面右上角的 Watch 在弹出框中点击 Watching 订阅本博客,这样本博客的所有文章更新和评论都会在github首页出现。

公众号(刚申请,之后文章会往上面发):

有深度的Java技术博客

点击本页面右上角的 Watch 在弹出框中点击 Watching 订阅本博客,这样本博客的所有文章更新和评论都会在github首页出现。

公众号(刚申请,之后文章会往上面发):

关于synchronized的底层实现,网上有很多文章了。但是很多文章要么作者根本没看代码,仅仅是根据网上其他文章总结、照搬而成,难免有些错误;要么很多点都是一笔带过,对于为什么这样实现没有一个说法,让像我这样的读者意犹未尽。

本系列文章将对HotSpot的synchronized锁实现进行全面分析,内容包括偏向锁、轻量级锁、重量级锁的加锁、解锁、锁升级流程的原理及源码分析,希望给在研究synchronized路上的同学一些帮助。主要包括以下几篇文章:

更多文章见个人博客:https://github.com/farmerjohngit/myblog

大概花费了两周的实现看代码(花费了这么久时间有些忏愧,主要是对C++、JVM底层机制、JVM调试以及汇编代码不太熟),将synchronized涉及到的代码基本都看了一遍,其中还包括在JVM中添加日志验证自己的猜想,总的来说目前对synchronized这块有了一个比较全面清晰的认识,但水平有限,有些细节难免有些疏漏,还望请大家指正。

本篇文章将对synchronized机制做个大致的介绍,包括用以承载锁状态的对象头、锁的几种形式、各种形式锁的加锁和解锁流程、什么时候会发生锁升级。需要注意的是本文旨在介绍背景和概念,在讲述一些流程的时候,只提到了主要case,对于实现细节、运行时的不同分支都在后面的文章中详细分析。

本人看的JVM版本是jdk8u,具体版本号以及代码可以在这里看到。

Java中提供了两种实现同步的基础语义:synchronized方法和synchronized块, 我们来看个demo:

public class SyncTest {

public void syncBlock(){

synchronized (this){

System.out.println("hello block");

}

}

public synchronized void syncMethod(){

System.out.println("hello method");

}

}当SyncTest.java被编译成class文件的时候,synchronized关键字和synchronized方法的字节码略有不同,我们可以用javap -v 命令查看class文件对应的JVM字节码信息,部分信息如下:

{

public void syncBlock();

descriptor: ()V

flags: ACC_PUBLIC

Code:

stack=2, locals=3, args_size=1

0: aload_0

1: dup

2: astore_1

3: monitorenter // monitorenter指令进入同步块

4: getstatic #2 // Field java/lang/System.out:Ljava/io/PrintStream;

7: ldc #3 // String hello block

9: invokevirtual #4 // Method java/io/PrintStream.println:(Ljava/lang/String;)V

12: aload_1

13: monitorexit // monitorexit指令退出同步块

14: goto 22

17: astore_2

18: aload_1

19: monitorexit // monitorexit指令退出同步块

20: aload_2

21: athrow

22: return

Exception table:

from to target type

4 14 17 any

17 20 17 any

public synchronized void syncMethod();

descriptor: ()V

flags: ACC_PUBLIC, ACC_SYNCHRONIZED //添加了ACC_SYNCHRONIZED标记

Code:

stack=2, locals=1, args_size=1

0: getstatic #2 // Field java/lang/System.out:Ljava/io/PrintStream;

3: ldc #5 // String hello method

5: invokevirtual #4 // Method java/io/PrintStream.println:(Ljava/lang/String;)V

8: return

}从上面的中文注释处可以看到,对于synchronized关键字而言,javac在编译时,会生成对应的monitorenter和monitorexit指令分别对应synchronized同步块的进入和退出,有两个monitorexit指令的原因是:为了保证抛异常的情况下也能释放锁,所以javac为同步代码块添加了一个隐式的try-finally,在finally中会调用monitorexit命令释放锁。而对于synchronized方法而言,javac为其生成了一个ACC_SYNCHRONIZED关键字,在JVM进行方法调用时,发现调用的方法被ACC_SYNCHRONIZED修饰,则会先尝试获得锁。

在JVM底层,对于这两种synchronized语义的实现大致相同,在后文中会选择一种进行详细分析。

因为本文旨在分析synchronized的实现原理,因此对于其使用的一些问题就不赘述了,不了解的朋友可以看看这篇文章。

传统的锁(也就是下文要说的重量级锁)依赖于系统的同步函数,在linux上使用mutex互斥锁,最底层实现依赖于futex,关于futex可以看我之前的文章,这些同步函数都涉及到用户态和内核态的切换、进程的上下文切换,成本较高。对于加了synchronized关键字但运行时并没有多线程竞争,或两个线程接近于交替执行的情况,使用传统锁机制无疑效率是会比较低的。

在JDK 1.6之前,synchronized只有传统的锁机制,因此给开发者留下了synchronized关键字相比于其他同步机制性能不好的印象。

在JDK 1.6引入了两种新型锁机制:偏向锁和轻量级锁,它们的引入是为了解决在没有多线程竞争或基本没有竞争的场景下因使用传统锁机制带来的性能开销问题。

在看这几种锁机制的实现前,我们先来了解下对象头,它是实现多种锁机制的基础。

因为在Java中任意对象都可以用作锁,因此必定要有一个映射关系,存储该对象以及其对应的锁信息(比如当前哪个线程持有锁,哪些线程在等待)。一种很直观的方法是,用一个全局map,来存储这个映射关系,但这样会有一些问题:需要对map做线程安全保障,不同的synchronized之间会相互影响,性能差;另外当同步对象较多时,该map可能会占用比较多的内存。

所以最好的办法是将这个映射关系存储在对象头中,因为对象头本身也有一些hashcode、GC相关的数据,所以如果能将锁信息与这些信息共存在对象头中就好了。

在JVM中,对象在内存中除了本身的数据外还会有个对象头,对于普通对象而言,其对象头中有两类信息:mark word和类型指针。另外对于数组而言还会有一份记录数组长度的数据。

类型指针是指向该对象所属类对象的指针,mark word用于存储对象的HashCode、GC分代年龄、锁状态等信息。在32位系统上mark word长度为32bit,64位系统上长度为64bit。为了能在有限的空间里存储下更多的数据,其存储格式是不固定的,在32位系统上各状态的格式如下:

可以看到锁信息也是存在于对象的mark word中的。当对象状态为偏向锁(biasable)时,mark word存储的是偏向的线程ID;当状态为轻量级锁(lightweight locked)时,mark word存储的是指向线程栈中Lock Record的指针;当状态为重量级锁(inflated)时,为指向堆中的monitor对象的指针。

重量级锁是我们常说的传统意义上的锁,其利用操作系统底层的同步机制去实现Java中的线程同步。

重量级锁的状态下,对象的mark word为指向一个堆中monitor对象的指针。

一个monitor对象包括这么几个关键字段:cxq(下图中的ContentionList),EntryList ,WaitSet,owner。

其中cxq ,EntryList ,WaitSet都是由ObjectWaiter的链表结构,owner指向持有锁的线程。

当一个线程尝试获得锁时,如果该锁已经被占用,则会将该线程封装成一个ObjectWaiter对象插入到cxq的队列尾部,然后暂停当前线程。当持有锁的线程释放锁前,会将cxq中的所有元素移动到EntryList中去,并唤醒EntryList的队首线程。

如果一个线程在同步块中调用了Object#wait方法,会将该线程对应的ObjectWaiter从EntryList移除并加入到WaitSet中,然后释放锁。当wait的线程被notify之后,会将对应的ObjectWaiter从WaitSet移动到EntryList中。

以上只是对重量级锁流程的一个简述,其中涉及到的很多细节,比如ObjectMonitor对象从哪来?释放锁时是将cxq中的元素移动到EntryList的尾部还是头部?notfiy时,是将ObjectWaiter移动到EntryList的尾部还是头部?

关于具体的细节,会在重量级锁的文章中分析。

JVM的开发者发现在很多情况下,在Java程序运行时,同步块中的代码都是不存在竞争的,不同的线程交替的执行同步块中的代码。这种情况下,用重量级锁是没必要的。因此JVM引入了轻量级锁的概念。

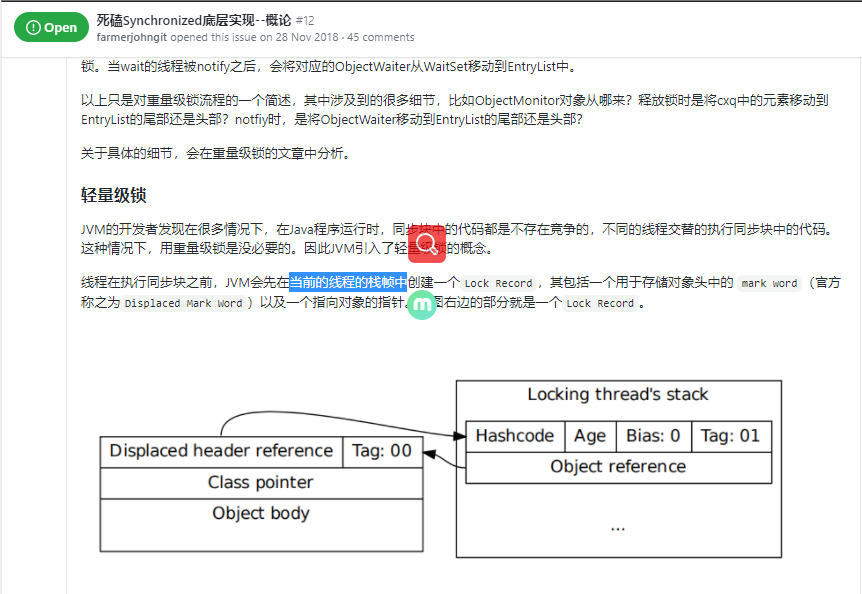

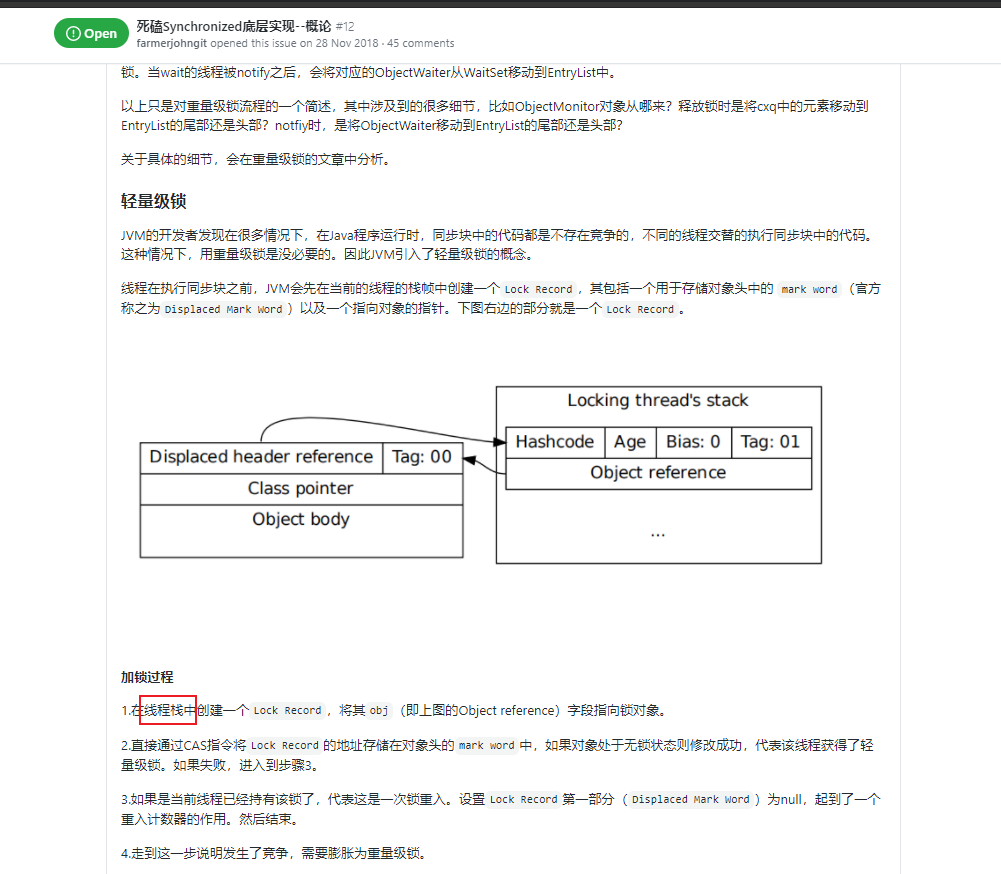

线程在执行同步块之前,JVM会先在当前的线程的栈帧中创建一个Lock Record,其包括一个用于存储对象头中的 mark word(官方称之为Displaced Mark Word)以及一个指向对象的指针。下图右边的部分就是一个Lock Record。

1.在线程栈中创建一个Lock Record,将其obj(即上图的Object reference)字段指向锁对象。

2.直接通过CAS指令将Lock Record的地址存储在对象头的mark word中,如果对象处于无锁状态则修改成功,代表该线程获得了轻量级锁。如果失败,进入到步骤3。

3.如果是当前线程已经持有该锁了,代表这是一次锁重入。设置Lock Record第一部分(Displaced Mark Word)为null,起到了一个重入计数器的作用。然后结束。

4.走到这一步说明发生了竞争,需要膨胀为重量级锁。

1.遍历线程栈,找到所有obj字段等于当前锁对象的Lock Record。

2.如果Lock Record的Displaced Mark Word为null,代表这是一次重入,将obj设置为null后continue。

3.如果Lock Record的Displaced Mark Word不为null,则利用CAS指令将对象头的mark word恢复成为Displaced Mark Word。如果成功,则continue,否则膨胀为重量级锁。

Java是支持多线程的语言,因此在很多二方包、基础库中为了保证代码在多线程的情况下也能正常运行,也就是我们常说的线程安全,都会加入如synchronized这样的同步语义。但是在应用在实际运行时,很可能只有一个线程会调用相关同步方法。比如下面这个demo:

import java.util.ArrayList;

import java.util.List;

public class SyncDemo1 {

public static void main(String[] args) {

SyncDemo1 syncDemo1 = new SyncDemo1();

for (int i = 0; i < 100; i++) {

syncDemo1.addString("test:" + i);

}

}

private List<String> list = new ArrayList<>();

public synchronized void addString(String s) {

list.add(s);

}

}在这个demo中为了保证对list操纵时线程安全,对addString方法加了synchronized的修饰,但实际使用时却只有一个线程调用到该方法,对于轻量级锁而言,每次调用addString时,加锁解锁都有一个CAS操作;对于重量级锁而言,加锁也会有一个或多个CAS操作(这里的’一个‘、’多个‘数量词只是针对该demo,并不适用于所有场景)。

在JDK1.6中为了提高一个对象在一段很长的时间内都只被一个线程用做锁对象场景下的性能,引入了偏向锁,在第一次获得锁时,会有一个CAS操作,之后该线程再获取锁,只会执行几个简单的命令,而不是开销相对较大的CAS命令。我们来看看偏向锁是如何做的。

当JVM启用了偏向锁模式(1.6以上默认开启),当新创建一个对象的时候,如果该对象所属的class没有关闭偏向锁模式(什么时候会关闭一个class的偏向模式下文会说,默认所有class的偏向模式都是是开启的),那新创建对象的mark word将是可偏向状态,此时mark word中的thread id(参见上文偏向状态下的mark word格式)为0,表示未偏向任何线程,也叫做匿名偏向(anonymously biased)。

case 1:当该对象第一次被线程获得锁的时候,发现是匿名偏向状态,则会用CAS指令,将mark word中的thread id由0改成当前线程Id。如果成功,则代表获得了偏向锁,继续执行同步块中的代码。否则,将偏向锁撤销,升级为轻量级锁。

case 2:当被偏向的线程再次进入同步块时,发现锁对象偏向的就是当前线程,在通过一些额外的检查后(细节见后面的文章),会往当前线程的栈中添加一条Displaced Mark Word为空的Lock Record中,然后继续执行同步块的代码,因为操纵的是线程私有的栈,因此不需要用到CAS指令;由此可见偏向锁模式下,当被偏向的线程再次尝试获得锁时,仅仅进行几个简单的操作就可以了,在这种情况下,synchronized关键字带来的性能开销基本可以忽略。

case 3.当其他线程进入同步块时,发现已经有偏向的线程了,则会进入到撤销偏向锁的逻辑里,一般来说,会在safepoint中去查看偏向的线程是否还存活,如果存活且还在同步块中则将锁升级为轻量级锁,原偏向的线程继续拥有锁,当前线程则走入到锁升级的逻辑里;如果偏向的线程已经不存活或者不在同步块中,则将对象头的mark word改为无锁状态(unlocked),之后再升级为轻量级锁。

由此可见,偏向锁升级的时机为:当锁已经发生偏向后,只要有另一个线程尝试获得偏向锁,则该偏向锁就会升级成轻量级锁。当然这个说法不绝对,因为还有批量重偏向这一机制。

当有其他线程尝试获得锁时,是根据遍历偏向线程的lock record来确定该线程是否还在执行同步块中的代码。因此偏向锁的解锁很简单,仅仅将栈中的最近一条lock record的obj字段设置为null。需要注意的是,偏向锁的解锁步骤中并不会修改对象头中的thread id。

下图展示了锁状态的转换流程:

另外,偏向锁默认不是立即就启动的,在程序启动后,通常有几秒的延迟,可以通过命令 -XX:BiasedLockingStartupDelay=0来关闭延迟。

从上文偏向锁的加锁解锁过程中可以看出,当只有一个线程反复进入同步块时,偏向锁带来的性能开销基本可以忽略,但是当有其他线程尝试获得锁时,就需要等到safe point时将偏向锁撤销为无锁状态或升级为轻量级/重量级锁。safe point这个词我们在GC中经常会提到,其代表了一个状态,在该状态下所有线程都是暂停的(大概这么个意思),详细可以看这篇文章。总之,偏向锁的撤销是有一定成本的,如果说运行时的场景本身存在多线程竞争的,那偏向锁的存在不仅不能提高性能,而且会导致性能下降。因此,JVM中增加了一种批量重偏向/撤销的机制。

存在如下两种情况:(见官方论文第4小节):

1.一个线程创建了大量对象并执行了初始的同步操作,之后在另一个线程中将这些对象作为锁进行之后的操作。这种case下,会导致大量的偏向锁撤销操作。

2.存在明显多线程竞争的场景下使用偏向锁是不合适的,例如生产者/消费者队列。

批量重偏向(bulk rebias)机制是为了解决第一种场景。批量撤销(bulk revoke)则是为了解决第二种场景。

其做法是:以class为单位,为每个class维护一个偏向锁撤销计数器,每一次该class的对象发生偏向撤销操作时,该计数器+1,当这个值达到重偏向阈值(默认20)时,JVM就认为该class的偏向锁有问题,因此会进行批量重偏向。每个class对象会有一个对应的epoch字段,每个处于偏向锁状态对象的mark word中也有该字段,其初始值为创建该对象时,class中的epoch的值。每次发生批量重偏向时,就将该值+1,同时遍历JVM中所有线程的栈,找到该class所有正处于加锁状态的偏向锁,将其epoch字段改为新值。下次获得锁时,发现当前对象的epoch值和class的epoch不相等,那就算当前已经偏向了其他线程,也不会执行撤销操作,而是直接通过CAS操作将其mark word的Thread Id 改成当前线程Id。

当达到重偏向阈值后,假设该class计数器继续增长,当其达到批量撤销的阈值后(默认40),JVM就认为该class的使用场景存在多线程竞争,会标记该class为不可偏向,之后,对于该class的锁,直接走轻量级锁的逻辑。

Java中的synchronized有偏向锁、轻量级锁、重量级锁三种形式,分别对应了锁只被一个线程持有、不同线程交替持有锁、多线程竞争锁三种情况。当条件不满足时,锁会按偏向锁->轻量级锁->重量级锁 的顺序升级。JVM种的锁也是能降级的,只不过条件很苛刻,不在我们讨论范围之内。该篇文章主要是对Java的synchronized做个基本介绍,后文会有更详细的分析。

本文为synchronized系列第二篇。主要内容为分析偏向锁的实现。

偏向锁的诞生背景和基本原理在上文中已经讲过了,强烈建议在有看过上篇文章的基础下阅读本文。

更多文章见个人博客:https://github.com/farmerjohngit/myblog

本系列文章将对HotSpot的synchronized锁实现进行全面分析,内容包括偏向锁、轻量级锁、重量级锁的加锁、解锁、锁升级流程的原理及源码分析,希望给在研究synchronized路上的同学一些帮助。主要包括以下几篇文章:

本文将分为几块内容:

1.偏向锁的入口

2.偏向锁的获取流程

3.偏向锁的撤销流程

4.偏向锁的释放流程

5.偏向锁的批量重偏向和批量撤销

本文分析的JVM版本是JVM8,具体版本号以及代码可以在这里看到。

目前网上的很多文章,关于偏向锁源码入口都找错地方了,导致我之前对于偏向锁的很多逻辑一直想不通,走了很多弯路。

synchronized分为synchronized代码块和synchronized方法,其底层获取锁的逻辑都是一样的,本文讲解的是synchronized代码块的实现。上篇文章也说过,synchronized代码块是由monitorenter和monitorexit两个指令实现的。

关于HotSpot虚拟机中获取锁的入口,网上很多文章要么给出的方法入口为interpreterRuntime.cpp#monitorenter,要么给出的入口为bytecodeInterpreter.cpp#1816。包括占小狼的这篇文章关于锁入口的位置说法也是有问题的(当然文章还是很好的,在我刚开始研究synchronized的时候,小狼哥的这篇文章给了我很多帮助)。

要找锁的入口,肯定是要在源码中找到对monitorenter指令解析的地方。在HotSpot的中有两处地方对monitorenter指令进行解析:一个是在bytecodeInterpreter.cpp#1816 ,另一个是在templateTable_x86_64.cpp#3667。

前者是JVM中的字节码解释器(bytecodeInterpreter),用C++实现了每条JVM指令(如monitorenter、invokevirtual等),其优点是实现相对简单且容易理解,缺点是执行慢。后者是模板解释器(templateInterpreter),其对每个指令都写了一段对应的汇编代码,启动时将每个指令与对应汇编代码入口绑定,可以说是效率做到了极致。模板解释器的实现可以看这篇文章,在研究的过程中也请教过文章作者‘汪先生’一些问题,这里感谢一下。

在HotSpot中,只用到了模板解释器,字节码解释器根本就没用到,R大的读书笔记中说的很清楚了,大家可以看看,这里不再赘述。

所以montorenter的解析入口在模板解释器中,其代码位于templateTable_x86_64.cpp#3667。通过调用路径:templateTable_x86_64#monitorenter->interp_masm_x86_64#lock_object进入到偏向锁入口macroAssembler_x86#biased_locking_enter,在这里大家可以看到会生成对应的汇编代码。需要注意的是,不是说每次解析monitorenter指令都会调用biased_locking_enter,而是只会在JVM启动的时候调用该方法生成汇编代码,之后对指令的解析是通过直接执行汇编代码。

其实bytecodeInterpreter的逻辑和templateInterpreter的逻辑是大同小异的,因为templateInterpreter中都是汇编代码,比较晦涩,所以看bytecodeInterpreter的实现会便于理解一点。但这里有个坑,在jdk8u之前,bytecodeInterpreter并没有实现偏向锁的逻辑。我之前看的JDK8-87ee5ee27509这个版本就没有实现偏向锁的逻辑,导致我看了很久都没看懂。在这个commit中对bytecodeInterpreter加入了偏向锁的支持,我大致了看了下和templateInterpreter对比除了栈结构不同外,其他逻辑大致相同,所以下文就按bytecodeInterpreter中的代码对偏向锁逻辑进行讲解。templateInterpreter的汇编代码讲解可以看这篇文章,其实汇编源码中都有英文注释,了解了汇编几个基本指令的作用再结合注释理解起来也不是很难。

下面开始偏向锁获取流程分析,代码在bytecodeInterpreter.cpp#1816。注意本文代码都有所删减。

CASE(_monitorenter): {

// lockee 就是锁对象

oop lockee = STACK_OBJECT(-1);

// derefing's lockee ought to provoke implicit null check

CHECK_NULL(lockee);

// code 1:找到一个空闲的Lock Record

BasicObjectLock* limit = istate->monitor_base();

BasicObjectLock* most_recent = (BasicObjectLock*) istate->stack_base();

BasicObjectLock* entry = NULL;

while (most_recent != limit ) {

if (most_recent->obj() == NULL) entry = most_recent;

else if (most_recent->obj() == lockee) break;

most_recent++;

}

//entry不为null,代表还有空闲的Lock Record

if (entry != NULL) {

// code 2:将Lock Record的obj指针指向锁对象

entry->set_obj(lockee);

int success = false;

uintptr_t epoch_mask_in_place = (uintptr_t)markOopDesc::epoch_mask_in_place;

// markoop即对象头的mark word

markOop mark = lockee->mark();

intptr_t hash = (intptr_t) markOopDesc::no_hash;

// code 3:如果锁对象的mark word的状态是偏向模式

if (mark->has_bias_pattern()) {

uintptr_t thread_ident;

uintptr_t anticipated_bias_locking_value;

thread_ident = (uintptr_t)istate->thread();

// code 4:这里有几步操作,下文分析

anticipated_bias_locking_value =

(((uintptr_t)lockee->klass()->prototype_header() | thread_ident) ^ (uintptr_t)mark) &

~((uintptr_t) markOopDesc::age_mask_in_place);

// code 5:如果偏向的线程是自己且epoch等于class的epoch

if (anticipated_bias_locking_value == 0) {

// already biased towards this thread, nothing to do

if (PrintBiasedLockingStatistics) {

(* BiasedLocking::biased_lock_entry_count_addr())++;

}

success = true;

}

// code 6:如果偏向模式关闭,则尝试撤销偏向锁

else if ((anticipated_bias_locking_value & markOopDesc::biased_lock_mask_in_place) != 0) {

markOop header = lockee->klass()->prototype_header();

if (hash != markOopDesc::no_hash) {

header = header->copy_set_hash(hash);

}

// 利用CAS操作将mark word替换为class中的mark word

if (Atomic::cmpxchg_ptr(header, lockee->mark_addr(), mark) == mark) {

if (PrintBiasedLockingStatistics)

(*BiasedLocking::revoked_lock_entry_count_addr())++;

}

}

// code 7:如果epoch不等于class中的epoch,则尝试重偏向

else if ((anticipated_bias_locking_value & epoch_mask_in_place) !=0) {

// 构造一个偏向当前线程的mark word

markOop new_header = (markOop) ( (intptr_t) lockee->klass()->prototype_header() | thread_ident);

if (hash != markOopDesc::no_hash) {

new_header = new_header->copy_set_hash(hash);

}

// CAS替换对象头的mark word

if (Atomic::cmpxchg_ptr((void*)new_header, lockee->mark_addr(), mark) == mark) {

if (PrintBiasedLockingStatistics)

(* BiasedLocking::rebiased_lock_entry_count_addr())++;

}

else {

// 重偏向失败,代表存在多线程竞争,则调用monitorenter方法进行锁升级

CALL_VM(InterpreterRuntime::monitorenter(THREAD, entry), handle_exception);

}

success = true;

}

else {

// 走到这里说明当前要么偏向别的线程,要么是匿名偏向(即没有偏向任何线程)

// code 8:下面构建一个匿名偏向的mark word,尝试用CAS指令替换掉锁对象的mark word

markOop header = (markOop) ((uintptr_t) mark & ((uintptr_t)markOopDesc::biased_lock_mask_in_place |(uintptr_t)markOopDesc::age_mask_in_place |epoch_mask_in_place));

if (hash != markOopDesc::no_hash) {

header = header->copy_set_hash(hash);

}

markOop new_header = (markOop) ((uintptr_t) header | thread_ident);

// debugging hint

DEBUG_ONLY(entry->lock()->set_displaced_header((markOop) (uintptr_t) 0xdeaddead);)

if (Atomic::cmpxchg_ptr((void*)new_header, lockee->mark_addr(), header) == header) {

// CAS修改成功

if (PrintBiasedLockingStatistics)

(* BiasedLocking::anonymously_biased_lock_entry_count_addr())++;

}

else {

// 如果修改失败说明存在多线程竞争,所以进入monitorenter方法

CALL_VM(InterpreterRuntime::monitorenter(THREAD, entry), handle_exception);

}

success = true;

}

}

// 如果偏向线程不是当前线程或没有开启偏向模式等原因都会导致success==false

if (!success) {

// 轻量级锁的逻辑

//code 9: 构造一个无锁状态的Displaced Mark Word,并将Lock Record的lock指向它

markOop displaced = lockee->mark()->set_unlocked();

entry->lock()->set_displaced_header(displaced);

//如果指定了-XX:+UseHeavyMonitors,则call_vm=true,代表禁用偏向锁和轻量级锁

bool call_vm = UseHeavyMonitors;

// 利用CAS将对象头的mark word替换为指向Lock Record的指针

if (call_vm || Atomic::cmpxchg_ptr(entry, lockee->mark_addr(), displaced) != displaced) {

// 判断是不是锁重入

if (!call_vm && THREAD->is_lock_owned((address) displaced->clear_lock_bits())) { //code 10: 如果是锁重入,则直接将Displaced Mark Word设置为null

entry->lock()->set_displaced_header(NULL);

} else {

CALL_VM(InterpreterRuntime::monitorenter(THREAD, entry), handle_exception);

}

}

}

UPDATE_PC_AND_TOS_AND_CONTINUE(1, -1);

} else {

// lock record不够,重新执行

istate->set_msg(more_monitors);

UPDATE_PC_AND_RETURN(0); // Re-execute

}

}JVM中的每个类也有一个类似mark word的prototype_header,用来标记该class的epoch和偏向开关等信息。上面的代码中lockee->klass()->prototype_header()即获取class的prototype_header。

code 1,从当前线程的栈中找到一个空闲的Lock Record(即代码中的BasicObjectLock,下文都用Lock Record代指),判断Lock Record是否空闲的依据是其obj字段 是否为null。注意这里是按内存地址从低往高找到最后一个可用的Lock Record,换而言之,就是找到内存地址最高的可用Lock Record。

code 2,获取到Lock Record后,首先要做的就是为其obj字段赋值。

code 3,判断锁对象的mark word是否是偏向模式,即低3位是否为101。

code 4,这里有几步位运算的操作 anticipated_bias_locking_value = (((uintptr_t)lockee->klass()->prototype_header() | thread_ident) ^ (uintptr_t)mark) & ~((uintptr_t) markOopDesc::age_mask_in_place); 这个位运算可以分为3个部分。

第一部分((uintptr_t)lockee->klass()->prototype_header() | thread_ident) 将当前线程id和类的prototype_header相或,这样得到的值为(当前线程id + prototype_header中的(epoch + 分代年龄 + 偏向锁标志 + 锁标志位)),注意prototype_header的分代年龄那4个字节为0

第二部分 ^ (uintptr_t)mark 将上面计算得到的结果与锁对象的markOop进行异或,相等的位全部被置为0,只剩下不相等的位。

第三部分 & ~((uintptr_t) markOopDesc::age_mask_in_place) markOopDesc::age_mask_in_place为...0001111000,取反后,变成了...1110000111,除了分代年龄那4位,其他位全为1;将取反后的结果再与上面的结果相与,将上面异或得到的结果中分代年龄给忽略掉。

code 5,anticipated_bias_locking_value==0代表偏向的线程是当前线程且mark word的epoch等于class的epoch,这种情况下什么都不用做。

code 6,(anticipated_bias_locking_value & markOopDesc::biased_lock_mask_in_place) != 0代表class的prototype_header或对象的mark word中偏向模式是关闭的,又因为能走到这已经通过了mark->has_bias_pattern()判断,即对象的mark word中偏向模式是开启的,那也就是说class的prototype_header不是偏向模式。

然后利用CAS指令Atomic::cmpxchg_ptr(header, lockee->mark_addr(), mark) == mark撤销偏向锁,我们知道CAS会有几个参数,1是预期的原值,2是预期修改后的值 ,3是要修改的对象,与之对应,cmpxchg_ptr方法第一个参数是预期修改后的值,第2个参数是修改的对象,第3个参数是预期原值,方法返回实际原值,如果等于预期原值则说明修改成功。

code 7,如果epoch已过期,则需要重偏向,利用CAS指令将锁对象的mark word替换为一个偏向当前线程且epoch为类的epoch的新的mark word。

code 8,CAS将偏向线程改为当前线程,如果当前是匿名偏向则能修改成功,否则进入锁升级的逻辑。

code 9,这一步已经是轻量级锁的逻辑了。从上图的mark word的格式可以看到,轻量级锁中mark word存的是指向Lock Record的指针。这里构造一个无锁状态的mark word,然后存储到Lock Record(Lock Record的格式可以看第一篇文章)。设置mark word是无锁状态的原因是:轻量级锁解锁时是将对象头的mark word设置为Lock Record中的Displaced Mark Word,所以创建时设置为无锁状态,解锁时直接用CAS替换就好了。

code 10, 如果是锁重入,则将Lock Record的Displaced Mark Word设置为null,起到一个锁重入计数的作用。

以上是偏向锁加锁的流程(包括部分轻量级锁的加锁流程),如果当前锁已偏向其他线程||epoch值过期||偏向模式关闭||获取偏向锁的过程中存在并发冲突,都会进入到InterpreterRuntime::monitorenter方法, 在该方法中会对偏向锁撤销和升级。

这里说的撤销是指在获取偏向锁的过程因为不满足条件导致要将锁对象改为非偏向锁状态;释放是指退出同步块时的过程,释放锁的逻辑会在下一小节阐述。请读者注意本文中撤销与释放的区别。

如果获取偏向锁失败会进入到InterpreterRuntime::monitorenter方法

IRT_ENTRY_NO_ASYNC(void, InterpreterRuntime::monitorenter(JavaThread* thread, BasicObjectLock* elem))

...

Handle h_obj(thread, elem->obj());

assert(Universe::heap()->is_in_reserved_or_null(h_obj()),

"must be NULL or an object");

if (UseBiasedLocking) {

// Retry fast entry if bias is revoked to avoid unnecessary inflation

ObjectSynchronizer::fast_enter(h_obj, elem->lock(), true, CHECK);

} else {

ObjectSynchronizer::slow_enter(h_obj, elem->lock(), CHECK);

}

...

IRT_END可以看到如果开启了JVM偏向锁,那会进入到ObjectSynchronizer::fast_enter方法中。

void ObjectSynchronizer::fast_enter(Handle obj, BasicLock* lock, bool attempt_rebias, TRAPS) {

if (UseBiasedLocking) {

if (!SafepointSynchronize::is_at_safepoint()) {

BiasedLocking::Condition cond = BiasedLocking::revoke_and_rebias(obj, attempt_rebias, THREAD);

if (cond == BiasedLocking::BIAS_REVOKED_AND_REBIASED) {

return;

}

} else {

assert(!attempt_rebias, "can not rebias toward VM thread");

BiasedLocking::revoke_at_safepoint(obj);

}

assert(!obj->mark()->has_bias_pattern(), "biases should be revoked by now");

}

slow_enter (obj, lock, THREAD) ;

}如果是正常的Java线程,会走上面的逻辑进入到BiasedLocking::revoke_and_rebias方法,如果是VM线程则会走到下面的BiasedLocking::revoke_at_safepoint。我们主要看BiasedLocking::revoke_and_rebias方法。这个方法的主要作用像它的方法名:撤销或者重偏向,第一个参数封装了锁对象和当前线程,第二个参数代表是否允许重偏向,这里是true。

BiasedLocking::Condition BiasedLocking::revoke_and_rebias(Handle obj, bool attempt_rebias, TRAPS) {

assert(!SafepointSynchronize::is_at_safepoint(), "must not be called while at safepoint");

markOop mark = obj->mark();

if (mark->is_biased_anonymously() && !attempt_rebias) {

//如果是匿名偏向且attempt_rebias==false会走到这里,如锁对象的hashcode方法被调用会出现这种情况,需要撤销偏向锁。

markOop biased_value = mark;

markOop unbiased_prototype = markOopDesc::prototype()->set_age(mark->age());

markOop res_mark = (markOop) Atomic::cmpxchg_ptr(unbiased_prototype, obj->mark_addr(), mark);

if (res_mark == biased_value) {

return BIAS_REVOKED;

}

} else if (mark->has_bias_pattern()) {

// 锁对象开启了偏向模式会走到这里

Klass* k = obj->klass();

markOop prototype_header = k->prototype_header();

//code 1: 如果对应class关闭了偏向模式

if (!prototype_header->has_bias_pattern()) {

markOop biased_value = mark;

markOop res_mark = (markOop) Atomic::cmpxchg_ptr(prototype_header, obj->mark_addr(), mark);

assert(!(*(obj->mark_addr()))->has_bias_pattern(), "even if we raced, should still be revoked");

return BIAS_REVOKED;

//code2: 如果epoch过期

} else if (prototype_header->bias_epoch() != mark->bias_epoch()) {

if (attempt_rebias) {

assert(THREAD->is_Java_thread(), "");

markOop biased_value = mark;

markOop rebiased_prototype = markOopDesc::encode((JavaThread*) THREAD, mark->age(), prototype_header->bias_epoch());

markOop res_mark = (markOop) Atomic::cmpxchg_ptr(rebiased_prototype, obj->mark_addr(), mark);

if (res_mark == biased_value) {

return BIAS_REVOKED_AND_REBIASED;

}

} else {

markOop biased_value = mark;

markOop unbiased_prototype = markOopDesc::prototype()->set_age(mark->age());

markOop res_mark = (markOop) Atomic::cmpxchg_ptr(unbiased_prototype, obj->mark_addr(), mark);

if (res_mark == biased_value) {

return BIAS_REVOKED;

}

}

}

}

//code 3:批量重偏向与批量撤销的逻辑

HeuristicsResult heuristics = update_heuristics(obj(), attempt_rebias);

if (heuristics == HR_NOT_BIASED) {

return NOT_BIASED;

} else if (heuristics == HR_SINGLE_REVOKE) {

//code 4:撤销单个线程

Klass *k = obj->klass();

markOop prototype_header = k->prototype_header();

if (mark->biased_locker() == THREAD &&

prototype_header->bias_epoch() == mark->bias_epoch()) {

// 走到这里说明需要撤销的是偏向当前线程的锁,当调用Object#hashcode方法时会走到这一步

// 因为只要遍历当前线程的栈就好了,所以不需要等到safepoint再撤销。

ResourceMark rm;

if (TraceBiasedLocking) {

tty->print_cr("Revoking bias by walking my own stack:");

}

BiasedLocking::Condition cond = revoke_bias(obj(), false, false, (JavaThread*) THREAD);

((JavaThread*) THREAD)->set_cached_monitor_info(NULL);

assert(cond == BIAS_REVOKED, "why not?");

return cond;

} else {

// 下面代码最终会在VM线程中的safepoint调用revoke_bias方法

VM_RevokeBias revoke(&obj, (JavaThread*) THREAD);

VMThread::execute(&revoke);

return revoke.status_code();

}

}

assert((heuristics == HR_BULK_REVOKE) ||

(heuristics == HR_BULK_REBIAS), "?");

//code5:批量撤销、批量重偏向的逻辑

VM_BulkRevokeBias bulk_revoke(&obj, (JavaThread*) THREAD,

(heuristics == HR_BULK_REBIAS),

attempt_rebias);

VMThread::execute(&bulk_revoke);

return bulk_revoke.status_code();

}

会走到该方法的逻辑有很多,我们只分析最常见的情况:假设锁已经偏向线程A,这时B线程尝试获得锁。

上面的code 1,code 2B线程都不会走到,最终会走到code 4处,如果要撤销的锁偏向的是当前线程则直接调用revoke_bias撤销偏向锁,否则会将该操作push到VM Thread中等到safepoint的时候再执行。

关于VM Thread这里介绍下:在JVM中有个专门的VM Thread,该线程会源源不断的从VMOperationQueue中取出请求,比如GC请求。对于需要safepoint的操作(VM_Operationevaluate_at_safepoint返回true)必须要等到所有的Java线程进入到safepoint才开始执行。 关于safepoint可以参考下这篇文章。

接下来我们着重分析下revoke_bias方法。第一个参数为锁对象,第2、3个参数为都为false

static BiasedLocking::Condition revoke_bias(oop obj, bool allow_rebias, bool is_bulk, JavaThread* requesting_thread) {

markOop mark = obj->mark();

// 如果没有开启偏向模式,则直接返回NOT_BIASED

if (!mark->has_bias_pattern()) {

...

return BiasedLocking::NOT_BIASED;

}

uint age = mark->age();

// 构建两个mark word,一个是匿名偏向模式(101),一个是无锁模式(001)

markOop biased_prototype = markOopDesc::biased_locking_prototype()->set_age(age);

markOop unbiased_prototype = markOopDesc::prototype()->set_age(age);

...

JavaThread* biased_thread = mark->biased_locker();

if (biased_thread == NULL) {

// 匿名偏向。当调用锁对象的hashcode()方法可能会导致走到这个逻辑

// 如果不允许重偏向,则将对象的mark word设置为无锁模式

if (!allow_rebias) {

obj->set_mark(unbiased_prototype);

}

...

return BiasedLocking::BIAS_REVOKED;

}

// code 1:判断偏向线程是否还存活

bool thread_is_alive = false;

// 如果当前线程就是偏向线程

if (requesting_thread == biased_thread) {

thread_is_alive = true;

} else {

// 遍历当前jvm的所有线程,如果能找到,则说明偏向的线程还存活

for (JavaThread* cur_thread = Threads::first(); cur_thread != NULL; cur_thread = cur_thread->next()) {

if (cur_thread == biased_thread) {

thread_is_alive = true;

break;

}

}

}

// 如果偏向的线程已经不存活了

if (!thread_is_alive) {

// 允许重偏向则将对象mark word设置为匿名偏向状态,否则设置为无锁状态

if (allow_rebias) {

obj->set_mark(biased_prototype);

} else {

obj->set_mark(unbiased_prototype);

}

...

return BiasedLocking::BIAS_REVOKED;

}

// 线程还存活则遍历线程栈中所有的Lock Record

GrowableArray<MonitorInfo*>* cached_monitor_info = get_or_compute_monitor_info(biased_thread);

BasicLock* highest_lock = NULL;

for (int i = 0; i < cached_monitor_info->length(); i++) {

MonitorInfo* mon_info = cached_monitor_info->at(i);

// 如果能找到对应的Lock Record说明偏向的线程还在执行同步代码块中的代码

if (mon_info->owner() == obj) {

...

// 需要升级为轻量级锁,直接修改偏向线程栈中的Lock Record。为了处理锁重入的case,在这里将Lock Record的Displaced Mark Word设置为null,第一个Lock Record会在下面的代码中再处理

markOop mark = markOopDesc::encode((BasicLock*) NULL);

highest_lock = mon_info->lock();

highest_lock->set_displaced_header(mark);

} else {

...

}

}

if (highest_lock != NULL) {

// 修改第一个Lock Record为无锁状态,然后将obj的mark word设置为指向该Lock Record的指针

highest_lock->set_displaced_header(unbiased_prototype);

obj->release_set_mark(markOopDesc::encode(highest_lock));

...

} else {

// 走到这里说明偏向线程已经不在同步块中了

...

if (allow_rebias) {

//设置为匿名偏向状态

obj->set_mark(biased_prototype);

} else {

// 将mark word设置为无锁状态

obj->set_mark(unbiased_prototype);

}

}

return BiasedLocking::BIAS_REVOKED;

}需要注意下,当调用锁对象的Object#hash或System.identityHashCode()方法会导致该对象的偏向锁或轻量级锁升级。这是因为在Java中一个对象的hashcode是在调用这两个方法时才生成的,如果是无锁状态则存放在mark word中,如果是重量级锁则存放在对应的monitor中,而偏向锁是没有地方能存放该信息的,所以必须升级。具体可以看这篇文章的hashcode()方法对偏向锁的影响小节(注意:该文中对于偏向锁的加锁描述有些错误),另外我也向该文章作者请教过一些问题,他很热心的回答了我,在此感谢一下!

言归正传,revoke_bias方法逻辑:

monitorenter)的时候都会以从高往低的顺序在栈中找到第一个可用的Lock Record,将其obj字段指向锁对象。每次解锁(即执行monitorexit)的时候都会将最低的一个相关Lock Record移除掉。所以可以通过遍历线程栈中的Lock Record来判断线程是否还在同步块中。Lock Record的Displaced Mark Word设置为null,然后将最高位的Lock Record的Displaced Mark Word 设置为无锁状态,最高位的Lock Record也就是第一次获得锁时的Lock Record(这里的第一次是指重入获取锁时的第一次),然后将对象头指向最高位的Lock Record,这里不需要用CAS指令,因为是在safepoint。 执行完后,就升级成了轻量级锁。原偏向线程的所有Lock Record都已经变成轻量级锁的状态。这里如果看不明白,请回顾上篇文章的轻量级锁加锁过程。偏向锁的释放入口在bytecodeInterpreter.cpp#1923

CASE(_monitorexit): {

oop lockee = STACK_OBJECT(-1);

CHECK_NULL(lockee);

// derefing's lockee ought to provoke implicit null check

// find our monitor slot

BasicObjectLock* limit = istate->monitor_base();

BasicObjectLock* most_recent = (BasicObjectLock*) istate->stack_base();

// 从低往高遍历栈的Lock Record

while (most_recent != limit ) {

// 如果Lock Record关联的是该锁对象

if ((most_recent)->obj() == lockee) {

BasicLock* lock = most_recent->lock();

markOop header = lock->displaced_header();

// 释放Lock Record

most_recent->set_obj(NULL);

// 如果是偏向模式,仅仅释放Lock Record就好了。否则要走轻量级锁or重量级锁的释放流程

if (!lockee->mark()->has_bias_pattern()) {

bool call_vm = UseHeavyMonitors;

// header!=NULL说明不是重入,则需要将Displaced Mark Word CAS到对象头的Mark Word

if (header != NULL || call_vm) {

if (call_vm || Atomic::cmpxchg_ptr(header, lockee->mark_addr(), lock) != lock) {

// CAS失败或者是重量级锁则会走到这里,先将obj还原,然后调用monitorexit方法

most_recent->set_obj(lockee);

CALL_VM(InterpreterRuntime::monitorexit(THREAD, most_recent), handle_exception);

}

}

}

//执行下一条命令

UPDATE_PC_AND_TOS_AND_CONTINUE(1, -1);

}

//处理下一条Lock Record

most_recent++;

}

// Need to throw illegal monitor state exception

CALL_VM(InterpreterRuntime::throw_illegal_monitor_state_exception(THREAD), handle_exception);

ShouldNotReachHere();

}上面的代码结合注释理解起来应该不难,偏向锁的释放很简单,只要将对应Lock Record释放就好了,而轻量级锁则需要将Displaced Mark Word替换到对象头的mark word中。如果CAS失败或者是重量级锁则进入到InterpreterRuntime::monitorexit方法中。该方法会在轻量级与重量级锁的文章中讲解。

批量重偏向和批量撤销的背景可以看上篇文章,相关实现在BiasedLocking::revoke_and_rebias中:

BiasedLocking::Condition BiasedLocking::revoke_and_rebias(Handle obj, bool attempt_rebias, TRAPS) {

...

//code 1:重偏向的逻辑

HeuristicsResult heuristics = update_heuristics(obj(), attempt_rebias);

// 非重偏向的逻辑

...

assert((heuristics == HR_BULK_REVOKE) ||

(heuristics == HR_BULK_REBIAS), "?");

//code 2:批量撤销、批量重偏向的逻辑

VM_BulkRevokeBias bulk_revoke(&obj, (JavaThread*) THREAD,

(heuristics == HR_BULK_REBIAS),

attempt_rebias);

VMThread::execute(&bulk_revoke);

return bulk_revoke.status_code();

}在每次撤销偏向锁的时候都通过update_heuristics方法记录下来,以类为单位,当某个类的对象撤销偏向次数达到一定阈值的时候JVM就认为该类不适合偏向模式或者需要重新偏向另一个对象,update_heuristics就会返回HR_BULK_REVOKE或HR_BULK_REBIAS。进行批量撤销或批量重偏向。

先看update_heuristics方法。

static HeuristicsResult update_heuristics(oop o, bool allow_rebias) {

markOop mark = o->mark();

//如果不是偏向模式直接返回

if (!mark->has_bias_pattern()) {

return HR_NOT_BIASED;

}

// 锁对象的类

Klass* k = o->klass();

// 当前时间

jlong cur_time = os::javaTimeMillis();

// 该类上一次批量撤销的时间

jlong last_bulk_revocation_time = k->last_biased_lock_bulk_revocation_time();

// 该类偏向锁撤销的次数

int revocation_count = k->biased_lock_revocation_count();

// BiasedLockingBulkRebiasThreshold是重偏向阈值(默认20),BiasedLockingBulkRevokeThreshold是批量撤销阈值(默认40),BiasedLockingDecayTime是开启一次新的批量重偏向距离上次批量重偏向的后的延迟时间,默认25000。也就是开启批量重偏向后,经过了一段较长的时间(>=BiasedLockingDecayTime),撤销计数器才超过阈值,那我们会重置计数器。

if ((revocation_count >= BiasedLockingBulkRebiasThreshold) &&

(revocation_count < BiasedLockingBulkRevokeThreshold) &&

(last_bulk_revocation_time != 0) &&

(cur_time - last_bulk_revocation_time >= BiasedLockingDecayTime)) {

// This is the first revocation we've seen in a while of an

// object of this type since the last time we performed a bulk

// rebiasing operation. The application is allocating objects in

// bulk which are biased toward a thread and then handing them

// off to another thread. We can cope with this allocation

// pattern via the bulk rebiasing mechanism so we reset the

// klass's revocation count rather than allow it to increase

// monotonically. If we see the need to perform another bulk

// rebias operation later, we will, and if subsequently we see

// many more revocation operations in a short period of time we

// will completely disable biasing for this type.

k->set_biased_lock_revocation_count(0);

revocation_count = 0;

}

// 自增撤销计数器

if (revocation_count <= BiasedLockingBulkRevokeThreshold) {

revocation_count = k->atomic_incr_biased_lock_revocation_count();

}

// 如果达到批量撤销阈值则返回HR_BULK_REVOKE

if (revocation_count == BiasedLockingBulkRevokeThreshold) {

return HR_BULK_REVOKE;

}

// 如果达到批量重偏向阈值则返回HR_BULK_REBIAS

if (revocation_count == BiasedLockingBulkRebiasThreshold) {

return HR_BULK_REBIAS;

}

// 没有达到阈值则撤销单个对象的锁

return HR_SINGLE_REVOKE;

}当达到阈值的时候就会通过VM 线程在safepoint调用bulk_revoke_or_rebias_at_safepoint, 参数bulk_rebias如果是true代表是批量重偏向否则为批量撤销。attempt_rebias_of_object代表对操作的锁对象o是否运行重偏向,这里是true。

static BiasedLocking::Condition bulk_revoke_or_rebias_at_safepoint(oop o,

bool bulk_rebias,

bool attempt_rebias_of_object,

JavaThread* requesting_thread) {

...

jlong cur_time = os::javaTimeMillis();

o->klass()->set_last_biased_lock_bulk_revocation_time(cur_time);

Klass* k_o = o->klass();

Klass* klass = k_o;

if (bulk_rebias) {

// 批量重偏向的逻辑

if (klass->prototype_header()->has_bias_pattern()) {

// 自增前类中的的epoch

int prev_epoch = klass->prototype_header()->bias_epoch();

// code 1:类中的epoch自增

klass->set_prototype_header(klass->prototype_header()->incr_bias_epoch());

int cur_epoch = klass->prototype_header()->bias_epoch();

// code 2:遍历所有线程的栈,更新类型为该klass的所有锁实例的epoch

for (JavaThread* thr = Threads::first(); thr != NULL; thr = thr->next()) {

GrowableArray<MonitorInfo*>* cached_monitor_info = get_or_compute_monitor_info(thr);

for (int i = 0; i < cached_monitor_info->length(); i++) {

MonitorInfo* mon_info = cached_monitor_info->at(i);

oop owner = mon_info->owner();

markOop mark = owner->mark();

if ((owner->klass() == k_o) && mark->has_bias_pattern()) {

// We might have encountered this object already in the case of recursive locking

assert(mark->bias_epoch() == prev_epoch || mark->bias_epoch() == cur_epoch, "error in bias epoch adjustment");

owner->set_mark(mark->set_bias_epoch(cur_epoch));

}

}

}

}

// 接下来对当前锁对象进行重偏向

revoke_bias(o, attempt_rebias_of_object && klass->prototype_header()->has_bias_pattern(), true, requesting_thread);

} else {

...

// code 3:批量撤销的逻辑,将类中的偏向标记关闭,markOopDesc::prototype()返回的是一个关闭偏向模式的prototype

klass->set_prototype_header(markOopDesc::prototype());

// code 4:遍历所有线程的栈,撤销该类所有锁的偏向

for (JavaThread* thr = Threads::first(); thr != NULL; thr = thr->next()) {

GrowableArray<MonitorInfo*>* cached_monitor_info = get_or_compute_monitor_info(thr);

for (int i = 0; i < cached_monitor_info->length(); i++) {

MonitorInfo* mon_info = cached_monitor_info->at(i);

oop owner = mon_info->owner();

markOop mark = owner->mark();

if ((owner->klass() == k_o) && mark->has_bias_pattern()) {

revoke_bias(owner, false, true, requesting_thread);

}

}

}

// 撤销当前锁对象的偏向模式

revoke_bias(o, false, true, requesting_thread);

}

...

BiasedLocking::Condition status_code = BiasedLocking::BIAS_REVOKED;

if (attempt_rebias_of_object &&

o->mark()->has_bias_pattern() &&

klass->prototype_header()->has_bias_pattern()) {

// 构造一个偏向请求线程的mark word

markOop new_mark = markOopDesc::encode(requesting_thread, o->mark()->age(),

klass->prototype_header()->bias_epoch());

// 更新当前锁对象的mark word

o->set_mark(new_mark);

status_code = BiasedLocking::BIAS_REVOKED_AND_REBIASED;

...

}

...

return status_code;

}

该方法分为两个逻辑:批量重偏向和批量撤销。

先看批量重偏向,分为两步:

code 1 将类中的撤销计数器自增1,之后当该类已存在的实例获得锁时,就会尝试重偏向,相关逻辑在偏向锁获取流程小节中。

code 2 处理当前正在被使用的锁对象,通过遍历所有存活线程的栈,找到所有正在使用的偏向锁对象,然后更新它们的epoch值。也就是说不会重偏向正在使用的锁,否则会破坏锁的线程安全性。

批量撤销逻辑如下:

code 3将类的偏向标记关闭,之后当该类已存在的实例获得锁时,就会升级为轻量级锁;该类新分配的对象的mark word则是无锁模式。

code 4处理当前正在被使用的锁对象,通过遍历所有存活线程的栈,找到所有正在使用的偏向锁对象,然后撤销偏向锁。

如果一个线程在同步块中调用了Object#wait方法, 会将该线程对应的ObjectWaiter从EntryList移除并加入到WaitSet中,然后释放锁。当wait的线程被notify之后,会将对应的ObjectWaiter从WaitSet移动到EntryList中。

个人理解是:wait调用必须在synchronized代码块里。在synchronized进入时候,就已经将ObjectWaiter从EntryList移除;所以当发生wait调用的时候,应该是直接将ObjectWaiter对象加入到WaitSet,然后释放锁,并没有从EntryList移除这一步。

前一篇文章提到了限流的几种常见算法,本文将分析guava限流类RateLimiter的实现。

RateLimiter有两个实现类:SmoothBursty和SmoothWarmingUp,其都是令牌桶算法的变种实现,区别在于SmoothBursty加令牌的速度是恒定的,而SmoothWarmingUp会有个预热期,在预热期内加令牌的速度是慢慢增加的,直到达到固定速度为止。其适用场景是,对于有的系统而言刚启动时能承受的QPS较小,需要预热一段时间后才能达到最佳状态。

更多文章见个人博客:https://github.com/farmerjohngit/myblog

RateLimiter的使用很简单:

//create方法传入的是每秒生成令牌的个数

RateLimiter rateLimiter= RateLimiter.create(1);

for (int i = 0; i < 5; i++) {

//acquire方法传入的是需要的令牌个数,当令牌不足时会进行等待,该方法返回的是等待的时间

double waitTime=rateLimiter.acquire(1);

System.out.println(System.currentTimeMillis()/1000+" , "+waitTime);

}输出如下:

1548070953 , 0.0

1548070954 , 0.998356

1548070955 , 0.998136

1548070956 , 0.99982需要注意的是,当令牌不足时,acquire方法并不会阻塞本次调用,而是会算在下次调用的头上。比如第一次调用时,令牌桶中并没有令牌,但是第一次调用也没有阻塞,而是在第二次调用的时候阻塞了1秒。也就是说,每次调用欠的令牌(如果桶中令牌不足)都是让下一次调用买单。

RateLimiter rateLimiter= RateLimiter.create(1);

double waitTime=rateLimiter.acquire(1000);

System.out.println(System.currentTimeMillis()/1000+" , "+waitTime);

waitTime=rateLimiter.acquire(1);

System.out.println(System.currentTimeMillis()/1000+" , "+waitTime);输出如下:

1548072250 , 0.0

1548073250 , 999.998773

这样设计的目的是:

Last, but not least: consider a RateLimiter with rate of 1 permit per second, currently completely unused, and an expensive acquire(100) request comes. It would be nonsensical to just wait for 100 seconds, and /then/ start the actual task. Why wait without doing anything? A much better approach is to /allow/ the request right away (as if it was an acquire(1) request instead), and postpone /subsequent/ requests as needed. In this version, we allow starting the task immediately, and postpone by 100 seconds future requests, thus we allow for work to get done in the meantime instead of waiting idly.

简单的说就是,如果每次请求都为本次买单会有不必要的等待。比如说令牌增加的速度为每秒1个,初始时桶中没有令牌,这时来了个请求需要100个令牌,那需要等待100s后才能开始这个任务。所以更好的办法是先放行这个请求,然后延迟之后的请求。

另外,RateLimiter还有个tryAcquire方法,如果令牌够会立即返回true,否则立即返回false。

本文主要分析SmoothBursty的实现。

首先看SmoothBursty中的几个关键字段:

// 桶中最多存放多少秒的令牌数

final double maxBurstSeconds;

//桶中的令牌个数

double storedPermits;

//桶中最多能存放多少个令牌,=maxBurstSeconds*每秒生成令牌个数

double maxPermits;

//加入令牌的平均间隔,单位为微秒,如果加入令牌速度为每秒5个,则该值为1000*1000/5

double stableIntervalMicros;

//下一个请求需要等待的时间

private long nextFreeTicketMicros = 0L; 先看创建RateLimiter的create方法。

// permitsPerSecond为每秒生成的令牌数

public static RateLimiter create(double permitsPerSecond) {

return create(permitsPerSecond, SleepingStopwatch.createFromSystemTimer());

}

//SleepingStopwatch主要用于计时和休眠

static RateLimiter create(double permitsPerSecond, SleepingStopwatch stopwatch) {

//创建一个SmoothBursty

RateLimiter rateLimiter = new SmoothBursty(stopwatch, 1.0 /* maxBurstSeconds */);

rateLimiter.setRate(permitsPerSecond);

return rateLimiter;

}create方法主要就是创建了一个SmoothBursty实例,并调用了其setRate方法。注意这里的maxBurstSeconds写死为1.0。

@Override

final void doSetRate(double permitsPerSecond, long nowMicros) {

resync(nowMicros);

double stableIntervalMicros = SECONDS.toMicros(1L) / permitsPerSecond;

this.stableIntervalMicros = stableIntervalMicros;

doSetRate(permitsPerSecond, stableIntervalMicros);

}

void resync(long nowMicros) {

// 如果当前时间比nextFreeTicketMicros大,说明上一个请求欠的令牌已经补充好了,本次请求不用等待

if (nowMicros > nextFreeTicketMicros) {

// 计算这段时间内需要补充的令牌,coolDownIntervalMicros返回的是stableIntervalMicros

double newPermits = (nowMicros - nextFreeTicketMicros) / coolDownIntervalMicros();

// 更新桶中的令牌,不能超过maxPermits

storedPermits = min(maxPermits, storedPermits + newPermits);

// 这里先设置为nowMicros

nextFreeTicketMicros = nowMicros;

}

}

@Override

void doSetRate(double permitsPerSecond, double stableIntervalMicros) {

double oldMaxPermits = this.maxPermits;

maxPermits = maxBurstSeconds * permitsPerSecond;

if (oldMaxPermits == Double.POSITIVE_INFINITY) {

// if we don't special-case this, we would get storedPermits == NaN, below

storedPermits = maxPermits;

} else {

//第一次调用oldMaxPermits为0,所以storedPermits(桶中令牌个数)也为0

storedPermits =

(oldMaxPermits == 0.0)

? 0.0 // initial state

: storedPermits * maxPermits / oldMaxPermits;

}

}setRate方法中设置了maxPermits=maxBurstSeconds * permitsPerSecond;而maxBurstSeconds 为1,所以maxBurstSeconds 只会保存1秒中的令牌数。

需要注意的是SmoothBursty是非public的类,也就是说只能通过RateLimiter.create方法创建,而该方法中的maxBurstSeconds 是写死1.0的,也就是说我们只能创建桶大小为permitsPerSecond*1的SmoothBursty对象(当然反射的方式不在讨论范围),在guava的github仓库里有好几条issue(issue1,issue2,issue3,issue4)希望能由外部设置maxBurstSeconds ,但是并没有看到官方人员的回复。而在唯品会的开源项目vjtools中,有人提出了这个问题,唯品会的同学对guava的RateLimiter进行了拓展。

对于guava的这样设计我很不理解,有清楚的朋友可以说下~

到此为止一个SmoothBursty对象就创建好了,接下来我们分析其acquire方法。

public double acquire(int permits) {

// 计算本次请求需要休眠多久(受上次请求影响)

long microsToWait = reserve(permits);

// 开始休眠

stopwatch.sleepMicrosUninterruptibly(microsToWait);

return 1.0 * microsToWait / SECONDS.toMicros(1L);

}

final long reserve(int permits) {

checkPermits(permits);

synchronized (mutex()) {

return reserveAndGetWaitLength(permits, stopwatch.readMicros());

}

}

final long reserveAndGetWaitLength(int permits, long nowMicros) {

long momentAvailable = reserveEarliestAvailable(permits, nowMicros);

return max(momentAvailable - nowMicros, 0);

}

final long reserveEarliestAvailable(int requiredPermits, long nowMicros) {

// 这里调用了上面提到的resync方法,可能会更新桶中的令牌值和nextFreeTicketMicros

resync(nowMicros);

// 如果上次请求花费的令牌还没有补齐,这里returnValue为上一次请求后需要等待的时间,否则为nowMicros

long returnValue = nextFreeTicketMicros;

double storedPermitsToSpend = min(requiredPermits, this.storedPermits);

// 缺少的令牌数

double freshPermits = requiredPermits - storedPermitsToSpend;

// waitMicros为下一次请求需要等待的时间;SmoothBursty的storedPermitsToWaitTime返回0

long waitMicros =

storedPermitsToWaitTime(this.storedPermits, storedPermitsToSpend)

+ (long) (freshPermits * stableIntervalMicros);

// 更新nextFreeTicketMicros

this.nextFreeTicketMicros = LongMath.saturatedAdd(nextFreeTicketMicros, waitMicros);

// 减少令牌

this.storedPermits -= storedPermitsToSpend;

return returnValue;

}acquire中会调用reserve方法获得当前请求需要等待的时间,然后进行休眠。reserve方法最终会调用到reserveEarliestAvailable,在该方法中会先调用上文提到的resync方法对桶中的令牌进行补充(如果需要的话),然后减少桶中的令牌,以及计算这次请求欠的令牌数及需要等待的时间(由下次请求负责等待)。

如果上一次请求没有欠令牌或欠的令牌已经还清则返回值为nowMicros,否则返回值为上一次请求缺少的令牌个数*生成一个令牌所需要的时间。

本文讲解了RateLimiter子类SmoothBursty的源码,对于另一个子类SmoothWarmingUp的原理大家可以自行分析。相对于传统意义上的令牌桶,RateLimiter的实现还是略有不同,主要体现在一次请求的花费由下一次请求来承担这一点上。

本文为分布式Redis深度历险系列的第二篇,主要内容为Redis的Sentinel功能。

更多文章见个人博客:https://github.com/farmerjohngit/myblog

上一篇介绍了Redis的主从服务器之间是如何同步数据的。试想下,在一主一从或一主多从的结构下,如果主服务器挂了,整个集群就不可用了,单点问题并没有解决。Redis使用Sentinel解决该问题,保障集群的高可用。

保障集群高可用,要具备如下能力:

要实现上述功能,最直观的做法就是,使用一台监控服务器来监视Redis

服务器的状态。

监控服务器和主从服务器间维护一个心跳连接,当超出一定时间没有收到主服务器心跳时,主服务器就会被标记为下线,然后通知从服务器上线成为主服务器。

按照上述流程似乎解决了集群高可用的问题,但似乎有哪里不对:如果监控服务器出了问题怎么办?我们可以在加上一个从监控服务器,当主服务器不可用的时候顶上。

但问题是谁来监控'监控服务器'呢?子子孙孙无穷尽也。。

先把疑问放在一旁,先来看下Redis Sentinel集群的实现

和上一小节的想法一样,Redis通过增加额外的Sentinel服务器来监控数据服务器,Sentinel会与所有的主服务器和从服务器保存连接,用以监听服务器状态以及向服务器下达命令。

Sentinel本身是一个特殊状态的Redis服务器,启动命令:

redis-server /xxx/sentinel.conf --sentinel,sentinel模式下的启动流程与普通redis server是不一样的,比如说不会去加载RDB文件以及AOF文件,本身也不会存储业务数据。

Sentinel启动后,会与配置文件中提供的所有主服务器建立两个连接,一个是命令连接,一个是订阅连接。

命令连接用于向服务器发送命令。

订阅连接则是用于订阅服务器的_sentinel_:hello频道,用于获取其他Sentinel信息,下文会详细说。

Sentinel会以一定频率向主服务器发送Info命令获取信息,包括主服务器自身的信息比如说服务器id等,以及对应的从服务器信息,包括ip和port。Sentinel会根据info命令返回的信息更新自己保存的服务器信息,并会与从服务器建立连接。

与和主服务器的交互相似,Sentinel也会以一定频率通过Info命令获取从服务器信息,包括:从服务器ID,从服务器与主服务器的连接状态,从服务器的优先级,从服务器的复制偏移等等。

在如何保障集群高可用小节留下了一个疑问:用如何保证监视服务器的高可用? 在这里我们可以先给出简单回答:用一个监视服务器集群(也就是Sentinel集群)。如何实现,如何保证监视服务器的一致性暂且先不说,我们只要记住需要用若干台Sentinel来保障高可用,那一个Sentinel是如何感知其他的Sentinel的呢?

前面说过,Sentinel在与服务器建立连接时,会建立两个连接,其中一个是订阅连接。Sentinel会定时的通过订阅连接向_sentinel_:hello频道频道发送消息(对Redis发布订阅功能不太了解的同学可以去去了解下),其中包括:

同时,Sentinel也会订阅_sentinel_:hello频道的消息,也就是说Sentinel即向该频道发布消息,又从该频道订阅消息。

Sentinel有一个字典对象sentinels,保存着监视同一主服务器的其他所有Sentinel服务器,当一个Sentinel接收到来自_sentinel_:hello频道的消息时,会先比较发送该消息的是不是自己,如果是则忽略,否则将更新sentinels中的内容,并对新的Sentinel建立连接。

Sentinel默认会以每秒一次的频率向所有建立连接的服务器(主服务器,从服务器,Sentinel服务器)发送PING命令,如果在down-after-milliseconds内都没有收到有效回复,Sentinel会将该服务器标记为主观下线,代表该Sentinel认为这台服务器已经下线了。需要注意的是不同Sentinel的down-after-milliseconds是可以不同的。

为了确保服务器真的已经下线,当Sentinel将某个服务器标记为主观下线后,它会向其他的Sentinel实例发送Sentinel is-master-down-by-addr命令,接收到该命令的Sentinel实例会回复主服务器的状态,代表该Sentinel对该主服务器的连接情况。

Sentinel会统计发出的所有Sentinel is-master-down-by-addr命令的回复,并统计同意将主服务器下线的数量,如果该数量超出了某个阈值,就会将该主服务器标记为客观下线。

当Sentinel将一个主服务器标记为客观下线后,监视该服务器的各个Sentinel会通过Raft算法进行协商,选举出一个领头的Sentinel。

建议你先看Raft算法的基础知识,再来看下文。

规则:

还记得我们在文章开头提出的如何保证Redis服务器高可用的问题吗?

答案就是使用若干台Sentinel服务器,通过Raft一致性算法来保障集群的高可用,只要Sentinel服务器有一半以上的节点都正常,那集群就是可用的。

领头Sentinel将会进行以下3个步骤进行故障转移:

1.在已下线主服务器的所有从服务器中,挑选出一个作为新的主服务器

2.将其他从服务器的主服务器设置成新的

3.将已下线的主服务器的role改成从服务器,并将其主服务器设置成新的,当该服务器重新上线后,就会一个从服务器的角色继续工作

第一步中挑选新的主服务器的规则如下:

1.过滤掉所有已下线的从服务器

2.过滤掉最近5秒没有回复过Sentinel命令的从服务器

3.过滤掉与原主服务器断开时间超过down-after-milliseconds*10的从服务器

4.根据从服务器的优先级进行排序,选择优先级最高的那个

5.如果有多个从服务器优先级相同,则选取复制偏移量最大的那个

6.如果上一步的服务器还有多个,则选取id最小的那个

hotspot/src/share/vm/interpreter/bytecodeInterpreter.cpp:

CASE(_monitorenter) : {

oop lockee = STACK_OBJECT(-1);

// derefing's lockee ought to provoke implicit null check

CHECK_NULL(lockee);

// find a free monitor or one already allocated for this object

// if we find a matching object then we need a new monitor

// since this is recursive enter

BasicObjectLock *limit = istate->monitor_base();

BasicObjectLock *most_recent = (BasicObjectLock *)istate->stack_base();

BasicObjectLock *entry = NULL;

while (most_recent != limit) {

if (most_recent->obj() == NULL)

entry = most_recent;

else if (most_recent->obj() == lockee)

break;

most_recent++;

}

if (entry != NULL) {

entry->set_obj(lockee);

int success = false;

uintptr_t epoch_mask_in_place =

(uintptr_t)markOopDesc::epoch_mask_in_place;

markOop mark = lockee->mark();

intptr_t hash = (intptr_t)markOopDesc::no_hash;

// 余下代码省略本文为分布式Redis深度历险系列的第三篇,主要内容为Redis的Cluster,也就是Redis集群功能。

更多文章见个人博客:https://github.com/farmerjohngit/myblog

Redis集群是Redis官方提供的分布式方案,整个集群通过将所有数据分成16384个槽来进行数据共享。

一个集群由多个Redis节点组成,不同的节点通过CLUSTER MEET命令进行连接:

CLUSTER MEET <ip> <port>

收到命令的节点会与命令中指定的目标节点进行握手,握手成功后目标节点会加入到集群中,看个例子,图片来自于Redis的设计与实现:

一个集群的所有数据被分为16384个槽,可以通过CLUSTER ADDSLOTS命令将槽指派给对应的节点。当所有的槽都有节点负责时,集群处于上线状态,否则处于下线状态不对外提供服务。

clusterNode的位数组slots代表一个节点负责的槽信息。

struct clusterNode {

unsigned char slots[16384/8]; /* slots handled by this node */

int numslots; /* Number of slots handled by this node */

...

}

看个例子,下图中1、3、5、8、9、10位的值为1,代表该节点负责槽1、3、5、8、9、10。

每个Redis Server上都有一个ClusterState的对象,代表了该Server所在集群的信息,其中字段slots记录了集群中所有节点负责的槽信息。

typedef struct clusterState {

// 负责处理各个槽的节点

// 例如 slots[i] = clusterNode_A 表示槽 i 由节点 A 处理

// slots[i] = null 代表该槽目前没有节点负责

clusterNode *slots[REDIS_CLUSTER_SLOTS];

}

可以通过redis-trib工具对槽重新分配,重分配的实现步骤如下:

CLUSTER GETKEYSINSLOT <slot> <count>从源节点获取最多count个槽slot的keyMIGRATE <target_ip> <target_port> <key_name> 0 <timeout> 命令,将被选中的键原子的从源节点迁移至目标节点。在槽重分配的过程中,槽中的一部分数据保存着源节点,另一部分保存在目标节点。这时如果要客户端向源节点发送一个命令,且相关数据在一个正在迁移槽中,源节点处理步骤如图:

当客户端收到一个ASK错误的时候,会根据返回的信息向目标节点重新发起一次请求。

ASK和MOVED的区别主要是ASK是一次性的,MOVED是永久性的,有点像Http协议中的301和302。

我们来看cluster下一次命令的请求过程,假设执行命令 get testKey

cluster client在运行前需要配置若干个server节点的ip和port。我们称这些节点为种子节点。

cluster的客户端在执行命令时,会先通过计算得到key的槽信息,计算规则为:getCRC16(key) & (16384 - 1),得到槽信息后,会从一个缓存map中获得槽对应的redis server信息,如果能获取到,则调到第4步

向种子节点发送slots命令以获得整个集群的槽分布信息,然后跳转到第2步重试命令

客户端如果收到MOVED错误,则根据对应的地址跳转到第4步重新请求,

客户段如果收到ASK错误,则根据对应的地址跳转到第4步重新请求,并在请求前带上ASKING标识。

以上步骤大致就是redis cluster下一次命令请求的过程,但忽略了一个细节,如果要查找的数据锁所在的槽正在重分配怎么办?

集群中每个Redis节点都会定期的向集群中的其他节点发送PING消息,如果目标节点没有在有效时间内回复PONG消息,则会被标记为疑似下线。同时将该信息发送给其他节点。当一个集群中有半数负责处理槽的主节点都将某个节点A标记为疑似下线后,那么A会被标记为已下线,将A标记为已下线的节点会将该信息发送给其他节点。

比如说有A,B,C,D,E 5个主节点。E有F、G两个从节点。

当E节点发生异常后,其他节点发送给A的PING消息将不能得到正常回复。当过了最大超时时间后,假设A,B先将E标记为疑似下线;之后C也会将E标记为疑似下线,这时C发现集群中由3个节点(A、B、C)都将E标记为疑似下线,超过集群复制槽的主节点个数的一半(>2.5)则会将E标记为已下线,并向集群广播E下线的消息。

当F、G(E的从节点)收到E被标记已下线的消息后,会根据Raft算法选举出一个新的主节点,新的主节点会将E复制的所有槽指派给自己,然后向集群广播消息,通知其他节点新的主节点信息。

选举新的主节点算法与选举Sentinel头节点的过程很像:

集群的配置纪元是一个自增计数器,它的初始值为0.

当集群里的某个节点开始一次故障转移操作时,集群配置纪元的值会被增一。

对于每个配置纪元,集群里每个负责处理槽的主节点都有一次投票的机会,而第一个向主节点要求投票的从节点将获得主节点的投票。

档从节点发现自己正在复制的主节点进入已下线状态时,从节点会想集群广播一条CLUSTER_TYPE_FAILOVER_AUTH_REQUEST消息,要求所有接收到这条消息、并且具有投票权的主节点向这个从节点投票。

如果一个主节点具有投票权(它正在负责处理槽),并且这个主节点尚未投票给其他从节点,那么主节点将向要求投票的从节点返回一条CLUSTERMSG_TYPE_FAILOVER_AUTH_ACK消息,表示这个主节点支持从节点成为新的主节点。

每个参与选举的从节点都会接收CLUSTERMSG_TYPE_FAILOVER_AUTH_ACK消息,并根据自己收到了多少条这种消息来同济自己获得了多少主节点的支持。

如果集群里有N个具有投票权的主节点,那么当一个从节点收集到大于等于N/2+1张支持票时,这个从节点就会当选为新的主节点。

因为在每一个配置纪元里面,每个具有投票权的主节点只能投一次票,所以如果有N个主节点进行投票,那么具有大于等于N/2+1张支持票的从节点只会有一个,这确保了新的主节点只会有一个。

如果在一个配置纪元里面没有从节点能收集到足够多的支持票,那么集群进入一个新的配置纪元,并再次进行选举,知道选出新的主节点为止。

最后,聊聊redis集群的其他两种实现方案。

客户端做路由,采用一致性hash算法,将key映射到对应的redis节点上。

其优点是实现简单,没有引用其他中间件。

缺点也很明显:是一种静态分片方案,扩容性差。

Jedis中的ShardedJedis是该方案的实现。

该方案在client与redis之间引入一个代理层。client的所有操作都发送给代理层,由代理层实现路由转发给不同的redis服务器。

其优点是: 路由规则可自定义,扩容方便。

缺点是: 代理层有单点问题,多一层转发的网络开销

其开源实现有twitter的twemproxy

和豌豆荚的codis

分布式redis深度历险系列到此为止了,之后一个系列会详细讲讲单机Redis的实现,包括Redis的底层数据结构、对内存占用的优化、基于事件的处理机制、持久化的实现等等偏底层的内容,敬请期待~

一句话介绍,垃圾回收就是由程序自动的回收已死对象。

已死对象就是程序中一定不会再被使用到的对象。

垃圾回收可以分为两个部分,一是如何判断对象已死,二是如何清理掉已死对象。

引用计数法比较好理解,就是为每个对象分配一个计数器,当一个对象被另一个对象引用时,其对应的计数器+1,当引用关系被解除时,计数器-1。当一个对象的计数器值为0时,则代表该对象可以被回收了。

引用计数法的优点是实现简单且回收效率高,而缺点就是无法解决循环引用的问题。

引用计数法在Python等一些语言中有使用到,但jvm并没有采用,关键原因也是其无法解决循环引用的问题(那python的循环引用对象不能被回收?)。

可达性分析是商用jvm中采用的判断对象已死算法。

该算法类似于图遍历,我们把所有对象描述为一张图,节点是对象,边是引用关系。

从GC ROOT节点出发,遍历所有节点,对于遍历到的每个节点都做一个标识,遍历完成后。没有标识的节点说明是可回收的。

这里的GC ROOT在JVM中指的是以下几类对象:

上一节介绍了垃圾回收第一步:判断对象是否可以被回收,这一小节则会阐述一些常用的回收算法。

标记清除算法也比较简单。通常使用一张表(类似)来记录哪些空间已被使用。首先通过可达性分析找到所有的垃圾,然后将其占用的空间释放掉。

该算法的问题是可能会产生大量的内存碎片。

为了解决内存碎片的问题,标记整理在标记清楚算法上做了优化,在找到所有垃圾对象后,不是直接释放掉其占用的空间,而是将所有存活对象往内存一端移动。回收完成后,所有对象都是相邻的。

复制算法将内存区域划分为两个,同一时间只有一个区域有对象,每次垃圾回收时,通过可达性分析算法,找出所有存活对象,将这些存活对象移动到另一区域。为新对象分配内存时,可以通过智能指针的形式,高效简单。

复制算法的缺点是会浪费一部分空间以便存放下次回收后存活的对象且需要一块额外的空间进行担保(当一个区域存放不下存活的对象时)。

在商用jvm中,大多使用的是分代收集算法。

根据对象的特性,可以将内存划分为3个代:年轻代,老年代,永久代(jvm8后称为元空间)。年轻代存放新分配的对象,使用的是复制算法,老年代使用标记清除or标记整理算法。其中年轻代分为一个Eden区和两个Survivor区,其比例默认为8:1:1(-XX:SurvivorRatio),新对象在Eden区分配,当Eden区存放不下时,触发一次Young GC,将Eden区和一个Survivor区域的所有存活对象拷贝到另一个Survivor区域。如果对象大小超过一定大小(-XX:PretenureSizeThreshold),则会直接在老年代分配。老年代采用标记清除或标记整理算法。

年轻代老年代比例默认为3:8(-XX:NewRatio,-Xmn),老年代一般来说要比年轻代要大,因为当年轻代空间不足以存放下新对象时,需要老年代来担保。

年轻代使用复制算法的原因是年轻代对象的创建和回收很频繁,同时大部分对象很快都会死亡,所以复制算法创建和回收对象的效率都比较高。

老年代不使用复制算法的原因是老年代对象通常存活时间比较长,如果采用复制算法,则复制存活对象的开销会比较大,且复制算法是需要其他区域担保的。 所以老年代不使用复制算法。

下文将介绍jvm中常用的垃圾回收器

使用单线程,复制算法实现。在回收的整个过程中需要Stop The World。在单核cpu 的机器上,使用单线程进行垃圾回收效率更高。

使用方法:-XX:+UseSerialGC

ps:在jdk client模式,不指定VM参数,默认是串行垃圾回收器

与Serial相似,但使用标记整理算法实现。

Serial的多线程形式,

-XX:+UseParNewGC(新生代使用并行收集器,老年代使用串行回收收集器)或者-XX:+UseConcMarkSweepGC(新生代使用并行收集器,老年代使用CMS)。

多线程的回收器,高吞吐量(=程序运行时间/(程序运行时间+回收器运行时间)),可以高效率的利用CPU时间,尽快完成程序的运算任务,适合后台应用等对响应时间要求不高的场景。

有一个自适应条件参数(-XX:+UseAdaptiveSizePolicy),当这个参数打开后,无需手动指定新生代大小(-Xmn),Eden和Survivor比例(-XX:SurvivorRatio)等参数,虚拟机会动态调节这些参数来选择最适合的停顿时间(-XX:MaxGCPauseMillis)或吞吐量( -XX:GCTimeRatio)。

Parallel Scavenge是Server级别多CPU机器上的默认GC方式,也可以通过-XX:+UseParallelGC来指定,并且可以采用-XX:ParallelGCThread来指定线程数。

Parallel Scavenge对应的老年代收集器只有Serial Old和Parallel Old。不能与CMS搭配使用的原因是,其使用的框架不同,并不是技术原因。

使用多线程和“标记-整理”算法。与Parallen Scavenge相似,只不过是运用于老年代。

基于标记清除算法实现,关注GC的暂停时间,在注重响应时间的应用上使用。

在说CMS具体步骤前,我们先看下CMS使用的垃圾标记算法:三色标记法

将堆中对象分为3个集合:白色、灰色和黑色

白色集合:需要被回收的对象

黑色集合:没有引用白色集合中的对象,且从GC ROOT可达。该集合的对象是不会被回收的

灰色集合:从根可达但是还没有扫描完其引用的所有对象,该集合的对象不会被回收,且当其引用的白色对象全部被扫描后,会将其加入到黑色集合中。

一般来说,会将被GC ROOT直接引用到的对象初始化到灰色集合,其余所有对象初始化到白色集合,然后开始执行算法:

1.将一个灰色对象加入到黑色集合

2.将其引用到的所有白色对象加入到灰色集合

3.重复上述两步,直到灰色集合为空

该算法保证从GC ROOT出发,所有没有被引用到的对象都在白色集合中,所以最后白色集合中的所有对象就是要回收的对象

分为4个过程,初始标记,并发标记,重新标记,并发清理。

初始标记:

从GC ROOT出发,找到所有被GC ROOT直接引用的节点。此过程需要Stop The World。

并发标记:

以上一步骤的节点为根节点,并发的遍历所有节点。同时会开启Write Barrier.如果在此过程中存在黑色对象增加对白色对象的引用,则会记录下来。

在这里,我们试想下如果三色标记法是先执行步骤2后执行步骤1(上面三色标记算法的步骤),会发生什么?

如下图,在GC过程中,用三色标记法遍历到A这个对象(图1),将A引用到的BCD标记为灰色。之后,在应用程序线程中创建了一个对象E,A引用了它( 图2这个阶段GC是并发标记的)。然后将A标记为黑色(图3)。在gc扫描结束后,E这个对象因为是白色的,所以将被回收掉。这显然是不能接受的,并发垃圾回收器的底线是允许一部分垃圾暂时不回收(见下面的浮动垃圾),但绝不允许从根可达的存活对象被当作垃圾处理掉!

重新标记:

因为并发标记的过程中可能有引用关系的变化,所以该阶段需要Stop The World。以GC ROOT,Writter Barrier中记录的对象为根节点,重新遍历。

这里为什么还需要再遍历GC ROOT?因为Writter Barrier是作用在堆上的,无法感知到GC ROOT上引用关系的变更。

并发清理:

并发的清理所有垃圾对象

CMS通过将步骤拆分,实现了降低STW时间的目的。但CMS也会有以下问题:

1.浮动垃圾,在并发标记的过程中(及之后阶段),可能存在原来被引用的对象变成无人引用了,而在这次gc是发现不会清理这些对象的。

2.cpu敏感,因为用户程序是和GC线程同时运行的,所以会导致GC的过程中程序运行变慢,gc运行时间增长,吞吐量降低。默认回收线程是(CPU数量+3)/4,也就是cpu不足4个时,会有一半的cpu资源给GC线程。

3.空间碎片,标记清除算法都有的问题。当碎片过多时,为大对象分配内存空间就会很麻烦,有时候就是老年代空间有大量空间剩余,但没有连续的大空间来分配当前对象,不得不提前触发full gc。CMS提供一个参数(-XX:+UseCMSCompactAtFullCollection),在Full Gc发生时开启内存合并整理。这个过程是STW的。同时还可以通过参数(-XX:CMSFullGCsBeforeCom-paction)来这只执行多少次不压缩的Full GC后,来一次压缩的。

4.需要更大的内存空间,因为是同时运行的GC和用户程序,所以不能像其他老年代收集器一样,等老年代满了再触发GC,而是要预留一定的空间。CMS可以配置当老年代使用率到达某个阈值时( -XX:CMSInitiatingOccupancyFraction=80 ),开始CMS GC。

在old GC运行的过程中,可能有大量对象从年轻代晋升,而出现老年代存放不下的问题(因为这个时候垃圾还没被回收掉),该问题叫Concurrent Model Failure,这时候会启用Serial Old收集器,重新回收整个老年代。Concurrent Model Failure一般伴随着ParNew promotion failed(晋升担保失败),解决这个问题的办法就是可以让CMS在进行一定次数的Full GC(标记清除)的时候进行一次标记整理算法,或者降低触发cms gc的阈值

讲实话,我还没太看懂,没法写自己的理解,

少年等我。。

本人两年开发经验、18年年底开始跑路找工作,在互联网寒冬下成功拿到阿里巴巴、今日头条、滴滴等公司offer,岗位是Java后端开发,最终选择去了阿里巴巴。

面试了很多家公司,感觉大部分公司考察的点都差不多,所以将自己的心得记下来,希望能给正在找或者准备找工作的朋友提供一点帮助。另外,目前在阿里也做面试官的工作,身份从求职者变为面试官,看问题的很多角度也不一样,所以下文中既有求职者的视角,也有面试官的视角。

更多文章见个人博客:https://github.com/farmerjohngit/myblog

公众号(刚申请,之后文章会往上面发):

先说下面试流程,一般大公司都有3-4轮技术面,1轮的HR面。就阿里而言,我共经历了4轮技术面,前两轮主要是问基础和项目实现,第3轮是交叉面,两个面试官,主要是问项目实现和拓展。第4轮是部门老大面,主要就问一些架构、技术和业务的理解、个人发展比较抽象的东西了。

HR面主要就是跟你聊聊天,看看你的个人稳定性、价值观、主动性之类的,一般HR是不会挂人的,但很多人在HR面后挂了,原因其实不是你在HR面的表现不好(少数情况除外),而是你之前几面的表现一般,比60分要高一点(所以没在前面的面试直接挂了你),但是又没达到80分,这个时候公司基于hc、人才配比、与其他候选人的对比等多个维度考虑,最终决定是否给你offer。

另外要特别说下的是,今日头条对算法的考察会比较多,我面了4轮技术,每一轮都会问1到2个算法题,大概是leetcode上easy和medium难度。所以想去头条的同学最好先去leetcode上刷刷题。

另外,在求职的过程中也碰到过少数没有素质的面试官,比如一上来就一副很不屑的语气,话没说两句开始diss你的项目,给人的体验很不好。所以也请各位面试官或将来要做面试官的同学,能在面试的过程中保持基本的礼貌和尊重,就像在阿里常说的:你面试别人的时候,别人也在面试着你。

最重要的一点,不要因为几次的面试失败就开始怀疑自己,永远记住,面试的结果=实力+运气。有时候你擅长的东西可能面试官根本不会,所以他也不可能花很多时间去问他不懂的东西;有时候可能他问你的你都会,但是可能因为对方提问方式、语气等原因,答的就是不顺畅。

接下来说技术相关的考察。

总的来说,技术相关的考察主要分为两大块,一是基础,二是经验。

基础包括java基础、数据库、中间件等,来自于日常的积累和面试前的准备。

经验包括以往做过的项目、解决的问题、以及一些场景题(比如你的项目如果流量大了十倍如何保证可用)。

本文主要说基础,下篇文章将说经验。

以下都是我认为面试中经常会被考察到的知识点的整理,不够完整,但大部分都是常见面试题。

集合分为两大块:java.util包下的非线程安全集合和java.util.concurrent下的线程安全集合。

ArrayList与LinkedList的实现和区别

HashMap:了解其数据结构、hash冲突如何解决(链表和红黑树)、扩容时机、扩容时避免rehash的优化

LinkedHashMap:了解基本原理、哪两种有序、如何用它实现LRU

TreeMap:了解数据结构、了解其key对象为什么必须要实现Compare接口、如何用它实现一致性哈希

Set基本上都是由对应的map实现,简单看看就好

了解其实现原理

了解写时复制机制、了解其适用场景、思考为什么没有ConcurrentArrayList

了解实现原理、扩容时做的优化、与HashTable对比。

了解LinkedBlockingQueue、ArrayBlockingQueue、DelayQueue、SynchronousQueue

了解偏向锁、轻量级锁、重量级锁的概念以及升级机制、以及和ReentrantLock的区别

了解AtomicInteger实现原理、CAS适用场景、如何实现乐观锁

了解AQS内部实现、及依靠AQS的同步类比如ReentrantLock、Semaphore、CountDownLatch、CyclicBarrier等的实现

了解ThreadLocal使用场景和内部实现

了解线程池的工作原理以及几个重要参数的设置

推荐文章:

死磕Synchronized底层实现--概论(比较深入)

了解Java中的软引用、弱引用、虚引用的适用场景以及释放机制

推荐文章:

Java引用类型原理剖析(比较深入)

了解双亲委派机制

了解BIO和NIO的区别、了解多路复用机制

同步阻塞、同步非阻塞、异步的区别?

select、poll、eopll的区别?

java NIO与BIO的区别?

reactor线程模型是什么?

垃圾回收基本原理、几种常见的垃圾回收器的特性、重点了解CMS(或G1)以及一些重要的参数

能说清jvm的内存划分

推荐文章:JVM垃圾回收历险

bean的生命周期、循环依赖问题、spring cloud(如项目中有用过)、AOP的实现、spring事务传播

java动态代理和cglib动态代理的区别(经常结合spring一起问所以就放这里了)

spring中bean的生命周期是怎样的?

属性注入和构造器注入哪种会有循环依赖的问题?

了解一个常用RPC框架如Dubbo的实现:服务发现、路由、异步调用、限流降级、失败重试

了解一个常用消息中间件如RocketMq的实现:如何保证高可用和高吞吐、消息顺序、重复消费、事务消息、延迟消息、死信队列

redis工作模型、redis持久化、redis过期淘汰机制、redis分布式集群的常见形式、分布式锁、缓存击穿、缓存雪崩、缓存一致性问题

推荐书籍:《Redis 设计与实现》

推荐文章:

事务隔离级别、锁、索引的数据结构、聚簇索引和非聚簇索引、最左匹配原则、查询优化(explain等命令)

推荐文章:http://hedengcheng.com/?p=771

https://tech.meituan.com/2014/06/30/mysql-index.html

http://hbasefly.com/2017/08/19/mysql-transaction/

zk大致原理(可以了解下原理相近的Raft算法)、zk实现分布式锁、zk做集群master选举

HBase适用的场景、架构、merge和split、查写数据的流程。

推荐文章:http://hbasefly.com/2017/07/26/transaction-2/ 及该博客下相关文章

Storm与Map Reduce、Spark、Flink的比较。Storm高可用、消息ack机制

算法的话不是所有公司都会问,但最好还是准备下,主要是靠刷题,在leetcode上刷个100-200道easy和medium的题,然后对应公司的面经多看看,问题应该不大。

我所在的部门是阿里巴巴菜鸟网络下的国际事业部,主要是为速卖通、天猫海外、lazada等跨境电商提供国际物流解决方案。国际化是阿里巴巴集团未来三年五年的战略目标之一,目前业务也是高速发展的阶段,集团这几年也是往菜鸟这边在大量投入人才和资源。另外,菜鸟p6就有期权(集团是p7)。

招聘岗位:Java开发,base杭州

要求:

lock record最开始是什么时候被put 到线程栈的?

偏向锁从内存低位置向上寻找空闲lock record,什么情况下会找不到?找不到的话会怎样?

#12, 这篇文章的图裂了, 用浏览器直接打开显示Cannot proxy the given URL, 开代理也看不到.

Java中的对象都是在JVM堆中分配的,其好处在于开发者不用关心对象的回收。但有利必有弊,堆内内存主要有两个缺点:1.GC是有成本的,堆中的对象数量越多,GC的开销也会越大。2.使用堆内内存进行文件、网络的IO时,JVM会使用堆外内存做一次额外的中转,也就是会多一次内存拷贝。

和堆内内存相对应,堆外内存就是把内存对象分配在Java虚拟机堆以外的内存,这些内存直接受操作系统管理(而不是虚拟机),这样做的结果就是能够在一定程度上减少垃圾回收对应用程序造成的影响。

我们先看下堆外内存的实现原理,再谈谈它的应用场景。

更多文章见个人博客:https://github.com/farmerjohngit/myblog

Java中分配堆外内存的方式有两种,一是通过ByteBuffer.java#allocateDirect得到以一个DirectByteBuffer对象,二是直接调用Unsafe.java#allocateMemory分配内存,但Unsafe只能在JDK的代码中调用,一般不会直接使用该方法分配内存。

其中DirectByteBuffer也是用Unsafe去实现内存分配的,对堆内存的分配、读写、回收都做了封装。本篇文章的内容也是分析DirectByteBuffer的实现。

我们从堆外内存的分配回收、读写两个角度去分析DirectByteBuffer。

//ByteBuffer.java

public static ByteBuffer allocateDirect(int capacity) {

return new DirectByteBuffer(capacity);

}ByteBuffer#allocateDirect中仅仅是创建了一个DirectByteBuffer对象,重点在DirectByteBuffer的构造方法中。

DirectByteBuffer(int cap) { // package-private

//主要是调用ByteBuffer的构造方法,为字段赋值

super(-1, 0, cap, cap);

//如果是按页对齐,则还要加一个Page的大小;我们分析只pa为false的情况就好了

boolean pa = VM.isDirectMemoryPageAligned();

int ps = Bits.pageSize();

long size = Math.max(1L, (long)cap + (pa ? ps : 0));

//预分配内存

Bits.reserveMemory(size, cap);

long base = 0;

try {

//分配内存

base = unsafe.allocateMemory(size);

} catch (OutOfMemoryError x) {

Bits.unreserveMemory(size, cap);

throw x;

}

//将分配的内存的所有值赋值为0

unsafe.setMemory(base, size, (byte) 0);

//为address赋值,address就是分配内存的起始地址,之后的数据读写都是以它作为基准

if (pa && (base % ps != 0)) {

// Round up to page boundary

address = base + ps - (base & (ps - 1));

} else {

//pa为false的情况,address==base

address = base;

}

//创建一个Cleaner,将this和一个Deallocator对象传进去

cleaner = Cleaner.create(this, new Deallocator(base, size, cap));

att = null;

}DirectByteBuffer构造方法中还做了挺多事情的,总的来说分为几个步骤:

Java的堆外内存回收设计是这样的:当GC发现DirectByteBuffer对象变成垃圾时,会调用Cleaner#clean回收对应的堆外内存,一定程度上防止了内存泄露。当然,也可以手动的调用该方法,对堆外内存进行提前回收。

我们先看下Cleaner#clean的实现:

public class Cleaner extends PhantomReference<Object> {

...

private Cleaner(Object referent, Runnable thunk) {

super(referent, dummyQueue);

this.thunk = thunk;

}

public void clean() {

if (remove(this)) {

try {

//thunk是一个Deallocator对象

this.thunk.run();

} catch (final Throwable var2) {

...

}

}

}

}

private static class Deallocator

implements Runnable

{

private static Unsafe unsafe = Unsafe.getUnsafe();

private long address;

private long size;

private int capacity;

private Deallocator(long address, long size, int capacity) {

assert (address != 0);

this.address = address;

this.size = size;

this.capacity = capacity;

}

public void run() {

if (address == 0) {

// Paranoia

return;

}

//调用unsafe方法回收堆外内存

unsafe.freeMemory(address);

address = 0;

Bits.unreserveMemory(size, capacity);

}

}Cleaner继承自PhantomReference,关于虚引用的知识,可以看我之前写的文章

简单的说,就是当字段referent(也就是DirectByteBuffer对象)被回收时,会调用到Cleaner#clean方法,最终会调用到Deallocator#run进行堆外内存的回收。

Cleaner是虚引用在JDK中的一个典型应用场景。

然后再看下DirectByteBuffer构造方法中的第二步,reserveMemory

static void reserveMemory(long size, int cap) {

//maxMemory代表最大堆外内存,也就是-XX:MaxDirectMemorySize指定的值

if (!memoryLimitSet && VM.isBooted()) {

maxMemory = VM.maxDirectMemory();

memoryLimitSet = true;

}

//1.如果堆外内存还有空间,则直接返回

if (tryReserveMemory(size, cap)) {

return;

}

//走到这里说明堆外内存剩余空间已经不足了

final JavaLangRefAccess jlra = SharedSecrets.getJavaLangRefAccess();

//2.堆外内存进行回收,最终会调用到Cleaner#clean的方法。如果目前没有堆外内存可以回收则跳过该循环

while (jlra.tryHandlePendingReference()) {

//如果空闲的内存足够了,则return

if (tryReserveMemory(size, cap)) {

return;

}

}

//3.主动触发一次GC,目的是触发老年代GC

System.gc();

//4.重复上面的过程

boolean interrupted = false;

try {

long sleepTime = 1;

int sleeps = 0;

while (true) {

if (tryReserveMemory(size, cap)) {

return;

}

if (sleeps >= MAX_SLEEPS) {

break;

}

if (!jlra.tryHandlePendingReference()) {

try {

Thread.sleep(sleepTime);

sleepTime <<= 1;

sleeps++;

} catch (InterruptedException e) {

interrupted = true;

}

}

}

//5.超出指定的次数后,还是没有足够内存,则抛异常

throw new OutOfMemoryError("Direct buffer memory");

} finally {

if (interrupted) {

// don't swallow interrupts

Thread.currentThread().interrupt();

}

}

}

private static boolean tryReserveMemory(long size, int cap) {

//size和cap主要是page对齐的区别,这里我们把这两个值看作是相等的

long totalCap;

//totalCapacity代表通过DirectByteBuffer分配的堆外内存的大小

//当已分配大小<=还剩下的堆外内存大小时,更新totalCapacity的值返回true

while (cap <= maxMemory - (totalCap = totalCapacity.get())) {

if (totalCapacity.compareAndSet(totalCap, totalCap + cap)) {

reservedMemory.addAndGet(size);

count.incrementAndGet();

return true;

}

}

//堆外内存不足,返回false

return false;

}在创建一个新的DirecByteBuffer时,会先确认有没有足够的内存,如果没有的话,会通过一些手段回收一部分堆外内存,直到可用内存大于需要分配的内存。具体步骤如下:

tryHandlePendingReference方法回收已经变成垃圾的DirectByteBuffer对象对应的堆外内存,直到可用内存足够,或目前没有垃圾DirectByteBuffer对象-XX:+DisableExplicitGC,那System.gc();是无效的详细分析下第2步是如何回收垃圾的:tryHandlePendingReference最终调用到的是Reference#tryHandlePending方法,在之前的文章中有介绍过该方法

static boolean tryHandlePending(boolean waitForNotify) {

Reference<Object> r;

Cleaner c;

try {

synchronized (lock) {

//pending由jvm gc时设置

if (pending != null) {

r = pending;

// 如果是cleaner对象,则记录下来

c = r instanceof Cleaner ? (Cleaner) r : null;

// unlink 'r' from 'pending' chain

pending = r.discovered;

r.discovered = null;

} else {

// waitForNotify传入的值为false

if (waitForNotify) {

lock.wait();

}

// 如果没有待回收的Reference对象,则返回false

return waitForNotify;

}

}

} catch (OutOfMemoryError x) {

...

} catch (InterruptedException x) {

...

}

// Fast path for cleaners

if (c != null) {

//调用clean方法

c.clean();

return true;

}

...

return true;

}可以看到,tryHandlePendingReference的最终效果就是:如果有垃圾DirectBytebuffer对象,则调用对应的Cleaner#clean方法进行回收。clean方法在上面已经分析过了。

public ByteBuffer put(byte x) {

unsafe.putByte(ix(nextPutIndex()), ((x)));

return this;

}

final int nextPutIndex() {

if (position >= limit)

throw new BufferOverflowException();

return position++;

}

private long ix(int i) {

return address + ((long)i << 0);

}

public byte get() {

return ((unsafe.getByte(ix(nextGetIndex()))));

}

final int nextGetIndex() { // package-private

if (position >= limit)

throw new BufferUnderflowException();

return position++;

}读写的逻辑也比较简单,address就是构造方法中分配的native内存的起始地址。Unsafe的putByte/getByte都是native方法,就是写入值到某个地址/获取某个地址的值。

堆外内存分配回收也是有开销的,所以适合长期存在的对象

堆外内存能有效避免因GC导致的暂停问题。

因为堆外内存只能存储字节数组,所以对于复杂的DTO对象,每次存储/读取都需要序列化/反序列化,

用堆外内存读写文件性能更好

关于堆外内存IO为什么有更好的性能这点展开一下。

BIO的文件写FileOutputStream#write最终会调用到native层的io_util.c#writeBytes方法

void

writeBytes(JNIEnv *env, jobject this, jbyteArray bytes,

jint off, jint len, jboolean append, jfieldID fid)

{

jint n;

char stackBuf[BUF_SIZE];

char *buf = NULL;

FD fd;

...

// 如果写入长度为0,直接返回0

if (len == 0) {

return;

} else if (len > BUF_SIZE) {

// 如果写入长度大于BUF_SIZE(8192),无法使用栈空间buffer

// 需要调用malloc在堆空间申请buffer

buf = malloc(len);

if (buf == NULL) {

JNU_ThrowOutOfMemoryError(env, NULL);

return;

}

} else {

buf = stackBuf;

}

// 复制Java传入的byte数组数据到C空间的buffer中

(*env)->GetByteArrayRegion(env, bytes, off, len, (jbyte *)buf);

if (!(*env)->ExceptionOccurred(env)) {

off = 0;

while (len > 0) {

fd = GET_FD(this, fid);

if (fd == -1) {

JNU_ThrowIOException(env, "Stream Closed");

break;

}

//写入到文件,这里传递的数组是我们新创建的buf

if (append == JNI_TRUE) {

n = (jint)IO_Append(fd, buf+off, len);

} else {

n = (jint)IO_Write(fd, buf+off, len);

}

if (n == JVM_IO_ERR) {

JNU_ThrowIOExceptionWithLastError(env, "Write error");

break;

} else if (n == JVM_IO_INTR) {

JNU_ThrowByName(env, "java/io/InterruptedIOException", NULL);

break;

}

off += n;

len -= n;

}

}

}

GetByteArrayRegion其实就是对数组进行了一份拷贝,该函数的实现在jni.cpp宏定义中,找了很久才找到

//jni.cpp

JNI_ENTRY(void, \

jni_Get##Result##ArrayRegion(JNIEnv *env, ElementType##Array array, jsize start, \

jsize len, ElementType *buf)) \

...

int sc = TypeArrayKlass::cast(src->klass())->log2_element_size(); \

//内存拷贝

memcpy((u_char*) buf, \

(u_char*) src->Tag##_at_addr(start), \

len << sc); \

...

} \

JNI_END可以看到,传统的BIO,在native层真正写文件前,会在堆外内存(c分配的内存)中对字节数组拷贝一份,之后真正IO时,使用的是堆外的数组。要这样做的原因是

1.底层通过write、read、pwrite,pread函数进行系统调用时,需要传入buffer的起始地址和buffer count作为参数。如果使用java heap的话,我们知道jvm中buffer往往以byte[] 的形式存在,这是一个特殊的对象,由于java heap GC的存在,这里对象在堆中的位置往往会发生移动,移动后我们传入系统函数的地址参数就不是真正的buffer地址了,这样的话无论读写都会发生出错。而C Heap仅仅受Full GC的影响,相对来说地址稳定。

2.JVM规范中没有要求Java的byte[]必须是连续的内存空间,它往往受宿主语言的类型约束;而C Heap中我们分配的虚拟地址空间是可以连续的,而上述的系统调用要求我们使用连续的地址空间作为buffer。

以上内容来自于 知乎 ETIN的回答 https://www.zhihu.com/question/60892134/answer/182225677

BIO的文件读也一样,这里就不分析了。

NIO的文件写最终会调用到IOUtil#write

static int write(FileDescriptor fd, ByteBuffer src, long position,

NativeDispatcher nd, Object lock)

throws IOException

{

//如果是堆外内存,则直接写

if (src instanceof DirectBuffer)

return writeFromNativeBuffer(fd, src, position, nd, lock);

// Substitute a native buffer

int pos = src.position();

int lim = src.limit();

assert (pos <= lim);

int rem = (pos <= lim ? lim - pos : 0);

//创建一块堆外内存,并将数据赋值到堆外内存中去

ByteBuffer bb = Util.getTemporaryDirectBuffer(rem);

try {

bb.put(src);

bb.flip();

// Do not update src until we see how many bytes were written

src.position(pos);

int n = writeFromNativeBuffer(fd, bb, position, nd, lock);

if (n > 0) {

// now update src

src.position(pos + n);

}

return n;

} finally {

Util.offerFirstTemporaryDirectBuffer(bb);

}

}

/**

* 分配一片堆外内存

*/

static ByteBuffer getTemporaryDirectBuffer(int size) {

BufferCache cache = bufferCache.get();

ByteBuffer buf = cache.get(size);

if (buf != null) {

return buf;

} else {

// No suitable buffer in the cache so we need to allocate a new

// one. To avoid the cache growing then we remove the first

// buffer from the cache and free it.

if (!cache.isEmpty()) {

buf = cache.removeFirst();

free(buf);

}

return ByteBuffer.allocateDirect(size);

}

}

可以看到,NIO的文件写,对于堆内内存来说也是会有一次额外的内存拷贝的。

堆外内存的分析就到这里结束了,JVM为堆外内存做这么多处理,其主要原因也是因为Java毕竟不是像C这样的完全由开发者管理内存的语言。因此即使使用堆外内存了,JVM也希望能在合适的时候自动的对堆外内存进行回收。

在阅读JVM源码的时候,有很多地方都看不懂,但是又查询不到相关资料。如

CASE(_monitorenter): {

// lockee 就是锁对象

oop lockee = STACK_OBJECT(-1);

// derefing's lockee ought to provoke implicit null check

CHECK_NULL(lockee);

// code 1:找到一个空闲的Lock Record

BasicObjectLock* limit = istate->monitor_base();

.......如代码中的指针istate就不是很明白是什么意思,导致代码阅读很艰难。大佬有什么学习心得或者学习方法吗,是否可以传授一些经验呢

十分感谢

在<关于同步的一点思考-上>中介绍了几种实现锁的方式以及linux底层futex的实现原理

ReentrantLock的实现网上有很多文章了,本篇文章会简单介绍下其java层实现,重点放在分析竞争锁失败后如何阻塞线程。

因篇幅有限,synchronized的内容将会放到下篇文章。

ReentrantLock是jdk中常用的锁实现,其实现逻辑主语基于AQS(juc包中的大多数同步类实现都是基于AQS);接下来会简单介绍AQS的大致原理,关于其实现细节以及各种应用,之后会写一篇文章具体分析。

AQS是类AbstractQueuedSynchronizer.java的简称,JUC包下的ReentrantLock、CyclicBarrier、CountdownLatch都使用到了AQS。

其大致原理如下:

其中tryAcquire方法是抽象方法,具体实现取决于实现类,我们常说的公平锁和非公平锁的区别就在于该方法的实现。

ReentrantLock分为公平锁和非公平锁,我们只看公平锁。

ReentrantLock.lock会调用到ReentrantLock#FairSync.lock中:

FairSync.java

static final class FairSync extends Sync {

final void lock() {

acquire(1);

}

/**

* Fair version of tryAcquire. Don't grant access unless

* recursive call or no waiters or is first.

*/

protected final boolean tryAcquire(int acquires) {

final Thread current = Thread.currentThread();

int c = getState();

if (c == 0) {

if (!hasQueuedPredecessors() &&

compareAndSetState(0, acquires)) {

setExclusiveOwnerThread(current);

return true;

}

}

else if (current == getExclusiveOwnerThread()) {

int nextc = c + acquires;

if (nextc < 0)

throw new Error("Maximum lock count exceeded");

setState(nextc);

return true;

}

return false;

}

}

AbstractQueuedSynchronizer.java

public final void acquire(int arg) {

if (!tryAcquire(arg) &&

acquireQueued(addWaiter(Node.EXCLUSIVE), arg))

selfInterrupt();

}

可以看到FairSync.lock调用了AQS的acquire方法,而在acquire中首先调用tryAcquire尝试获得锁,以下两种情况返回true:

重入如果tryAcquire失败则调用acquireQueued阻塞当前线程。acquireQueued最终会调用到LockSupport.park()阻塞线程。

个人认为,要深入理解锁机制,一个很重要的点是理解系统是如何阻塞线程的。

LockSupport.java

public static void park(Object blocker) {

Thread t = Thread.currentThread();

setBlocker(t, blocker);

UNSAFE.park(false, 0L);

setBlocker(t, null);

}

park方法的参数blocker是用于负责这次阻塞的同步对象,在AQS的调用中,这个对象就是AQS本身。我们知道synchronized关键字是需要指定一个对象的(如果作用于方法上则是当前对象或当前类),与之类似blocker就是LockSupport指定的对象。

park方法调用了native方法UNSAFE.park,第一个参数代表第二个参数是否是绝对时间,第二个参数代表最长阻塞时间。

其实现如下,只保留核心代码,完整代码看查看unsafe.cpp

Unsafe_Park(JNIEnv *env, jobject unsafe, jboolean isAbsolute, jlong time){

...

thread->parker()->park(isAbsolute != 0, time);

...

}

park方法在os_linux.cpp中(其他操作系统的实现在os_xxx中)

void Parker::park(bool isAbsolute, jlong time) {

...

//获得当前线程

Thread* thread = Thread::current();

assert(thread->is_Java_thread(), "Must be JavaThread");

JavaThread *jt = (JavaThread *)thread;

//如果当前线程被设置了interrupted标记,则直接返回

if (Thread::is_interrupted(thread, false)) {

return;

}

if (time > 0) {

//unpacktime中根据isAbsolute的值来填充absTime结构体,isAbsolute为true时,time代表绝对时间且单位是毫秒,否则time是相对时间且单位是纳秒

//absTime.tvsec代表了对于时间的秒

//absTime.tv_nsec代表对应时间的纳秒

unpackTime(&absTime, isAbsolute, time);

}

//调用mutex trylock方法

if (Thread::is_interrupted(thread, false) || pthread_mutex_trylock(_mutex) != 0) {

return;

}

//_counter是一个许可的数量,跟ReentrantLock里定义的许可变量基本都是一个原理。 unpack方法调用时会将_counter赋值为1。

//_counter>0代表已经有人调用了unpark,所以不用阻塞

int status ;

if (_counter > 0) { // no wait needed

_counter = 0;

//释放mutex锁

status = pthread_mutex_unlock(_mutex);

return;

}

//设置线程状态为CONDVAR_WAIT

OSThreadWaitState osts(thread->osthread(), false /* not Object.wait() */);

...

//等待

_cur_index = isAbsolute ? ABS_INDEX : REL_INDEX;

pthread_cond_timedwait(&_cond[_cur_index], _mutex, &absTime);

...

//释放mutex锁

status = pthread_mutex_unlock(_mutex) ;

}

park方法用POSIX的pthread_cond_timedwait方法阻塞线程,调用pthread_cond_timedwait前需要先获得锁,因此park主要流程为:

pthread_mutex_trylock尝试获得锁,如果获取锁失败则直接返回pthread_cond_timedwait进行等待pthread_mutex_unlock释放锁另外,在阻塞当前线程前,会调用OSThreadWaitState的构造方法将线程状态设置为CONDVAR_WAIT,在Jvm中Thread状态枚举如下

enum ThreadState {

ALLOCATED, // Memory has been allocated but not initialized

INITIALIZED, // The thread has been initialized but yet started

RUNNABLE, // Has been started and is runnable, but not necessarily running

MONITOR_WAIT, // Waiting on a contended monitor lock

CONDVAR_WAIT, // Waiting on a condition variable

OBJECT_WAIT, // Waiting on an Object.wait() call

BREAKPOINTED, // Suspended at breakpoint

SLEEPING, // Thread.sleep()

ZOMBIE // All done, but not reclaimed yet

};

由上文我们可以知道LockSupport.park方法最终是由POSIX的

pthread_cond_timedwait的方法实现的。

我们现在就进一步看看pthread_mutex_trylock,pthread_cond_timedwait,pthread_mutex_unlock这几个方法是如何实现的。

Linux系统中相关代码在glibc库中。

pthread_mutex_trylock先看trylock的实现,

代码在glibc的pthread_mutex_trylock.c文件中,该方法代码很多,我们只看主要代码

//pthread_mutex_t是posix中的互斥锁结构体

int

__pthread_mutex_trylock (mutex)

pthread_mutex_t *mutex;

{

int oldval;

pid_t id = THREAD_GETMEM (THREAD_SELF, tid);

switch (__builtin_expect (PTHREAD_MUTEX_TYPE (mutex),

PTHREAD_MUTEX_TIMED_NP))

{

case PTHREAD_MUTEX_ERRORCHECK_NP:

case PTHREAD_MUTEX_TIMED_NP:

case PTHREAD_MUTEX_ADAPTIVE_NP:

/* Normal mutex. */

if (lll_trylock (mutex->__data.__lock) != 0)

break;

/* Record the ownership. */

mutex->__data.__owner = id;

++mutex->__data.__nusers;

return 0;

}

}

//以下代码在lowlevellock.h中

#define __lll_trylock(futex) \

(atomic_compare_and_exchange_val_acq (futex, 1, 0) != 0)

#define lll_trylock(futex) __lll_trylock (&(futex))

mutex默认用的是PTHREAD_MUTEX_NORMAL类型(与PTHREAD_MUTEX_TIMED_NP相同);

因此会先调用lll_trylock方法,lll_trylock实际上是一个cas操作,如果mutex->__data.__lock==0则将其修改为1并返回0,否则返回1。

如果成功,则更改mutex中的owner为当前线程。

pthread_mutex_unlockpthread_mutex_unlock.c

int

internal_function attribute_hidden

__pthread_mutex_unlock_usercnt (mutex, decr)

pthread_mutex_t *mutex;

int decr;

{

if (__builtin_expect (type, PTHREAD_MUTEX_TIMED_NP)

== PTHREAD_MUTEX_TIMED_NP)

{

/* Always reset the owner field. */

normal:

mutex->__data.__owner = 0;

if (decr)

/* One less user. */

--mutex->__data.__nusers;

/* Unlock. */

lll_unlock (mutex->__data.__lock, PTHREAD_MUTEX_PSHARED (mutex));

return 0;

}

}

pthread_mutex_unlock将mutex中的owner清空,并调用了lll_unlock方法

lowlevellock.h

#define __lll_unlock(futex, private) \

((void) ({ \

int *__futex = (futex); \

int __val = atomic_exchange_rel (__futex, 0); \

\

if (__builtin_expect (__val > 1, 0)) \

lll_futex_wake (__futex, 1, private); \

}))

#define lll_unlock(futex, private) __lll_unlock(&(futex), private)

#define lll_futex_wake(ftx, nr, private) \

({ \

DO_INLINE_SYSCALL(futex, 3, (long) (ftx), \

__lll_private_flag (FUTEX_WAKE, private), \

(int) (nr)); \

_r10 == -1 ? -_retval : _retval; \

})

lll_unlock分为两个步骤:

FUTEX_WAIT在休眠,所以通过调用系统函数FUTEX_WAKE唤醒休眠线程FUTEX_WAKE 在上一篇文章有分析,futex机制的核心是当获得锁时,尝试cas更改一个int型变量(用户态操作),如果integer原始值是0,则修改成功,该线程获得锁,否则就将当期线程放入到 wait queue中,wait queue中的线程不会被系统调度(内核态操作)。

futex变量的值有3种:0代表当前锁空闲,1代表有线程持有当前锁,2代表存在锁冲突。futex的值初始化时是0;当调用try_lock的时候会利用cas操作改为1(见上面的trylock函数);当调用lll_lock时,如果不存在锁冲突,则将其改为1,否则改为2。

#define __lll_lock(futex, private) \

((void) ({ \

int *__futex = (futex); \

if (__builtin_expect (atomic_compare_and_exchange_bool_acq (__futex, \

1, 0), 0)) \

{ \

if (__builtin_constant_p (private) && (private) == LLL_PRIVATE) \

__lll_lock_wait_private (__futex); \

else \

__lll_lock_wait (__futex, private); \

} \

}))

#define lll_lock(futex, private) __lll_lock (&(futex), private)

void

__lll_lock_wait_private (int *futex)

{

//第一次进来的时候futex==1,所以不会走这个if

if (*futex == 2)

lll_futex_wait (futex, 2, LLL_PRIVATE);

//在这里会把futex设置成2,并调用futex_wait让当前线程等待

while (atomic_exchange_acq (futex, 2) != 0)

lll_futex_wait (futex, 2, LLL_PRIVATE);

}

pthread_cond_timedwaitpthread_cond_timedwait用于阻塞线程,实现线程等待,

代码在glibc的pthread_cond_timedwait.c文件中,代码较长,你可以先简单过一遍,看完下面的分析再重新读一遍代码

int

int

__pthread_cond_timedwait (cond, mutex, abstime)

pthread_cond_t *cond;

pthread_mutex_t *mutex;

const struct timespec *abstime;

{

struct _pthread_cleanup_buffer buffer;

struct _condvar_cleanup_buffer cbuffer;

int result = 0;

/* Catch invalid parameters. */

if (abstime->tv_nsec < 0 || abstime->tv_nsec >= 1000000000)

return EINVAL;

int pshared = (cond->__data.__mutex == (void *) ~0l)

? LLL_SHARED : LLL_PRIVATE;

//1.获得cond锁

lll_lock (cond->__data.__lock, pshared);

//2.释放mutex锁

int err = __pthread_mutex_unlock_usercnt (mutex, 0);

if (err)

{

lll_unlock (cond->__data.__lock, pshared);

return err;

}

/* We have one new user of the condvar. */

//每执行一次wait(pthread_cond_timedwait/pthread_cond_wait),__total_seq就会+1

++cond->__data.__total_seq;

//用来执行futex_wait的变量

++cond->__data.__futex;

//标识该cond还有多少线程在使用,pthread_cond_destroy需要等待所有的操作完成

cond->__data.__nwaiters += 1 << COND_NWAITERS_SHIFT;

/* Remember the mutex we are using here. If there is already a

different address store this is a bad user bug. Do not store

anything for pshared condvars. */

//保存mutex锁

if (cond->__data.__mutex != (void *) ~0l)

cond->__data.__mutex = mutex;

/* Prepare structure passed to cancellation handler. */

cbuffer.cond = cond;

cbuffer.mutex = mutex;

/* Before we block we enable cancellation. Therefore we have to

install a cancellation handler. */

__pthread_cleanup_push (&buffer, __condvar_cleanup, &cbuffer);

/* The current values of the wakeup counter. The "woken" counter

must exceed this value. */

//记录futex_wait前的__wakeup_seq(为该cond上执行了多少次sign操作+timeout次数)和__broadcast_seq(代表在该cond上执行了多少次broadcast)

unsigned long long int val;