I'm interested in Rust, Go, good at designing & writing distributed system.

🔭 And I’m currently working on building resource&traffic scheduling and faas infrastructure using Go and Rust at ByteDance in Hangzhou.

人们往往接受流行,不是因为想要与众不同,而是因为害怕与众不同

Home Page: http://digitalpie.cf

Note:第一篇bitcoin日志中介绍了JSON-RPC,

同时记录了启动bitcoind的基本方法。

使用bitcoin-explorer获取block chain中的数据,加以分析处理。这一过程的最开始就利用了JSON-RPC。拿insight为例,其后台insight-api中的核心bitcore就是用来和bitcoind进程通信的,而通信的方式就是JSON-RPC:insight进程向bitcoind进程发送RPC指令,并在回调中得到想要的数据,然后呈现给上层应用做数据可视化。

JSON-RPC协议的本质仍是HTTP协议,也就是说JSON-RPC在HTTP基础上进行通信的。

在2013年更新了2.0版本,bitcoind使用的就是JSON-RPC 2.0

jsonrpc: 用来指定JSON-RPC的版本,必须为2.0

method: 需要调用的方法名

params: 参数数组,

id: 由客户端建立的rpc标识符

jsonrpc: 同上

result: 服务器返回的结果,如果出现错误,就没有这个字段

error: 一个JSON对象,如果调用成功则没有这个字段

id: 与请求的id相同(如果请求失败,id为null)

客户端在同一时刻发送多个请求对象,这些请求对象包装在一个数组中。这时服务器返回的也是个数组,包含对应请求对象的响应。

client => [

{"jsonrpc": "2.0", "method": "sum", "params": [1,2,4], "id": "1"},

{"jsonrpc": "2.0", "method": "notify_hello", "params": [7]},

{"jsonrpc": "2.0", "method": "subtract", "params": [42,23], "id": "2"},

{"foo": "boo"},

{"jsonrpc": "2.0", "method": "foo.get", "params": {"name": "myself"}, "id": "5"},

{"jsonrpc": "2.0", "method": "get_data", "id": "9"}

]

server => [

{"jsonrpc": "2.0", "result": 7, "id": "1"},

{"jsonrpc": "2.0", "result": 19, "id": "2"},

{"jsonrpc": "2.0", "error": {"code": -32600, "message": "Invalid Request"}, "id": null},

{"jsonrpc": "2.0", "error": {"code": -32601, "message": "Method not found"}, "id": "5"},

{"jsonrpc": "2.0", "result": ["hello", 5], "id": "9"}

]

它是中本聪编写的BTC客户端,也是第一个BTC客户端。实现了BTC的相关协议,并提供了RPC通信接口,允许本机进程或远程主机与其通信。

为了方便起见,把bitcoind添加到alias:

echo "alias btcrpc=$HOME/bitcoind -conf=$HOME/bitcoin.conf" >> .bashrc

bitcoind提供了一大堆RPC API,列表详见:

https://en.bitcoin.it/wiki/Original_Bitcoin_client/API_Calls_list

通过help命令也可以获取:

btcrpc help

addmultisigaddress nrequired ["key",...] ( "account" )

addnode "node" "add|remove|onetry"

backupwallet "destination"

createmultisig nrequired ["key",...]

createrawtransaction [{"txid":"id","vout":n},...] {"address":amount,...}

decoderawtransaction "hexstring"

decodescript "hex"

dumpprivkey "bitcoinaddress"

dumpwallet "filename"

encryptwallet "passphrase"

getaccount "bitcoinaddress"

getaccountaddress "account"

getaddednodeinfo dns ( "node" )

getaddressesbyaccount "account"

getbalance ( "account" minconf )

getbestblockhash

getblock "hash" ( verbose )

getblockcount

getblockhash index

getblocktemplate ( "jsonrequestobject" )

getconnectioncount

getdifficulty

getgenerate

gethashespersec

getinfo

getmininginfo

getnettotals

getnetworkhashps ( blocks height )

getnewaddress ( "account" )

getpeerinfo

getrawchangeaddress

getrawmempool ( verbose )

getrawtransaction "txid" ( verbose )

getreceivedbyaccount "account" ( minconf )

getreceivedbyaddress "bitcoinaddress" ( minconf )

gettransaction "txid"

gettxout "txid" n ( includemempool )

gettxoutsetinfo

getunconfirmedbalance

getwork ( "data" )

help ( "command" )

importprivkey "bitcoinprivkey" ( "label" rescan )

importwallet "filename"

keypoolrefill ( newsize )

listaccounts ( minconf )

listaddressgroupings

listlockunspent

listreceivedbyaccount ( minconf includeempty )

listreceivedbyaddress ( minconf includeempty )

listsinceblock ( "blockhash" target-confirmations )

listtransactions ( "account" count from )

listunspent ( minconf maxconf ["address",...] )

lockunspent unlock [{"txid":"txid","vout":n},...]

move "fromaccount" "toaccount" amount ( minconf "comment" )

ping

sendfrom "fromaccount" "tobitcoinaddress" amount ( minconf "comment" "comment-to" )

sendmany "fromaccount" {"address":amount,...} ( minconf "comment" )

sendrawtransaction "hexstring" ( allowhighfees )

sendtoaddress "bitcoinaddress" amount ( "comment" "comment-to" )

setaccount "bitcoinaddress" "account"

setgenerate generate ( genproclimit )

settxfee amount

signmessage "bitcoinaddress" "message"

signrawtransaction "hexstring" ( [{"txid":"id","vout":n,"scriptPubKey":"hex","redeemScript":"hex"},...] ["privatekey1",...] sighashtype )

stop

submitblock "hexdata" ( "jsonparametersobject" )

validateaddress "bitcoinaddress"

verifychain ( checklevel numblocks )

verifymessage "bitcoinaddress" "signature" "message"

ex:

btcrpc getpeerinfo

[

{

"addr" : "127.0.0.1:35629",

"services" : "00000001",

"lastsend" : 1400043134,

"lastrecv" : 1400043134,

"bytessent" : 3357058,

"bytesrecv" : 147242,

"conntime" : 1400039657,

"pingtime" : 0.00000000,

"version" : 70000,

"subver" : "/BitcoinX:0.1/",

"inbound" : true,

"startingheight" : 0,

"banscore" : 0

},

{

"addr" : "50.184.166.246:8333",

"services" : "00000001",

"lastsend" : 1400043145,

"lastrecv" : 1400043133,

"bytessent" : 122888,

"bytesrecv" : 800499,

"conntime" : 1400039658,

"pingtime" : 0.00000000,

"version" : 70001,

"subver" : "/Satoshi:0.8.6/",

"inbound" : false,

"startingheight" : 300640,

"banscore" : 0,

"syncnode" : true

},

{

"addr" : "67.212.92.167:8333",

"services" : "00000001",

"lastsend" : 1400043145,

"lastrecv" : 1400043125,

"bytessent" : 124584,

"bytesrecv" : 749619,

"conntime" : 1400039658,

"pingtime" : 0.00000000,

"version" : 70002,

"subver" : "/Satoshi:0.9.1/",

"inbound" : false,

"startingheight" : 300640,

"banscore" : 0

},

{

"addr" : "174.78.248.214:8333",

"services" : "00000001",

"lastsend" : 1400043134,

"lastrecv" : 1400043144,

"bytessent" : 119650,

"bytesrecv" : 388564,

"conntime" : 1400039659,

"pingtime" : 0.00000000,

"version" : 70002,

"subver" : "/Satoshi:0.9.1/",

"inbound" : false,

"startingheight" : 300640,

"banscore" : 0

},

{

"addr" : "89.98.93.137:8333",

"services" : "00000001",

"lastsend" : 1400043144,

"lastrecv" : 1400043119,

"bytessent" : 130925,

"bytesrecv" : 1011629,

"conntime" : 1400039666,

"pingtime" : 0.00000000,

"version" : 70002,

"subver" : "/Satoshi:0.9.1/",

"inbound" : false,

"startingheight" : 300640,

"banscore" : 0

},

{

"addr" : "199.115.176.18:8333",

"services" : "00000001",

"lastsend" : 1400043135,

"lastrecv" : 1400043127,

"bytessent" : 345728,

"bytesrecv" : 25299,

"conntime" : 1400039675,

"pingtime" : 0.00000000,

"version" : 50000,

"subver" : "",

"inbound" : false,

"startingheight" : 277595,

"banscore" : 0

},

{

"addr" : "108.53.129.182:8333",

"services" : "00000001",

"lastsend" : 1400043134,

"lastrecv" : 1400043144,

"bytessent" : 115329,

"bytesrecv" : 359246,

"conntime" : 1400039691,

"pingtime" : 0.00000000,

"version" : 70002,

"subver" : "/Satoshi:0.9.1/",

"inbound" : false,

"startingheight" : 300640,

"banscore" : 0

},

{

"addr" : "107.170.211.129:8333",

"services" : "00000001",

"lastsend" : 1400043144,

"lastrecv" : 1400043144,

"bytessent" : 133227,

"bytesrecv" : 992178,

"conntime" : 1400039697,

"pingtime" : 0.00000000,

"version" : 70001,

"subver" : "/Satoshi:0.8.5/",

"inbound" : false,

"startingheight" : 300640,

"banscore" : 0

},

{

"addr" : "24.159.17.178:8333",

"services" : "00000001",

"lastsend" : 1400043145,

"lastrecv" : 1400043005,

"bytessent" : 36944879,

"bytesrecv" : 130539,

"conntime" : 1400040379,

"pingtime" : 0.00000000,

"version" : 70002,

"subver" : "/Satoshi:0.9.1/",

"inbound" : false,

"startingheight" : 181817,

"banscore" : 0

}

]

注意JSON-RPC不仅仅通信使用JSON格式,得到的结果当然也是JSON格式的啦。

除了命令行的方式外,也有很多编程语言的wrapper以及curl工具:

这是最Raw的方法,可以看到RPC交互的数据格式:

curl --user user --data-binary '{"jsonrpc": "1.0", "id":"curltest", "method": "getinfo", "params": [] }'

-H 'content-type: text/plain;' http://127.0.0.1:8332/

返回:

{"result":{"balance":0.000000000000000,"blocks":59952,"connections":48,"proxy":"","generate":false,

"genproclimit":-1,"difficulty":16.61907875185736,"error":null,"id":"curltest"}

自然有人写模块啦,node下有很多wrap,这个例子(bitcoin模块)是来自官网的:

var bitcoin = require('bitcoin');

var client = new bitcoin.Client({

host: 'localhost',

port: 8332,

user: 'user',

pass: 'pass'

});

client.getDifficulty(function(err, difficulty) {

if (err) {

return console.error(err);

}

console.log('Difficulty: ' + difficulty);

});

闭包是JavaScript中的一个基本概念。咋一看感觉没什么了不起:不就是在函数中定义了一个嵌套函数,并且嵌套函数能够访问外部变量,然后这个嵌套函数就起个名叫Closure嘛~

没错,在计算机科学文献中闭包的定义不过如此,但你不一定会用。举个例子:

var 一只变量 = 'global';

function 只是测试() {

var 一只变量 = 'local';

function inside() {

return 一只变量;

}

return inside;

}

只是测试()();

在这个例子中外部函数返回了一个闭包inside,然后在全局作用域下调用了返回的这个函数,然后最终返回‘global’。

看上去很简单,不是么?

如果要真是这样的话那就没意思了。。。真实的情况是调用闭包后返回“local”!

为什么?正常情况下在全局声明了一个变量,然后在全局中调用一个函数:

function inside() {

return 一只变量;

}

理论上一只变量并没有在inside函数内部声明,因此他应该是个全局变量,这个函数应该返回‘global’才对啊~~

不过这次注意inside函数是怎么来的:在一个外部函数中返回了这个inside闭包!

我想曾经学过类C语言的同学会对其函数有这样的印象:当函数执行完毕后,其内部定义的任何变量都被释放,并且不允许任何外部引用接触到内部的变量。因此大部分人对JavaScript的闭包存有误解:即使返回了一个内部定义的函数,函数不过是函数,像个模型一样等着任意变量去填充,所以内部定义的变量应该与inside内的变量无关并且误认为应该已经被释放了。

不过C语言不是一门函数式语言,也没有Closure一说。

所以事实是这样的:inside被返回后,由于闭包的特性,它内部会保持对其外部变量的引用,并且函数中定义的局部变量就不会被释放。这里有段来自权威指南中的底层解释:

……基于栈的CPU架构:如果一个函数局部变量定义在CPU的栈中,那么当函数返回时他们就不存在了……

那么闭包如何做到引用外部函数定义的变量呢?下面来说说JavaScript中的作用域链。

在浏览器的全局作用域下,window为对应环境的全局变量,任何直接在该环境中声明或直接调用的变量都将成为window对象的属性。

类比window对象,可以这么理解作用域:每个作用域都对应着一个‘对象’,称其为‘该作用域的全局对象’。

因此,在函数中定义的变量可理解为该函数作用域的作用域对象的属性,也就是所说的变量属于这个局部作用域。

当作用域形成一级一级的嵌套,便形成了作用域链。它是一个由每个作用域对应的作用域对象链接而成的一个对象链表。

在顶级作用域window,作用域链就包含window对象,函数作用域内,作用域链至少包含window对象和当前作用域对象,当嵌套时还有更多的函数作用域对象挂载到链上。

作用域链的特点就是:1.每执行一次函数,都会新建一个作用域对象并挂载到作用域链上,这个作用域对象保存了当前环境下的局部变量和函数参数。这是很好理解的,因为每次执行同一个函数,他们之间的作用域都互不干扰。2.当函数执行完毕,就将这个作用域对象从作用域链中删除(也就是局部变量被释放无法使用),但这成立与否基于一个前提,也就是前面所说的是否返回闭包的情况。

有了作用域对象的概念,就能进一步说解释包调用了。

……如果函数体内不存在嵌套的函数……或者存在嵌套的函数但他们都在父函数中保留了下来……,那么等父函数返回时,对应的作用域对象便会被删除掉。……但如果存在嵌套函数,且父函数返回了这个闭包并被引用/调用(或者将这个闭包存储为一个属性)……这时,就会有一个外部引用指向这个嵌套函数,则这种情况下父作用域对象便不会被释放……

以上是来自权威指南中的一段关于‘闭包如何保存外部变量’的描述。

但究其作用域对象不被释放的根本,还需要词法作用域这个概念,其规则是:函数定义时的作用域链到函数执行时依然有效!

JavaScript函数执行时用到了作用域链,而这个作用域链是在函数定义时确定的。由于嵌套函数定义在函数作用域内,其作用域链包含父函数的作用域对象,所以不管在何时何地执行闭包,这条作用域链都是有效的!

这回闭包的profile是不是就清晰了呢?然后让我们来看看闭包在实际应用中最常见的问题——内存泄漏。

就在昨天,我在浏览器中测试的一段代码引发了内存泄露,并且无法阻止,最后只好关掉重启浏览器。也正是这次的经历,让我对内存泄漏记忆颇深,并且决对不是空谈。

所谓内存泄漏是指分配给应用的内存既 不能被回收 也 不能被重新分配利用 。

在内存管理的环境中,一个对象如果有访问另一个对象的权限(隐式或者显式),叫做一个对象引用另一个对象。 --from MDN

举个循环引用的例子,例如:

//obj1与obj2相互引用

var obj1, obj2;

obj1.pro = obj2;

obj2.pro = obj1;

//obj的自身引用

var obj;

obj.pro = obj;

// 函数作用域对象对外部对象的引用, 外部对象同样引用着函数

a= obj;

a.f = function () {};

引用计数垃圾收集

这是最简单的垃圾收集算法。此算法把“对象是否不再需要”简化定义为“对象有没有其他对象引用到它”。如果没有引用指向该对象(零引用),对象将被垃圾回收机制回收。

如果解释器采用了这种GC算法, 那么循环引用肯定会导致内存泄露, 因为目标对象的引用计数始终大于0. 不过这种算法已被现代浏览器所淘汰了, 大都经过改进, 结合了另一种GC算法:

标记-清除算法

这个算法把“对象是否不再需要”简化定义为“对象是否可以获得”。

假定设置一个叫做根的对象(在Javascript里,根是全局对象)。定期的,垃圾回收器将从根开始,找所有从根开始引用的对象,然后找这些对象引用的对象……从根开始,垃圾回收器将找到所有可以获得的对象和所有不能获得的对象。最后清除无法获得的对象.

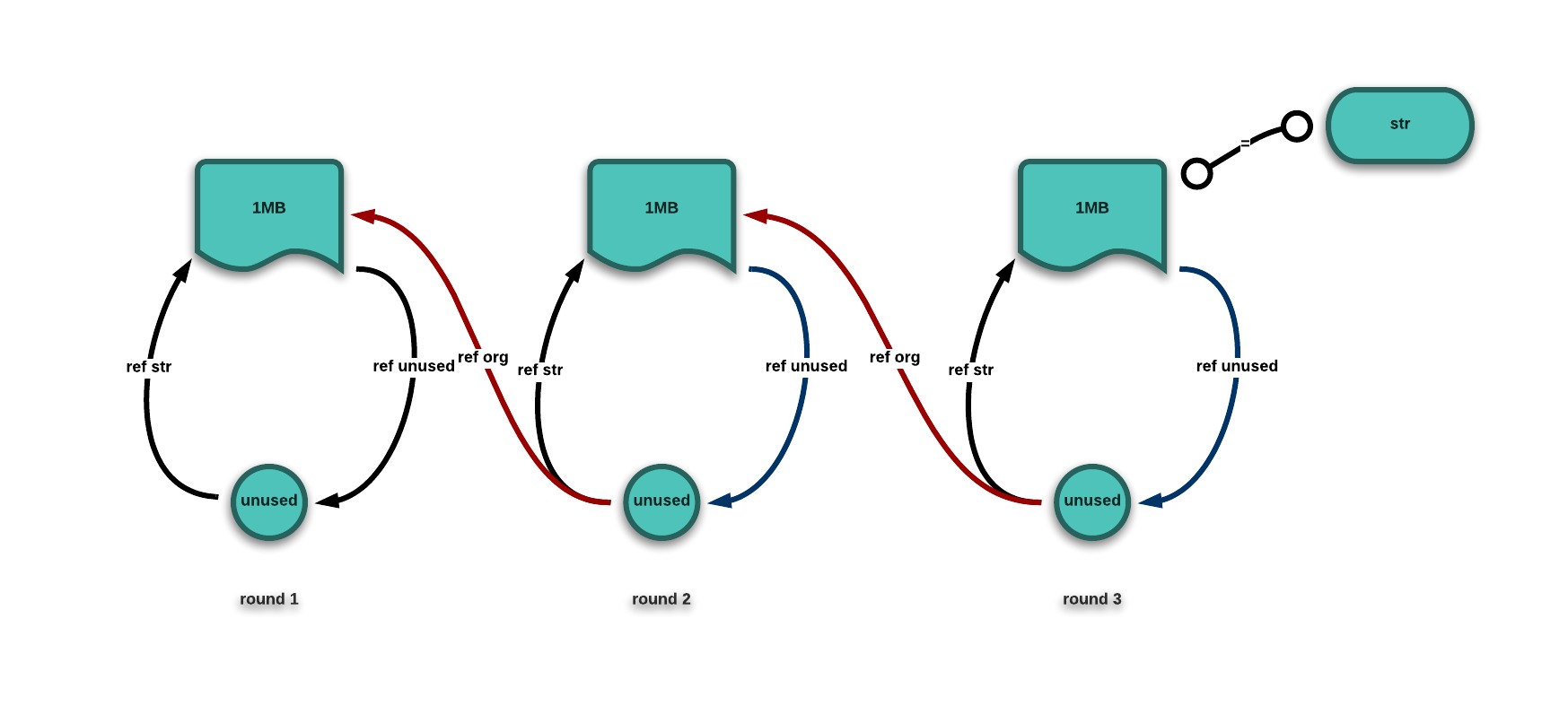

正常来讲,这不会出现什么问题。但是当引用的对象之一关联着特占内存的大型数据(像超长字符串、超长哈希映射或DOM对象),问题就来了:

sth = null

rep = () ->

org = sth

unused = () -> org or null

sth =

str: [1..1000000].join ''

fun: () -> unused null

console.log process.memoryUsage()

setInterval rep, 1000这是一个蹩脚的由链式引用引起的内存泄漏。

从浏览器和Node环境下的内存监测来看,每次GC似乎都没有彻底释放内存,显然内存泄漏了。我们来分析一下代码看看这是为什么:

首先,我定义一个显式引用org的闭包unused并且没有调用它. org在rep函数的公共词法作用域中.

第二,sth和org一个道理, 会被unused隐式引用.

最后, unused能被sth.fun函数引用(虽然很明显这个函数没有使用它)。但是因为unused也在rep公共词法作用域内,fun还会保持对unused的引用。

这样就形成了一个链式引用:org指向上一次的sth, unused引用org,而sth.func引用了unused。在当前时刻, 全局变量sth的属性fun作用域中隐式引用了unused, 也就间接引用了unused作用域的引用.

理论上, 这样就保存了一个引用链:

所以,尽管我们每次调用rep函数都会有一个新建的sth对象把sth覆盖,但有引用链的存在,原先的值不但永远不会被清除,还会在每秒不断增加循环调用的个数从而增加内存占用量.

那这个问题该如何解决?对此,有两个解决方案:

1.由于unused函数引用了org,所以可以从这里入手,把unused这个函数中的引用去掉,这样就没有循环引用的闭包了,也就没有泄漏了。

2.将unused和sth引用的根源org做下处理:

//在rep函数体最后加:

org = null;

我测试了100s内的内存占用情况变化, 并做了可视化:

其中灰色代表原始代码, 粉色代表方案二, 淡蓝色代表方案一

这与我们之前的分析稍微有些出入. 严格来讲, 现代JavaScript引擎已经做到足够智能和优化(就像之前提到的两个GC算法), 如果沿着全局对象不能访问到目标对象, 那么他将被标记为不可用, 因此将被GC. 这就是为什么灰色的原始曲线也会有大幅波动出现.

还没读V8GC的代码, 暂时有这两个猜测 (接下来两段为猜想...)

既然可以被GC, 那么灰色曲线的持续增长又是什么原因? 这里我只能猜测引用链里有显示引用(unused对org)的原因导致每次GC时无法做出准确判断到底该不该回收, 只好等到内存使用量太大并且程序确实不会再用到他们时才GC一次.

或者是GC可以回收那些内存, 只是速率不及内存使用的快, 并且对于包含显示引用的引用关系回收效果甚微(就是不能一次回收干净, 要一点点的拆除ref)

脑补结束, 欢迎指明误区并参与讨论!!

而对于两种解决方案来说, 第一种能够"化显为隐"(unused中不存在对org的显示引用了). 第二种则更直接的断开了引用链(被显示引用的org变成null), 导致上一次产生的str及不可访问又失去了最后一个引用. 这就能让GC快速准确的回收内存.

可以看出, 两种方案的效果基本一样, 内存占用基本保持在一个小范围内波动, 只不过_赋值null_能比_去掉unused引用_更早的进行垃圾收集. 但未经处理的代码就不一样的了, 可以清除的看到灰色区域的内存占用量始终成上涨趋势, 虽然可以看到有进行内存收集的迹象, 但仍抵不住疯狂增长的大潮.

再来看下面这个明显的例子:

//这是昨天我测试的用例2:

var run = function () {

//一个占1MB内存的字符串

var str = new Array(1000000).join(''*'');

var doSth = function () {

if (str === 'something')

console.log("str was something");

};

doSth();

var log = function () {

console.log('interval');

};

setInterval(log, 100);

};

setInterval(run, 1000);

显而易见,setInterval(run, 1000)执行后run函数将会在每秒执行一次;log函数将会在一秒内连续执行10次。

这里的setInterval(log, 100)保存了对log闭包的外部引用,因为str字符串在公共词法作用域内,所以log保持着对str的引用使str不会在run函数结束时被释放,并且在每次执行run时内存占用量都会增加。

(完)

椭圆曲线数字签名算法(ECDSA)为比特币系统运转的可靠基石.

私钥: 随机生成的32byte(256位)数字

公钥: 分为压缩公钥(33byte)和非压缩公钥(65byte)

签名: 对私钥进行HASH运算. 由签名和私钥可推出

地址: 为方便交易而使用的公钥替代物(25byte)

私钥→公钥→地址, 这一过程是不可逆推的.

tx hash id = SHA256(SHA256(tx data))

tx fee = sum(input) - sum(output)

/* 计算tx hash id

* in JavaScript

*/

hex = new Buffer(tx_data, 'hex');

B_hash = crypto.createHash('sha256').update(crypto.createHash('sha256').update(hex).digest()).digest();

// 将Big-Endian转化为Little-Endian

L_hash = Array.prototype.reverse.call(B_hash);

txid = L_hash.toString('hex');每个tx只会在best chain(主链)的某一个block里出现一次, 但可能出现在其他分支中.

每生成210000个block时(4年左右), 来自coinbase的奖励减半. 计算方法: 50 >> (height / 210000) + Fees

全网达到2100W个btc后将不再有coinbase的奖励, 而挖矿收入来源仅剩下Fees(交易矿工费)

BTC系统中, 产生coinbase即发行货币

block大约每10分钟生成一个, 时间由全网算力调整.

挖矿: 即工作量证明. 其实质为计算block hash(生成新的block)的过程, 成功(加入best chain)概率为n%, 即该节点算力占全网的百分比.

区块头(block header)包含"前一个block header的hash"(32byte), "该block中全部tx打包的hash"(32byte), "时间戳"(4byte), "难度"(4byte), "随机数"(4byte)

block hash计算方法: 将header连接得到16进制表示形式, 按little-endian存入内存, 两次SHA256计算得到hash, 最后逆序.

hex = new Buffer(header, 'hex');

hash = crypto.createHash('sha256').update(crypto.createHash('sha256').update(hex).digest()).digest();

revhash = Array.prototype.reverse.call(hash).toString('hex');分支博弈

因为多个挖矿节点的存在, 必然会导致不同block chain的产生, 而网络会根据如下优先级顺序来选取那条block chain作为主分支:

如果各挖各的矿, 会存在多分枝并存, 这时每个分支都有可能成为主链, 而算力最强的节点一定得到最长链. 如果一个节点的分支不是主分支, 则其收益也不会得到认可, 导致0收益. 所以为了降低此风险, 很多节点会联合在一起, 贡献一个分支, 使其保持最长.

多重消费问题

先用btc消费, 使tx进入一个block, 然后构造另一个包含该tx的block, 使相同的输入作为这个tx的输入, 而输出设定为自己的btc地址, 然后计算这个block hash, 并追赶主链, 一旦成功则相当于该tx包含的btc未花费, 就可以再次使用这些btc. 但攻击者能成功追赶并改变主链是一个小概率事件.

看完libuv对watchers和事件循环的描述之后,突然发现我一直以来忽略了一个问题:事件是通过什么方式被监听的?

无论是线程还是进程都和我们生物不同,他们不会自发感知外界环境的改变。所以对于这个问题,第一印象往往是:轮询。也就是用一个 while(true) 循环不断询问外部是否有什么新鲜事。

可问题是,我们从来没见过系统内核进程因为监听一個socket而导致CPU狂转、系统挂掉吧。还有,浏览器中监听JavaScript事件是常事,它也没让系统变卡顿啊。

单从这一点来看,轮询事件的产生并非上策!除了轮询,还有什么方法能做到事件的监听呢?或许我们可以从操作系统的底层——计算机硬件工作流程中找到答案。

操作系统在与外设进行交互是典型的事件监听:CPU与设备控制器之间有一条中断请求线,设备控制器会在外设I/O结束时通过电信号向CPU发送中断请求,CPU在原子指令过后检查中断线的状态位判断I/O是否结束,如果结束的话就跳转到内存特定进程位置(中断向量)调度中断处理程序。

我们先来简单分析一下底层的事件监听模型。所谓事件是由源发出,就是一个电信号(或脉冲信号)。进程虽然做不到监听,但硬件CPU却可以,它能接收到电信号的变化。最后CPU对事件做出反应,也就是调度处理进程。

没错,事件监听还可以靠中断来实现。

阻塞I/O、非阻塞I/O、同步I/O、异步I/O是操作系统的几大I/O模式。

我们往往会认为阻塞I/O与同步I/O等同,非阻塞I/O与异步I/O等同。其实这种观点是不准确的,这里科普一下他们的细微区别。

阻塞I/O,即进程/线程在做I/O操作时,被CPU调度到阻塞队列,等待I/O操作的结束,然后进程再被调度回来,处理I/O结果。在等待期间,进程除了休眠无法做任何事情,不过他不占用CPU时间片,这时CPU可以先调度其他进程,当I/O完成时以事件形式通知CPU。

非阻塞I/O与上述相反。进程不会一直等待到I/O操作结束,当I/O请求发出时,进程会立马从系统调用返回,这时进程可以继续工作,也就是CPU不必将其调度到阻塞队列了。但此时进程很可能还没有得到I/O结果,所以要通过轮询来检验I/O是否操作结束。虽说进程没有被阻塞,不过CPU的时间片被白白占用。

同步I/O,就是进程先等待I/O结果,再继续处理其他任务。所以说,同步I/O由阻塞I/O实现。

而异步I/O与非阻塞I/O的差别就是:前者的I/O调用在不阻塞进程的前提下完整的执行,后者的I/O调用为了不阻塞进程会立刻返回,即便是没有得到I/O最终结果。

上面提到的阻塞和非阻塞是针对_进程_而言的,和_CPU_的阻塞正好相反,这点必须要认清。

libuv在Linux平台上使用了Linux的_epoll_机制。epoll是Linux平台的I/O事件通知工具,主要用来处理大量的文件句柄。

libuv的事件循环特性就是由epoll提供的,先介绍一下epoll。

epoll的函数在头文件sys/epoll.h中。用epoll编写程序会用到两个数据结构:

/* 保存触发事件的某个文件描述符相关的数据 */

typedef union epoll_data {

void *ptr;

int fd;

__uint32_t u32;

__uint64_t u64;

} epoll_data_t;

和

/* 用于注册所感兴趣的事件和回传所发生待处理的事件 */

struct epoll_event {

__uint32_t events; /* Epoll events */

epoll_data_t data; /* User data variable */

};其中结构体epoll_event的events成员是表示感兴趣的事件和被触发的事件,可能的取值为:

EPOLLIN:表示对应的文件描述符可以读; EPOLLOUT:表示对应的文件描述符可以写; EPOLLPRI:表示对应的文件描述符有紧急的数据可读; EPOLLERR:表示对应的文件描述符发生错误; EPOLLHUP:表示对应的文件描述符被挂断; EPOLLET:表示对应的文件描述符有事件发生;

epoll提供的API有如下几个函数:

int epoll_create(int size)

创建一个epoll实例,并返回一个引用该实例的文件描述符。

int epoll_ctl(int epfd, int op, int fd, struct epoll_event* event)

在给定文件描述符增加、删除、修改事件。

int epoll_wait(int epfd, struct epoll_event* events, int maxevents, int timeout)

等待I/O事件,并阻塞调用线程。

最后一个timeout参数表示epoll_wait的超时条件,为0时表示马上返回,为-1时表示函数会一直等下去直到有事件返回,为任意正整数时表示等这么长的时间,如果一直没有事件,则会返回。

对于这几个函数的使用,man手册里给出一个很有代表性的例子:

#define MAX_EVENTS 10

struct epoll_event ev, events[MAX_EVENTS];

int listen_sock, conn_sock, nfds, epollfd;

/* Set up listening socket, 'listen_sock' (socket(),

bind(), listen()) */

epollfd = epoll_create(10);

if (epollfd == -1) {

perror("epoll_create");

exit(EXIT_FAILURE);

}

ev.events = EPOLLIN;

ev.data.fd = listen_sock;

if (epoll_ctl(epollfd, EPOLL_CTL_ADD, listen_sock, &ev) == -1) {

perror("epoll_ctl: listen_sock");

exit(EXIT_FAILURE);

}

/* 这里相当于事件循环的开始,epoll先阻塞进程,等待指定事件到来 */

for (;;) {

nfds = epoll_wait(epollfd, events, MAX_EVENTS, -1);

if (nfds == -1) {

perror("epoll_pwait");

exit(EXIT_FAILURE);

}

/* 一旦事件触发,继续事件循环,这里获取事件触发时的数据 */

for (n = 0; n < nfds; ++n) {

if (events[n].data.fd == listen_sock) {

conn_sock = accept(listen_sock,

(struct sockaddr *) &local, &addrlen);

if (conn_sock == -1) {

perror("accept");

exit(EXIT_FAILURE);

}

setnonblocking(conn_sock);

ev.events = EPOLLIN | EPOLLET;

ev.data.fd = conn_sock;

if (epoll_ctl(epollfd, EPOLL_CTL_ADD, conn_sock,

&ev) == -1) {

perror("epoll_ctl: conn_sock");

exit(EXIT_FAILURE);

}

} else {

do_use_fd(events[n].data.fd);

}

}

}然后我们回过头看看Node(或者说libuv)内部是如何实现事件循环、事件监听、异步回调的。

libuv负责从操作系统那里收集事件或监视其他资源的事件,而用户可以注册在某个事件发生时要调用的回调函数。

监视器(Watchers)是 libuv 用户用于监视特定事件的工具。他们都是以 uv_TYPE_t 命名的抽象结构体,这个类型表明了监视器的用途。

下面是所有的监视器(也称作事件处理器)列表:

typedef struct uv_loop_s uv_loop_t;

typedef struct uv_err_s uv_err_t;

typedef struct uv_handle_s uv_handle_t;

typedef struct uv_stream_s uv_stream_t;

typedef struct uv_tcp_s uv_tcp_t;

typedef struct uv_udp_s uv_udp_t;

typedef struct uv_pipe_s uv_pipe_t;

typedef struct uv_tty_s uv_tty_t;

typedef struct uv_poll_s uv_poll_t;

typedef struct uv_timer_s uv_timer_t;

typedef struct uv_prepare_s uv_prepare_t;

typedef struct uv_check_s uv_check_t;

typedef struct uv_idle_s uv_idle_t;

typedef struct uv_async_s uv_async_t;

typedef struct uv_process_s uv_process_t;

typedef struct uv_fs_event_s uv_fs_event_t;

typedef struct uv_fs_poll_s uv_fs_poll_t;

typedef struct uv_signal_s uv_signal_t;监视器是通过调用uv_TYPE_init(uv_TYPE_t*)函数来创建。

Note:如上所示,有些监视器初始化函数要用事件循环作为第一个参数。

让监视器监听事件则调用:uv_TYPE_start(uv_TYPE_t*, callback)

而停止监听则调用:uv_TYPE_stop(uv_TYPE_t*)

回调函数是当监视器感兴趣的事件发生时,由 libuv 调用的函数。应用程序指定的逻辑一般会在回调函数中的实现。

只要有活动的监视器,事件循环就会一直运行。没有活动的事件监视器, uv_run() 退出。

ex:

#include <stdio.h>

#include <uv.h>

int64_t counter = 0;

void wait_for_a_while(uv_idle_t* handle, int status) {

counter++;

if (counter >= 10e6)

uv_idle_stop(handle);

}

int main() {

uv_idle_t idler;

uv_idle_init(uv_default_loop(), &idler);

uv_idle_start(&idler, wait_for_a_while);

printf("Idling...\n");

uv_run(uv_default_loop(), UV_RUN_DEFAULT);

return 0;

}系统运行中会在监视器启动时给事件循环引用计数加 1,而在监视器停止时给事件循环引用减 1。也可以手动修改处理器引用计数:

void uv_ref(uv_handle_t*);

void uv_unref(uv_handle_t*);使用这些函数可让事件循环在监视器处于活动状态下退出,或让事件循环使用自定义对象来维持其活动状态。

在笔记1中介绍了Node主线程与libuv I/O线程、事件循环的协作关系,这里我们总结一下Node的工作原理。

在Node启动时,主线程内先初始化一些必要的Watchers,比如I/O Watchcers,然后解析js文件,调用相应的libuv函数,最后执行libuv的事件循环函数,先检查watchers队列是否有到来的事件,有就在当前线程中处理,没有阻塞主线程,等待事件唤醒(epoll实现)。

对于js文件中调用libuv函数的语句,将会执行相应函数,利用epoll机制开启一系列I/O线程,设置watchers的回调函数,调用底层API,并进入阻塞态等待调用结束。系统调用结束,返回结果,I/O线程将返回结果赋给watchers回调函数的参数。同时向epoll机制提交状态。

主线程中epoll将再次激活事件循环,从阻塞处向下执行:调用watchers的回调函数。直到再次阻塞在epollwait那里(如果程序并没有设置listen,事件循环在下次检测不到新的事件时就退出循环(引用计数减1),结束程序,例如“文件读取”。如果http上调用了listen函数,将会不断的检测事件的到来~,即引用计数保持为1)。

上面讲的情况都是I/O,可是事件循环处理的事件不仅仅是I/O事件,还包括process.nextTick产生的Idle事件,计时器的定时事件,setImmediate的check事件。

而我们发现了一个优先级顺序:idle观察者 > I/O观察者 > check观察者。也就是说事件循环每次都是按这个顺序来依次检查watchers的。

进一步的实验我们将会发现:idle观察者和I/O观察者将会在一次事件循环中调用队列中的所有回调函数,而check观察者每次之调用队列头中的回调函数。

读了两年大学,突然发现我们现在最缺的就是ideas。在多方_邪恶势力_的压迫下逐渐丧失了发现事物,思考问题,解决问题的能力,对周围的东西找不出关键点,对一个新技术不知道该怎么把玩能发挥其价值。一句话:没有猎奇心理。

话说,没有创意生活还有什么乐趣???

没有创意,做项目真的是在浪费时间,不如去搞搞科研呢。写几个模块,库,框架。

信息化时代的一大特点就是快速的资源共享,说的更有价值点就是知识的共享。twitter、facebook之类社交网络的火爆可以在一定程度上反应信息涟漪的扩散速度之快。这说明大多数人都喜爱聚集在一起balabala。第二大特点是信息获取方便,手边常备Google,连小白都可以装大牛 ;)

如何搜集、挖掘并利用网络上分散的碎片化信息呢?要想对网络上海量的信息做集中化分析归类处理真的很难,我想这不是我们现在该考虑的。我们应该让每个人自觉的做信息归类。

这个想法是受BitCoin的启发。BitCoins从诞生到交易,都是由用户自己的工作去完成和证实的,其整个一条区块链记录了从第一个BitCoin诞生起到现在的交易阶段的全部用户的交易信息:每个用户可以验证交易区块的正确性,一旦验证无误,将会得到一定数量BitCoins的奖励。当然这是相当耗时耗财的,因此没人愿意费力不讨好。

因为bitcoin的获取,促使人们自觉的付出劳动力去做block正确性验证,然而这一过程恰恰做到了BitCoins交易信息归档,而且是由网络上每个BitCoins用户完成的。对于每个idea的贡献也是如此:贡献者不但会了解网络中其他人经过几番讨论或深思熟虑的想法还会因自己的idea贡献而得到某种奖励。

这种思路正是P2P网络架构体系的核心:去中心化。每个节点都可以从其他各个节点获取自己想要的信息,同时作为等价节点,他也可以提供自己的信息给他人,至于信息的划分归类归档,全靠每个节点的贡献来完成,而相对的中心节点则仅仅存储分支/节点的地址。

对于好的idea,可以fork,正如GitHub上repo的fork,可以发送pull request,还可以可以merge…。就是说主分支如果满意子分支的提交,可以允许合并。

不同的idea在主分支上有自己的唯一节点,一个idea分支会记录这个idea不断完善,创新,衍生的过程以及每个人的贡献和基于该idea诞生的projects等等。

最终形成的是ideas结构化体系,做到了自动为不同的idea分类整理归档。最终形成一颗条理清晰的知识结构树。

合理利用idea进行分支、演化,取众家之精华,丰富每个idea并让它变得更有意义。

每个idea开始都是一个节点,不断进行add的话,会grown成一个链,这个idea会越来越丰富,可用之处会越来越多。当达到一定规模时,必然会有副产ideas出现,这时可以进行fork:将会产生一个新的子分支,这个idea是父idea的超集。当然,整个idea可以是private的:),仅供队友之间修改。

和个人记事,日程管理,团队协作等等工具的不同之处就是:核心不是存储想法也不是项目管理,而是建立在社交涟漪模型上进行折射分享,以ideas为社交目的,让每个感兴趣的人参与进来,形成一个ideas共享树。

没有圈子、好友、留言、个人信息。有创建的idea分支,标签,建议,贡献内容,应用idea的项目。

最开始时会有一个主干节点,我们会在上面添加初始的idea集合初步形成一个分支。每个org或个人都有权限修改这个主分支。

我们每隔一段时间搜集生活中的细节,互联网上的变革,通过算法选取那些值得思考的关键词,最后推送到主干分支上。

参与人数增长率特快的idea暂时将会排名上升,一旦人数足够多将稳定排名一段时间,而那些新生的idea应该靠前排名,贡献者、参观者数量波动小的idea暂时将会下降排名。

NOTE1: 关于剽窃他人创意这个问题自古以来就有。主要和个人素质、占有欲、控制欲、自私心理有关。

如果想剽窃他人的idea,不如贡献一下自己的点子吧,和他们一起完善这个idea,并从这个idea中分支出自己的:)

实在不行就面壁吧~~

我可以创建一个idea,随意描述想法,并直接扩展出已想好的子分支,然后我就成为这个idea树的创始人。这颗idea树可能会在explorer里出现。这时恰巧你也在考虑这个问题,或想寻找有关这个idea的讨论,然后你就发现了这个idea,你不能删掉我创建的分支、节点,但你可以修改(讨论)或直接fork成你的,并在此基础上删改。

别忘了,人类是地球上最富有创造力的群体,他们发明了汽车与电灯,改进了工具使用方式。各具特色而又层出不穷的创新,将人类文明一步步推向巅峰。归根结底创造力是我们不可或缺的东西、上帝给予我们的最佳馈赠。

NOTE2:incbrain,可以解释成increasing brain 或 brain with innovation and creative

fix bugs:

新增功能:

今天简单的看了看色彩学和颜色理论,终于明白视觉错觉和基色选择的原理,涨了不少姿势。

在玩前端时没少和颜色打交道,大多时间里也都是选选配色。其实我觉得配色不仅仅是看着颜色表一个个试,还应该有混色计算,补色计算等等,例如你想写一个图像处理的软件,其中的反色,混色,颜色渐变等等就需要考虑了。

高中物理讲过,“红(R)、绿(G)、蓝(B)” 是光的三原色,也称三基色。在做网页配色时常见的RGB值指的就是红绿蓝三色各自强度值以16进制表示的拼接值。

三种色光按不同比例混合就能得到所有颜色(七色)的色光,而同等强度的三基色混合,就会出现灰色,灰色代表一个范围(不含色光):[ 纯黑, 纯白 ],其间任何一种颜色都属于灰色。

要说混色理论,首先得了解一些颜色的基础知识。

除了三基色RGB,还有另外一种三基色CMY。按人眼能观察到的颜色来源分类,前者属于光源三基色,如灯光、显示器;而后者属于染料三基色:青(C)、洋红(M)、黄(Y),如报纸、书等本身不发光的物体。

其实染料三基色也是基于光源三基色而得到的。因为青色吸收红色,洋红吸收绿色,黄色吸收蓝色,这样就再次组成了红绿蓝三基色,通过控制CMY各自的强度,同样达到产生各种色彩。

下面简单介绍RGB三原色的混色计算。

由于不同波长的色光叠加会产生另一种色光,而且这一叠加可能蕴含某种规律。我们将三原色各自的强度以二位16进制数字表示,也就是将强度人为分成256个点。先从最简单的黑色#000000,白色#FFFFFF考虑。黑色是三色皆尽,白色是三色至上,而#000000 + #FFFFFF = #FFFFFF,也就是说“在伸手不见五指的黑夜里手电筒里射出的是白光”,数字的设定恰好符合感官的描述。

对于基本的混色计算,我们可以从单一颜色来分解:比如颜色值#60b044,可以拆成颜色1#600000、颜色2#00b000以及颜色3#000044三色光的叠加,当然,其他值的组合也行,只要满足R的加和是60,G的加和时b0,B的加和是44。所以,任意色的普通混色就是对应相加。

CMY的同理,只不过是RGB的补色运算,即:

CMY:(x,y,z) => RGB:(#FF-x,#FF-y,#FF-z)

这样我们就可以写一个混色函数:

function mix(ca, cb) {

r = ca >> 16 + cb >> 16

g = ca & 0xff00 >> 8 + cb & 0xff00 >> 8

b = ca & 0xff + cb & 0xff

return (r > 0xff ? 0xff : r) << 16 + (g > 0xff ? 0xff : g) << 8 + b > 0xff ? 0xff : b;

}bobobob

历经3个月yinle.me终于能以正常的姿态见人了。idea最初起源于一个已经不在Lab的学长,我对这个想法很感兴趣(已经被打印问题困扰很久了),想想今后要是能用上这样一个东西,打印岂不是美哉快哉?

从寒假开始写前端的逻辑&UI,为了加快响应时间、提高脚本效率,同时保持松耦合以及模块化,我重头到尾写了yinle的前端逻辑框架、动态响应式布局外加一个独立的拖拽事件库。技术栈的这一层真没少下工夫。

后台业务处理部分我们最初选择了Ruby Sinatra框架,这一块是由另一位同学负责,后来因其为忙于其他多个项目,Lab里个忙各的,最后不得不交由我来搞。对Ruby代码,刚开始看着挺清晰,但是越看越迷茫…也不能现学现做吧。折腾了一两天,把代码写的乱七八糟,自己都不忍直视了。。于是我决定,干脆拿Node.js重写一遍算了,总比在这里纠结好。

我也是急急忙忙敲了一晚上,把原型做出来了。第二天陆陆续续修正bugs,增加安全机制,过滤检测模块。下午部署到了Lab服务器上,在内部测试了一下,绑定域名,然后就这样上线了。

说实话,当时心里还是有点没底,毕竟匆忙上线,还不知道有什么问题。昨晚模拟了一次次攻击,对一些模块进行了反复的测试,终于有点信心了,然后做了小范围的宣传。

目前功能:

细节更新:

bugs fixed:

安全性检测:

近两年用Node写过几个web应用。过程远比预期的困难,涉及到了HTTP协议、TCP/IP协议、WebSocket协议等计算机网络知识,MongoDB、noSQL、schema设计等NoSQL数据库知识,进程、线程、同步、异步、并发、阻塞、文件系统、锁等操作系统知识,这些都是超出Node范畴的东西。然而Node中却处处提到他们,而Node的核心也构建在大多数这些基础知识之上,我觉得仅仅是“使用”并不能让你真正理解精髓。所以,要想理解&精通Node,需先广泛汲取必备知识,这也是我为毛要学习底层的原因。

这篇笔记记录了我学习libuv的过程,包括对一些模糊概念的解释,Node事件机制的实现。

没错,libuv就是Node两个核心架构(libuv + V8)之一!

/* note: 操作系统默认为*nix */

先获取libuv的源码。git clone下来github上的项目或通过HTTP访问dist页面下载,当时的版本是 libuv-v0.11.17 。

编译源码。过程很简单,我们可以参照README进行构建,这里提供了两种方式:

1.通过autotools:

$ sh autogen.sh

$ ./configure

$ make

$ make check

$ make install2.通过GYP自动构建工具(我采用了第一种方式)

make会自动在/usr/local/lib目录下增加编译libuv应用程序使用的动态/静态链接库:libuv.so和libuv.a,同时在/usr/local/include目录下添加uv.h头文件。

源码编译通过后就可以开始学习之旅了。可以根据joyent的wiki或者源码注释详细的学习libuv的实现与使用方法。目前网上有一份官方英文版的初步介绍libuv的doc“An Introduction to libuv”。

我会按照上面提到的文档中目录的顺序写这篇笔记,并且只要大学认真的学过C语言就能读懂代码。

libuv是Node.js底层架构的一部分,作为异步I/O库,为Node提供了事件循环与回调机制以及对POSIX标准系统API的访问能力,例如:Socket、FileSystem、Process、Thread以及进程间通信等ECMAScript标准中不具备的。

在libuv之前也有一个名为libev的库,只不过libev仅适用于*nix,对Windows并没有提供支持。而libuv封装了Windows平台和Unix平台一些底层的特性,对外提供了一套统一的API。

Node对外宣传自身无与伦比的并发性能时常常提到“单线程异步无阻塞I/O模型”,不过大多数人刚开始接触Node时总存在这样几个疑惑:

为了解决这些问题,我们必须从底层的libuv入手。 其实在Node启动后至少跑起了两个线程:V8引擎线程和libuv线程。v8用来解析执行JavaScript语法,libuv在最后开启事件循环和监听器,检查并捕捉异步I/O完成后传来的消息。(这里不要误解,并不是说Node一启动就开俩线程,而是在一个主线程中执行v8 C++代码和libuv C代码,只是libuv涉及到了启用多线程)

我们的问题都能在下面这个例子中得到解答。

/* step 1 */

var http = require('http');

var fs = require('fs');

/* step 2 */

console.log('first interrupt');

/* step 3 */

http.createServer(callback).listen(8080);

/* step 4 */

console.log('output early');

function callback(req, res) {

var buffer;

req.on('data', function (data) {

buffer += data;

});

res.end(data);

}所谓“单线程”是指Node中主线程,所有的JavaScript代码都在这个线程中被解析执行。命令node app.js之后,Node线程按照注释中step的顺序解析代码。

step 1解析后涉及到文件的同步读取操作,后台libuv文件读取函数调用完成后,进入step 2,执行同步的控制台输出语句,step 2完成,开始step 3创建http服务器的异步函数。v8解析执行完毕后,将会调用libuv的网络相关函数。

与此同时,被调用的libuv函数将生成一个对象req,包含来自V8提供的参数信息、将要调用的底层函数的指针。然后为对应的I/O Wathcer注册一个参数为对象req的回调函数,之后开启一个I/O线程用来处理I/O请求,这个I/O线程首先将对象req中的底层函数指针提取出来以执行这个函数,这个函数调用POSIX系统网络访问API,做一个系统调用,从用户态陷入内核态,交由操作系统内核进程完成主机端口的监听并通过操作系统注册一个消息监听器以便任务完成时通知I/O线程。

当I/O线程接收到来自操作系统的调用完成消息通知,把调用结果赋给对象req的result属性,随后将req加入对应的I/O Watchers队列里。

从这里开始,Node主线程的前三个任务完成,立即开始step 4的控制台输出。

而后libuv的工作就是做事件循环检测到来的事件。事件循环依次询问各种类型的Watchers是否有完成的事件?Wathcers开始检查自己的队列是否有req对象,如果有的话,通知事件循环“是”,然后事件循环将req对象依次出队做Wathcers的参数执行之前绑定的回调函数。在这个回调函数中,会检查req对象的V8传入参数,如果V8线程传入了callback,就以req的result属性为参数在主线程中调用callback。

然后事件循环会继续检测本次循环中是否还有活跃的(产生新事件)监视器,如果没有的话就退出事件循环程序结束,否则接着循环。

以上回答了第一和第三个问题,不过“事件循环”究竟是啥还没有回答清楚,接下来先简单的解释一下事件循环。

事件循环是libuv中捕获广播事件的一种机制,它类似一个循环的结构。Linux系统下该机制由epoll轮询实现:当Node启动时,代码最后开始第一次事件循环,如果此时没有事件发生,就阻塞进程,让出CPU。当新的req对象加入Watcher队列(也就是内核完成了I/O操作),激活事件循环,并再次询问Wathcer是否有事件到来,如果有就调用对应Watcher的回调函数,然后询问其他Wathcers是否还有待处理的事件,没有的话退出事件循环。下面是epoll实现的事件循环模型:

while (true) {

epollwait(core_events); // 内核没有发送I/O事件就阻塞循环

while (new events in Watchers)

while (Watcher[i].queue NOT NULL)

execute Watchers[i].callback with args req;

}

使用libuv编写Node模块扩展就会发现这个“事件循环”由uv_run函数启动。按照libuv参考的说法,该函数封装了事件循环,通常最后调用,并传入uv_default_loop参数来获取默认的事件循环:(Node使用默认事件循环作为主循环)

这里给一个官方的小例子,跑一个新的事件循环:

#include <uv.h>

#include <stdlib.h>

int main() {

uv_loop_t *loop = uv_loop_new();

printf("Now quitting.\n");

uv_run(loop, UV_RUN_DEFAULT);

return 0;

}how to run it?

注意最开始提到的libuv.so,这是编译时必须引入的,如果直接gcc -o test test.c会编译出错。

gcc -o test test.c -luv

./test对于事件循环,epoll的实现机制是透明的。不过关于“epoll如何捕获内核I/O事件”仍是个问题,网上查阅大量资料无果。

仍需继续阅读libuv和Node源码。

Bitcoins 结构简图

Bitcoins:{

BlockChain <Master>:{

Block0:{

Transaction0 :{ …… }

Transaction1 :{ …… }

Transaction2 :{ …… }

……

}

Block1:{

Transaction0 :{ …… }

Transaction1 :{ …… }

Transaction2 :{ …… }

……

}

……

}

BlockChain <Abandon>:{

……

}

……

}

货币的主要用途是交易,BitCoins也自然如此,因此交易(Transactions)作为BlockChains的原子构成(从上图可知)是很重要的。

每个Block都是由多条Transactions(简写为Tx)组成。每条tx记录了每笔Bitcoins交易的详细信息。

每个Block的首条tx记录被称为Coinbase tx。其特点是只有输出而没有输入,因为这条tx是Bitcoin系统为了回报_挖矿_而生成的Bitcoin奖励。(这也是Bitcoins的发行方式)

该Block中其余的tx都是允许有几个输入和几个输出。输入代表从前一比交易中获得bitcoins,输出代表花费(其实是转帐)目前这笔交易中的bitcoins。一旦某个Tx的一个输出成为另一个Tx的输入,那么该笔比特币即为已花费。

每笔tx有在此block中唯一的Hash值来标识,它是通过对交易数据做两次SHA256加密运算得出。

这些tx信息是全网公开的,以明文形式存储(比特币系统里的所有数据都是明文的),只有当需要转移货币所有权时,才需要用私钥签名来验证。

{

# hex包含了这个tx的全部信息,以下内容均可由hex解析出来

"hex" : "……",

# txid由hex键经过两次SHA256加密生成

# Note:运算结果结果应该是按小端字节次序(little endian)读取的

# 唯一标识了这个交易

"txid" : "……",

# 本次交易的版本号

"version" : 1,

# 在给定时间之前该交易信息被“锁定”(即不能被录入到blocks中)

"locktime" : 0,

# generation交易的输入,为一个数组

"vin" : [

{

"coinbase" : "……",

"sequence" : 4294967295

}

],

# 交易的输出,同为一个数组

"vout" : [

{

"value" : 50.01000000,

"n" : 0,

"scriptPubKey" : {

"asm" : "……",

"hex" : "……",

"reqSigs" : 1,

"type" : "pubkey",

"addresses" : [

"1LgZTvoTJ6quJNCURmBUaJJkWWQZXkQnDn"

]

}

}

],

# 标记这个tx属于哪个blocks

"blockhash" : "……",

"confirmations" : 145029,

"time" : 1301705313,

"blocktime" : 1301705313

}

{

# 键名与含义大至于上面的相同,唯一区别是“vin键”,下面有解释。

"hex" : "……",

"txid" : "……",

"version" : 1,

"locktime" : 0,

# 普通tx的输入

"vin" : [

{

"txid" : "……",

"vout" : 0,

"scriptSig" : {

"asm" : "……",

"hex" : "……"

},

"sequence" : 4294967295

},

{

"txid" : "……",

"vout" : 1,

"scriptSig" : {

"asm" : "……",

"hex" : "……"

},

"sequence" : 4294967295

},

{

"txid" : "……",

"vout" : 1,

"scriptSig" : {

"asm" : "……",

"hex" : "……"

},

"sequence" : 4294967295

}

],

"vout" : [

{

"value" : 0.84000000,

"n" : 0,

"scriptPubKey" : {

"asm" : "……",

"hex" : "……",

"reqSigs" : 1,

"type" : "pubkeyhash",

"addresses" : [

"1A3q9pDtR4h8wpvyb8SVpiNPpT8ZNbHY8h"

]

}

},

{

"value" : 156.83000000,

"n" : 1,

"scriptPubKey" : {

"asm" : "……",

"hex" : "……",

"reqSigs" : 1,

"type" : "pubkeyhash",

"addresses" : [

"1Bg44FZsoTeYteRykC1XHz8facWYKhGvQ8"

]

}

}

],

"blockhash" : "……",

"confirmations" : 147751,

"time" : 1301705313,

"blocktime" : 1301705313

}

以上,第一个block中的首笔交易,第二个是含有三输入两输出的普通交易。

注释已经注明,他们之间的区别是在vin(交易来源)字段:

对于首笔交易自然没有输入,其vin字段的值为:

{

# coinbase字段允许挖矿者写入自定义的信息,

# 如中本聪在首个 block 的首条 transaction 中写入了:

# “04ffff001d0104455468652054696d65732030332f4a616e2f32303039204368616e63656c6c6f72206f6e206272696e6b206f66207365636f6e64206261696c6f757420666f722062616e6b73”

# 转码过来之后就是:

# “The Times 03/Jan/2009 Chancellor on brink of second bailout for banks”

"coinbase" : "……",

"sequence" : ……

}

普通交易的vin字段:

{

"txid" : "……",

"vout" : 0,

"scriptSig" : {

# 公钥

"asm" : "……",

# 签名

"hex" : "……"

},

"sequence" : ……

}

上面已经说了,txid是由hex生成的,下面就是txid的计算方法:

funtion getTxid(hex) {

bin = new Buffer(hex, 'hex');

buf_BE = crypto.createHash('sha256').update(crypto.createHash('sha256').update(bin).digest()).digest();

buf_LE = Array.protptype.reverse.call(buf_BE); // 转换为小段次序

txid_hash = buf_LE.toString('hex');

}

Note:其他字段解释(引自比特币实验室)

sequence:若该笔交易的所有输入交易的sequence字段,均为INT32最大值(0xffffffff),则忽略lock_time字段。否则,该交易在未达到Block高度或达到某个时刻之前,是不会被收录进Block中的。

lock_time:是一个多意字段,表示在某个高度的Block之前或某个时间点之前该交易处于锁定态,无法收录进Block。

0 立即生效

< 500000000 含义为Block高度,处于该Block之前为锁定(不生效)

= 500000000 含义为Unix时间戳,处于该时刻之前为锁定(不生效)

从解析后的Transaction结构中,可以得到每个tx的每笔花费信息,包括花费数量、转帐地址以及后续交易的hex等等,如:

{

# 本次转帐金额

"value" : 0.84000000,

"n" : 0,

# 公钥

"scriptPubKey" : {

"asm" : "……",

"hex" : "……",

"reqSigs" : 1,

"type" : "pubkeyhash",

# 转帐地址

"addresses" : [

"1A3q9pDtR4h8wpvyb8SVpiNPpT8ZNbHY8h"

]

}

}

爬虫常被看作是一个边缘hack技术。通过别人的前端页面获取数据似乎为人所不耻,但是不管人们怎么评价它,爬虫的作用就摆在那里,有用没用全取决于你的目的。

为什么在互联网这片浩瀚的海洋里,我仍然旧事重提?起因与我最近做的事有关。

如果说让你爬取一个网页,你会怎么做?

OK,你很可能会说这很简单:“拿一个HTTPClient请求一下那个URL不就行了”。

对于普通网页,可能很顺利的就拿下了,那么对于如下几种情况,该怎么办呢:

我把以上情景大致分为两类:

拒绝访问的一般就是在Web server上做了爬虫防范措施。当有客户端请求数据时,对其进行检测,如果判断为浏览器,则允许与自己通信,否则就可以用各种方法为难客户端,比如:close这个socket(切断连接),返回非浏览器客户端不懂的redirect 302或非法访问等等。

至于如何断定该客户端就是浏览器或一定不是浏览器,有好多方法,打开network流量监视器,可以看到每个请求的详细内容,服务器可以检查:

Referer,Host,User-Agent,因为这些是浏览器最具代表性的字段。

一般我们把这几个字段也一同提交过去大多数服务器就能被搞定了,但随着技术的进步,防范措施也在不断改进。

但对于最后一种情况,你可能会很头痛并且百思不得其解,这也是我在实际操作中遇到的问题。

我在爬取一个看似再正常不过的页面时,爬取工具竟然crash了!排除网络问题,我又详细的看了几遍浏览器中的请求头,以及是否有明显的redirect痕迹。结果很遗憾:network控制台仅显示了一个请求,响应码为200!:

这个问题很蹊跷,先不管爬虫怎么崩的,把浏览器的所有请求头发过去试试再说。结果令我意外的是爬虫再次崩溃了!我再次检查了请求字段是否写错,然后排除了请求头的问题。

既然不是请求头的问题,那这个服务器究竟是靠什么判断客户端类型的呢?这个我当时真的没想明白。

这下几乎头绪全没了。我真想到了302 redirect,但控制台里完全没有这个请求啊,有的只是个200。

而后我又拿wget将这个页面下载了下来,打开一看,大吃一惊,竟然完完整整的下载下来了!

看wget的log,在请求的阶段,确实存在一个目标地址临时转移,也就是说确实有返回302这么一个过程。继续看,发现location竟然是自己。

到这里我终于明白爬虫为什么crash了,原来这货在往死循环里跳!

但问题仍为解决,如果说真的是redirect loop,那浏览器也应该请求失败才对啊,况且我把请求头都加进去了,按理来说应该伪装成了浏览器。但却失败了。

我想了好久,302 location为自己这肯定没错了,问题一定出在请求信息上。既然浏览器没进入死循环,那么说明一定在某个条件下停止了,并且绝对不是在第一次请求时就得到页面!在这一系列请求中,好多字段都是不变量,能让条件改变的,应该只有双方交互用的cookies了。但之前我已经说过,把所有字段都添加进去了,当然也包括cookies,为什么就失败了?因为cookie在这个循环中是变量!而服务器是在至少第二次循环请求中通过检测上一次为客户端设置好的cookies来判断客户端类型的:只有正确携带上一次设置的cookie的客户端才是真正的浏览器!我突然觉得这个想法非常靠谱,因为也只有这样了。

为了验证我的想法,我手写了一个简单的爬虫,首次请求仅传入了一个URL,然后进入递归函数,并附带浏览器请求头信息,同时把上一次服务器响应的cookies一并写入请求头,再去发起下一次请求。

这次跑爬虫时,果然不出我所料,网页的内容正确显示出来了,并且是经过了两次请求。

兴奋过后,反过来想想,这个防范构思的确巧妙,巧妙利用了redirect loop和cookie变量的特点,覆盖了流量检测工具对请求的识别(redirect loop导致仅显示了最后一个成功的请求,让人以为这仅仅是一次普通的请求,并不存在跳转),并借助“询问”的方式,检查对方能否携带正确的cookie(也就是能否明白上次给你的东西),使爬虫左右为难。

所以,解决这类问题的关键就是:无论何时,不管是否有redirect,请求头中都要附带标志性字段和变量cookie。

接下来谈谈允许访问时的爬取失败情况。

这类例子很常见。尤其是在动态加载的网页里,大部分内容是由script标签和Ajax技术异步加载,这样我们直接抓取网页必然会导致失败。通常的对策是,先分析这个页面的所有流量去向,把异步加载的那些URL全提取出来,然后再遍历这些URL做循环请求,这样反倒方便了不少,毕竟这些URL是以JSON API形式返回的,格式已经是很清晰的了,根本不用HTML解析器做麻烦的节点分析了。

但这仅仅是异步加载中的冰山一角,可能在你分析的第一步就进行不下去了:流量监测里找不到异步请求的API。

没用Ajax,也没静态加载,看起来很玄乎哈?但仔细看流量分析表里的script,他们都是异步请求的,看来数据都应该与他们有关,并且既然没有后续的数据请求了,那就说明我们所需的数据全部包含在那些异步加载的script里。那么该如何获取这些数据呢?

这时就需要一双犀利的眸子了。。。可能是在脚本的一个变量里存储着,这是我们最期望的。

对于脚本中的字符串,怎么高效处理?用match正则匹配?NONONO,那样太麻烦,eval在这里才派上大用场了,把这些脚本字符串统统传给eval。

这里顺便说个题外话,关于eval,大家虽然知道他强大,却也惧其三分,原因在于eval载全局环境下执行代码导致结果是不可预测的,这个例子中就完美的证实了这一点,不过细节我就不说了。

回到正题,假设我们并没有在某些显示变量中发现要找的数据,而是藏在函数参数中或函数作用域内。

仍然采用高效的办法:把字符串中的所有函数,对象在外部重新声明一下,然后在数据出现的那个函数体里手动构造全局变量,指向参数或者局部变量,等eval调用完毕,全局变量里存放的就是抓取的数据了。期间涉及到的技术内幕之一是可能需要对字符串中的重叠变量进行替换,replace是个不错的选择。

下面该处理爬虫返回的数据了,对于JSON数据或者JSONP返回的数据很好办,我们主要是解析“爬”下来的东西,也就是一大堆混乱的HTML代码,各类编程语言都有HTML/XML节点解析库,比如说JavaScript中的cheerio,有了这样的工具干起活来也相对容易。

以上就是这两天的技术总结。关于爬虫还有好多话题待挖掘,这篇工作日志里就不详谈了。

刚刚我从原博客里拿出了几篇值得保留的post放到issues上,意味着从此与Jekyll再无瓜葛了。

以前总想着要把界面设计的足够特立独行,足够别致。后来一些乱七八糟的麻烦让我觉得UI那些都是浮云,唯有实实在在的东西才值得保存,因此blog转向github issues。

我以前常在windows环境下硬盘安装ubuntu, 过程挺痛快的, 没遇到什么大波折, 我想Linux下安装windows也会一样容易吧.

先列表统计一下安装方式:

光盘方式最傻瓜, 除此之外U盘安装最简单, 每款操作系统都有U盘刻录工具, 只要把镜像交给它基本上就ok了.

不过像我这样不喜欢用寻常方法的, 就要花点时间研究研究另外两种方法了.

忽略上面那句话, 其实是被迫用其他方法的.

家里的ubuntu 13.10台式机要装windows 7, 现在手边没有光盘, 只有一个1GB的U盘, 但找到一个闲置的IDE接口老式硬盘.

难道没U盘就玩不转吗? 这怎么可能~ window装ubuntu不也是用硬盘安装的嘛~~~

ok, 玩玩在ubuntu下用外置硬盘装windows.

还好经过一番折腾终于成功了. 思路是这样的:

准备windows 的镜像文件, 比如win.iso.

找到外置硬盘:

df -lh

# 比如/dev/sdb给外置硬盘重新分区:

sudo fdisk /dev/sdb

# 看下分区表:

p

# 假设sdb被分为sdb1和sdb2两个分区

# 删除原有分区

d

# 重新创建分区

# 把整块硬盘划分为一个分区:

n

# 因为是整块硬盘, 所以参数不用更变,使用默认即可

# 现在分区变成了sdb1

# 为了制作启动盘, 所以要把分区设为可启动

a

# 因为要引导的是windows, 所以还要把文件系统类型标记为NTFS

# (HPFS/NTFS/exFAT), 编号为7

t 7

# 写入新的分区表

w

# 如果这块硬盘在分区之前已经挂在, 那么之后可能会提示无法变更分区表, 这时可以先卸载它:

# 假设挂载点为/media/ran/hd

sudo umount /media/ran/hd

# 然后执行partprobe强制内核写入新的分区表

sudo partprobe

# 如果还是提示分区表无法写入, 那么重启一下系统吧格式化分区:

# 格式化为NTFS

mkfs.ntfs -f /dev/sdb1写入windows专用引导, 学过操作系统我们都清楚, 这一步很关键.

# 我Google发现用lilo程序(类似grub的老式引导设置)可以写入windows系统引导.

# 一般ubuntu是不会安装lilo的, 因为默认是用的是grub

sudo apt-get install lilo

# 向硬盘中写入主引导记录

sudo lilo -M /dev/sdb mbr挂载镜像和硬盘

sudo mount -o loop win.iso /media/ran/iso

sudo mount /dev/sdb1 /media/ran/hd

拷贝镜像文件

# 这一步用cp还是dd都行,怎么搞都可以了

cp -r /media/ran/iso/* /media/ran/hd到这里, 一个windows启动硬盘就诞生了. 这一方法不会受限于系统的版本.

为了以后不再重复上面的步骤, 最好是把折腾到这一步的所有工作成果再保存成一个镜像文件:

# 注意block和count的选择, 要不然全盘复制可就得不偿失了.

dd if=/dev/sdb1 of=/home/ran/bak/win.isoHTML5为我们带来不少新奇的东西,除了那几个闪亮的明星“WebSocket”、“Worker”、“Canvas”等等之外,还有几个非著名演员(包括但不限于):“Blob”、“ArrayBuffer”、“URL”、“FormData”。这些小角色是用来支持二进制字节数据操作的。但Blob和ArrayBuffer的分界线似乎很模糊,我们写程序时往往会纠结应该使用哪种方式来在和Server进行数据交互,所以今天我们就把他们弄明白。

我在前几篇里简单的翻译了Node中Buffer函数和buffer对象的解释及用法。没错,_buffer_就是缓冲区的意思。“缓冲”的目之一就是为了解决设备之间I/O速度差异的问题:当一个Socket A向Socket B发送数据时,到达的比特流首先会在B的缓冲区里停留,然后再由B进行读取,如果没有这个缓冲区,B就有可能无法读取完整的数据。

当然,这里谈到的ArrayBuffer就类似刚刚所说的_缓冲区_。这些缓冲区都是按byte(字节)进行划分的。这个ArrayBuffer和Node环境下的Buffer很像,并且都是一个特殊的数组(将缓冲区作为数组来使用)。虽说Node里也有ArrayBuffer,不过和前端的ArrayBuffer稍有些区别,这里我们讨论的是浏览器端的ArrayBuffer。

如果缓冲区这个解释略抽象,那么就把他当成是一个用来装byte数据的容器吧。可以算是浏览器端最基础的数据格式了,请记住关键字:字节。这是用以区分后面提到的Blob的最好描述。

// 申请一个10byte的缓冲区

var af = new ArrayBuffer(10);

对于ArrayBuffer,HTML5还提供了几个高级的封装,用以快捷操作字节数据,我们称之为view:

比如说,Uint8Array就是利用ArrayBuffer开辟一个数组,元素类型为8bit(1byte)无符号整型的:

//10个元素的缓冲区(也就是10 * 1 byte)

var ui8arr = new Uint8Array(10);

//等价于

var af = new ArrayBuffer(10);

var ui8arr = new Uint8Array(af);

获取了view的实例,我们就可以使用实例的方法,对缓冲区进行读写。

这些view既可以像ArrayBuffer一样按数目申请空间,又可以引用已有的ArrayBuffer空间。

对于后一种情况,无论用view创建多少个实例,这些引用都是指向原始的ArrayBuffer内存地址,所以一旦对某一view的实例做了变动,其他view的实例也会变化。

注意:通过view对ArrayBuffer进行读写时,需要注意byte的读写方式,即“低位优先字节次序”和“高位优先字节次序”。

所谓字节次序是指占内存多于一个字节类型的数据在内存中的存放顺序。

举个形象的例子。将一个4byte的数0xFE051324放入内存,如果是低优先顺序,内存中的存储如下:

内存地址减小 <—— | 24 | 13 | 05 | FE | ——> 内存地址增大

如果按照高位优先顺序来存储这一数据,在内存中的实际存放是这样的:

内存地址减小 <—— | FE | 05 | 13 | 24 | ——> 内存地址增大

正好对称过来,如果仍按照“低位次序”的方式来读取,则读出来的数据就是:0x241305FE

因此,事先知道数据的读取方式很重要。那如何按照我们所期望的方式来读取呢?还要感谢HTML5,它提供了更高级的view:DataView对象,专业操作ArrayBuffer。

var af = new ArrayBuffer(10);

//使用DataView管理ArrayBuffer

var dv = new DataView(af);

DataView的实例提供了一系列读写ArrayBuffer的方法,如:

// 从ArrayBuffer索引为2(第三个byte)的元素开始,读取16位无符号整型

dv.getUint16(2);

//默认是按“高位次序”进行读写的,如果需要改成“小端次序”:

dv.getUint16(2, true);

//“高位次序” 写操作,从索引为2开始,写入16位无符号整型0xFF

dv.setUint16(2, 0xFF, false);

具体的API这里就不写了,详见W3c草案。

Blob是当前Web前端很常用的数据格式,是Binary Large Object(大型二进制对象)的缩写。代表原始的二进制数据。和ArrayBuffer类似,都是二进制数据的容器。

//可以用字符串构建Blob

var blob = new Blob(['ran aizen on github']);

//ArrayBuffer也行

var blob = new Blob([new ArrayBuffer(10)]);

从描述上来看,ArrayBuffer似乎是Blob的底层,Blob内部使用了ArrayBuffer。并且构造好的一个Blob实体就是一个raw data。既然用途差不多,那为什么一个Blob一个ArrayBuffer呢?当然,设计Blob和ArrayBuffer的目的是不同的。因为ArrayBuffer更底层,所以它专注的是细节,比如说按字节读写文件。相反,Blob更像一个整体,它不在意细节:就是那么一个原始的Binary Data,你只要来回传输就行了。

En, this is a good question~ 还记得ajax和WebSocket吗?如何用这两种技术去传输文件呢?Good!派上用场了~

先看看WebSocket:

var ws = new WebSocket('ws://chat.io');

//ok,我们建立了一个ws通信链接,接着看看数据是以什么格式传输的:

ws.binaryType // -> "blob"

当然,type的类型可以在允许的范围内自定义,不过默认是blob。也就是说,Blob可以用在WebSocket通信中,并且它就是通信中的二进制数据,对应Node中的Buffer(Node中接收到的二进制数据就是Buffer的实例)。看来使用Blob可以很好地与Node Server进行交互。

使用ajax中传文件并不是件新鲜事,我们使用的网盘或云相册几乎都用了这一方式。

var xhr = new XMLHttpRequest();

//如果要得到二进制数据,一般是文件,可以设为blob

xhr.responseType = "blob";

//上传二进制数据

xhr.send(row)

在HTML5新的标准中File对象的内部就使用了Blob,从<input>标签中获取的File对象即是一个Blob实例。

blob文件的转换,可以使用FileReader对象:

var fd = new FileReader();

//fd有几个文件读取方法,可以得到ArrayBuffer、Blob或String的数据

//可以使用ArrayBuffer读取方式,得到的会是一个ArrayBuffer实例

fd.readAsArrayBuffer(file);

//这里使用了blob的方式,所以会得到一个blob对象

//fd.readAsBinaryString(file);

fd.onload = function (e) {

//读取成功后得到ArrayBuffer

buffer = e.target.result;

};

上面的例子中,我们将一个blob文件以ArrayBuffer的形式进行读取,得到了一个ArrayBuffer的实例。

为什么要把Blob弄成ArrayBuffer?因为这样我们就可以对文件的字节进行读写了,比如说要判断一个文件的类型,就可以读取它的前两个字节,与Hash表进行匹配,等等。

其实在C / S的交互中,发送的数据往往直接就是Binary Data, 很少需要一个底层的ArrayBuffer按byte来手动构造数据。“茫茫Web,不要在意细节嘛”~

下面还有一个使用Blob的使用例子,通过Blob构造URL:

URL对象的createObjectURL方法允许传入一个blob,并得到一个临时的URL:

//假如Server响应了一个图片

var URI = URL.createObjectURL(xhr.response);

var img = document.createElement('img');

//我们可以把blob url用在这里:

img.src = URI;

document.append(img);

至于选择Blob还是ArrayBuffer,关键要看你的目的是什么。

二进制已经融入了WEB前端世界,这里仅仅介绍了两位角色,还有好多新鲜玩意等待你探索。慢慢玩吧,*年~

感谢这学期开了一门嵌入式操作系统, 纠正了我一些认识上的误区.

当涂老师提到idle进程时, 我突然想起了init,

Init是所有进程的祖先, 它是内核创建的第一个进程...

记得我们学操作系统时水笔老范说了好几遍, 已经牢牢刻在脑海里了, 所以潜意识里仍是不假思索认为init是头子. 可是仔细看idle的作用以及地位, 貌似比init进程还有高, 这就让有点怀疑当初所学的东西是不是漏掉了什么...

确实当年学操作系统时漏掉了一些重要的东西, 今天和实验室的师兄们讨论了之后终于补回来了.

当boot loader选定并加载一个内核后, 将计算机控制权交给加载的内核, 并创建一些系统函数. 当准备工作完成, 内核逻辑开始调用定义的start_kernal()函数.

start_kernal()函数的任务就是建立中断处理机制, 初始化内存管理的剩余部分, 初始化调度器, 初始化设备以及驱动等等. 最后调用rest_init()函数创建init进程(pid 1), 并将(内核)自己做为idle进程(pid 0).

init进程由内核创建, 并在用户空间执行. 它在用户空间执行upstart服务(启动脚本), 创建非系统服务并调用login程序进行用户登录控制. 下面是init的代码:

static int init(void * unused)

{

lock_kernel();

do_basic_setup();

prepare_namespace();

/*

* Ok, we have completed the initial bootup, and

* we're essentially up and running. Get rid of the

* initmem segments and start the user-mode stuff..

*/

free_initmem();

unlock_kernel();

if (open("/dev/console", O_RDWR, 0) < 0) // stdin

printk("Warning: unable to open an initial console.\n");

(void) dup(0); // stdout

(void) dup(0); // stderr

/*

* We try each of these until one succeeds.

*

* The Bourne shell can be used instead of init if we are

* trying to recover a really broken machine.

*/

if (execute_command)

execve(execute_command,argv_init,envp_init);

execve("/sbin/init",argv_init,envp_init);

execve("/etc/init",argv_init,envp_init);

execve("/bin/init",argv_init,envp_init);

execve("/bin/sh",argv_init,envp_init);

panic("No init found. Try passing init= option to kernel.");

}init函数最后执行了系统调用exec, 将可作为init程序的二进制镜像加载到内存.

现在来看看kernal space在系统启动过程中都干点什么.

the kernel looks for an init process to run, which (separately) sets up a user space and the processes needed for a user environment and ultimate login. The kernel itself is then allowed to go idle, subject to calls from other processes.

调用start_kernal()函数这一阶段称作Kernel startup stage. 阶段最后才创建init进程. rest_init代码如下:

rest_init() {

// init process, pid = 1

kernel_thread(init, NULL, CLONE_FS | CLONE_FILES | CLONE_SIGNAL);

unlock_kernel();

current->need_resched = 1;

// idle process, pid = 0

cpu_idle(); // never return

}可见idle"进程"就是start_kernal演变过来.

The startup function for the kernel (also called the swapper or process 0)

而idle的任务就是空转! 当系统中没有其他任何进程使用CPU时, 因为CPU也不能闲着呀, 所以这时调度器就把CPU控制权交给idle进程, idle进程的诞生是通过cpu_idle()函数完成的, 而这个函数永远不会返回.:

/*

* The idle thread. There's no useful work to be

* done, so just try to conserve power and have a

* low exit latency (ie sit in a loop waiting for

* somebody to say that they'd like to reschedule)

*/

void cpu_idle (void)

{

/* endless idle loop with no priority at all */

init_idle();

current->nice = 20;

current->counter = -100;

while (1) {

void (*idle)(void) = pm_idle;

if (!idle)

idle = default_idle;

while (!current->need_resched)

idle();

schedule();

check_pgt_cache();

}

}

///////////////////////////////////////////////////////////////////////////////

void __init init_idle(void)

{

struct schedule_data * sched_data;

sched_data = &aligned_data[smp_processor_id()].schedule_data;

if (current != &init_task && task_on_runqueue(current)) {

printk("UGH! (%d:%d) was on the runqueue, removing.\n",

smp_processor_id(), current->pid);

del_from_runqueue(current);

}

sched_data->curr = current;

sched_data->last_schedule = get_cycles();

clear_bit(current->processor, &wait_init_idle);

}

///////////////////////////////////////////////////////////////////////////////

void default_idle(void)

{

if (current_cpu_data.hlt_works_ok && !hlt_counter) {

__cli();

if (!current->need_resched)

safe_halt();

else

__sti();

}

}到这里我想你应该明白idle进程的由来了以及与init的关系了.

现在在linux下执行命令ps -eaf, 查看一下:

UID PID PPID C STIME TTY TIME CMD

root 1 0 0 17:48 ? 00:00:01 /sbin/init

root 2 0 0 17:48 ? 00:00:00 [kthreadd]

root 3 2 0 17:48 ? 00:00:00 [ksoftirqd/0]

root 5 2 0 17:48 ? 00:00:00 [kworker/0:0H]

root 7 2 0 17:48 ? 00:00:09 [rcu_sched]

pid为1的init进程的父进程pid为0 (第二个进程是内核进程的守护进程, 也是由内核创建), 也就是说忽略内核进程的情况下:

Init是所有进程的祖先, 它是内核创建的第一个进程

这句话是对的, init确实是所有用户级进程的祖先.

其实最初讨论话题是由调度工作谁来做展开的. 现在如果你不知道上面的内容, 你怎么想?

我最开始头脑中有这么几个策略:

schedule()函数进行进程调度.之所以会有后两个想法, 是因为我觉得每个进程都可以主动让出CPU控制权并调用schedule函数挑选就绪队列中的进程.

如果我清除的意识到init是user-space进程的话就直接排除掉了. 假设init负责了进程的调度, 那么首先由init → process_a, 如果process_a的时间片到了呢? 由于调度权在init进程, 所以这时没有任何用户空间进程可以执行, 于是idle进程篡位, 系统暂时进入空转, cpu_idle函数通过调用schedule函数才可以从就绪队列选择一个进程继续执行. 如果process_a正在执行时来了一个高优先级的进程呢? 中断之后由于没有调度器执行, 于是又进入idle的天下.

也就是说, 把调度权交给init完全就是废了, 一点用没有.

idle进程其实就是内核的一部分, 读一读它的源码你会发现它还负责调度工作:

while (1) {

void (*idle)(void) = pm_idle;

if (!idle)

idle = default_idle;

while (!current->need_resched)

idle();

schedule();

check_pgt_cache();

}脑补一下这样一个场景: 某个进程由于某些原因放弃了CPU使用权. 由于idle进程(与其说是一个进程, 到不如说是部分内核代码, 本身没有什么就绪可言)是一个死循环, 检测到需要调度, 则调用schedule()函数完成进程调度工作.

所以不把idle进程看做"进程"的一个原因可能是它是Scheduler吧.

但是呢, 这仅仅是现有操作系统的一种调度手段, 可并不代表这是唯一的调度手段. 可以脑洞大开, 让任一进程都可以作为调度器! 只要修改linux现有的代码, 当然, 那种情况就另当别论了.

Node对两个Timer的超时时间做了个小trick, 任何大于TIMEOUT_MAX小于1ms的超时都被视为1ms.

setTimeout和setInterval在Node下的封装基本上一样, 这里单拿前者举例.

exports.setTimeout = function(callback, after) {

after *= 1; // coalesce to number or NaN

// 保证setTimeout永远会延时执行

if (!(after >= 1 && after <= TIMEOUT_MAX)) {

after = 1; // schedule on next tick, follows browser behaviour

}

// ...

var ontimeout = callback;

timer._onTimeout = ontimeout;

// ...

exports.active(timer);

return timer;

};官方文档对setImmediate并不准确, 基本上让所有没读过源码(包括读得不仔细)的人对其产生极大误解.

主要来自setImmediate和setTimeout(0)谁先谁后的问题,

exports.setImmediate = function(callback, arg1, arg2, arg3) {

var i, args;

var len = arguments.length;

var immediate = new Immediate();

L.init(immediate);

// ...

// 这里是setImmediate能执行的关键, c++作用域里会检查`_needImmediateCallback`

// c++那部分代码太长我就不贴了, 全在src/node.cc里, 自己去看.

if (!process._needImmediateCallback) {

process._needImmediateCallback = true;

process._immediateCallback = processImmediate;

}

// ...

return immediate;

};这个在异步函数里优先级最高大家都知道, 属于idle观察者也清. 代码在src/node.js里实现.

代码很长, 不多说, 所有process.nextTick堆积的任务都会在事件循环的next tick(后面讲)里一口气执行.

这里还有一个重点: _tickCallback函数是idle观察者在next tick里的主回调函数:

function _tickCallback() {

var callback, args, tock;

do {

while (tickInfo[kIndex] < tickInfo[kLength]) {

tock = nextTickQueue[tickInfo[kIndex]++];

callback = tock.callback;

args = tock.args;

// Using separate callback execution functions helps to limit the

// scope of DEOPTs caused by using try blocks and allows direct

// callback invocation with small numbers of arguments to avoid the

// performance hit associated with using `fn.apply()`

if (args === undefined) {

doNTCallback0(callback);

} else {

switch (args.length) {

case 1:

doNTCallback1(callback, args[0]);

break;

case 2:

doNTCallback2(callback, args[0], args[1]);

break;

case 3:

doNTCallback3(callback, args[0], args[1], args[2]);

break;

default:

doNTCallbackMany(callback, args);

}

}

if (1e4 < tickInfo[kIndex])

tickDone();

}

tickDone();

_runMicrotasks();

emitPendingUnhandledRejections();

} while (tickInfo[kLength] !== 0);

}当整个队列清空后, 继续向下执行_runMicrotasks, Microtask是什么?,

我们暂且不理会它, 先来看与其相关的代码:

function scheduleMicrotasks() {

if (microtasksScheduled)

return;

nextTickQueue.push({

callback: runMicrotasksCallback,

domain: null

});

tickInfo[kLength]++;

microtasksScheduled = true;

}

function runMicrotasksCallback() {

microtasksScheduled = false;

_runMicrotasks();

if (tickInfo[kIndex] < tickInfo[kLength] ||

emitPendingUnhandledRejections())

scheduleMicrotasks();

}注意到microtask在调度时跟process.nextTick的行为差不多, 也是将任务压到nextTickQueue里, 然后在next tick里一次性处理掉.

process.nextTick初始化过程的其他部分代码:

startup.processNextTick = function() {

// 保存nextTick任务的队列

var nextTickQueue = [];

var pendingUnhandledRejections = [];

var microtasksScheduled = false;

// ...

function emitPendingUnhandledRejections() {

var hadListeners = false;

while (pendingUnhandledRejections.length > 0) {

var promise = pendingUnhandledRejections.shift();

var reason = pendingUnhandledRejections.shift();

if (hasBeenNotifiedProperty.get(promise) === false) {

hasBeenNotifiedProperty.set(promise, true);

if (!process.emit('unhandledRejection', reason, promise)) {

// Nobody is listening.

// TODO(petkaantonov) Take some default action, see #830

} else {

hadListeners = true;

}

}

}

return hadListeners;

}

addPendingUnhandledRejection = function(promise, reason) {

pendingUnhandledRejections.push(promise, reason);

scheduleMicrotasks();

};

};上面三个是Node下很常用的用来实现异步函数的工具, 可惜官网并没有对他们的差别给出易懂的解释(我猜测原因是他们默认你充分了解event loop并且熟读libuv源码...).

好了, 这里必须要说的一个例子:

setImmediate的表现在新旧版本中的差异:

setImmediate ->

console.log 'immediate-1'

process.nextTick ->

console.log 'nextTick-1'

setImmediate ->

console.log 'immediate-2'

process.nextTick ->

console.log 'nextTick-2'我在Node-v0.11.14中的测试结果符合以往的认知:

# immediate-1

# nextTick-1

# immediate-2

# nextTick-2按照正常的认知, 因为process.nextTick属于idle, 而setImmediate属于check, 它积压的任务在每个tick里执行一个.

所以setImmediate的第一个任务执行完后并不会接着执行第二个任务, 而是进入next tick, 执行process.nextTick的任务.

然而在iojs-v3.2中出现了颠覆世界观的一幕:

# immediate-1

# immediate-2

# nextTick-1

# nextTick-2输出结果很让人惊讶, 这种情况应该是setImmediate和process.nextTick一样把所有任务在next tick里一气呵成了.

不过并没有见官方文档做出改动, 暂不知道这种解释是否正确.

这里要举另外一个例子, setImmediate和setTimeout的表现.

setImmediate(function() { console.log('immediate'); });

setTimeout(function() { console.log('timeout'); }, 0);哪个先打印出来? 'immediate'? 'timeout'? 可以尝试一下, 实际结果可能是这样的:

# 第N次尝试 =>

# timeout

# immediate

# ...

# 第M次尝试 =>

# immediate

# timeout如果process.nextTick乱入:

process.nextTick ->

console.log 'nexttick'

setImmediate ->

console.log 'immediate'

setTimeout ->

console.log 'timeout'结果又是另一番景象:

# nexttick

# timeout

# immediate先从解释第一种情况. 在libuv的event loop代码中有这么一段核心代码. 上面没少提到next tick, event loop的每一次loop被称作一个tick:

while (r != 0 && loop->stop_flag == 0) {

// tick开始时更新当前时间

uv__update_time(loop);

// 1. 执行超时的计时器任务

uv__run_timers(loop);

// 2. 执行上次推迟执行的I/O回调函数

ran_pending = uv__run_pending(loop);

// 3. 执行idle任务

uv__run_idle(loop);

// 4. 执行prepare任务

uv__run_prepare(loop);

timeout = 0;

if ((mode == UV_RUN_ONCE && !ran_pending) || mode == UV_RUN_DEFAULT)

timeout = uv_backend_timeout(loop);

// 5. 开始I/O poll, (网络I/O为epoll(Linux为例), 文件系统I/O等其他异步任务为thread pool).

// 得到底层通知后, 通常会在本次tick执行I/O回调函数

uv__io_poll(loop, timeout);

// 6. 执行check任务

uv__run_check(loop);

uv__run_closing_handles(loop);

// ...

r = uv__loop_alive(loop);

if (mode == UV_RUN_ONCE || mode == UV_RUN_NOWAIT)

break;

}我们着重关注的是步骤1, 3, 5, 6, 暂且看做setTimeout的任务,process.nextTick的任务,I/O任务,setImmediate的任务.

于是我们得到了观察者的执行顺序: timer > I/O > check.

即然这样, 为什么第一个例子结果会不确定呢?

这时Node对setTimeout改动的结果, 记得最开始提到的setTimeout源码中的重点吗?

setTimeout的任务无论如何都会延时入队, 最早也是在1ms之后.

所以对于第一个例子, 由于首次call stack的占用时间没法确定, 在next tick时可能已经过了1ms, 也有可能小于1ms,

所以check和timer的执行先后没法确定.

当我们把process.nextTick加入call stack时, next tick一定最先执行它的任务,

结束后耗时基本上已经超过1ms了, 于是timer的任务先被执行.

最后check的任务得到执行, 这也是为什么会有确定的输出结果.

紧接上文, 在process.nextTick的源码里发现了MicroTask这个东西, 当时并没有解释此为何物,

只描述了行为. 因为提起microTask就不得不回到Browser环境来.

参见 https://html.spec.whatwg.org/multipage/webappapis.html#event-loops

异步任务都需要依赖一个宿主环境, 由它提供一个称之为"事件循环"的机制, 正如Node一样, 浏览器里的async也依赖这么一个event loop.

相比Node, 浏览器里的event loop就简单的多. 这个loop只检查两类queue: macroTaskQueue, microTaskQueue.

分别存放macroTask和microTask.

每个event loop可以有多个macroTask队列, 这类任务和(浏览器中的)setTimeout任务的行为类似,

都是在每个tick执行队列里的一个任务. 相似的特点还有他们都是在每个tick的开始执行的.

包括: timer task, I/O task

每个event loop仅有一个microTask队列, 类似process.nextTick, 一旦执行就一气呵成.

正符合process.nextTick源码里的microtask的行为.

包括: Promise task

每个tick的执行流程:

更多解释参见 https://jakearchibald.com/2015/tasks-microtasks-queues-and-schedules/

以及 https://html.spec.whatwg.org/multipage/webappapis.html#event-loops

这些任务可以是:

setInterval()的问题在定时器的选择上, 有经验的老手会告诉你别用setInterval. 为什么? setInterval的功能是周期性触发定时事件, 而不是周期性执行任务. 比如我们想每隔50ms执行一次syncTask函数, 直觉上告诉我们这样写:

setInterval -> syncTask(), 50但是JavaScript单线程模型告诉你这样不行, 假如syncTask是一个计算量非常大的任务(执行时间远大于50ms), 那么主线程在syncTask结束调用之前是不会交出使用权的, 而计时器的tick是在另一个线程中执行的, 所以计时器依然会生效: 每隔50ms触发定时, 同时将每个任务压入队列等待主线程空闲, 而一旦主线程空闲下来, 队列里的任务将在next tick依次执行掉. 如此往复, 队列里的任务会越积越多, 而我们每隔50ms的预期也就没法实现了. 与其说是不能实现预期功能, 不如说这会带来严重后果: 随着任务的积压, 主线程将马不停蹄的执行syncTask, 这会导致主线程负载过高, 随之而来的就是严重的性能损耗, 无法及时(甚至根本不能)做出响应.

这里要说的不包含上面讲的任务积压导致执行周期不精确问题, 而是计时器本身的_bug_. 众所周知CPU都有个时钟周期, 亦作'tick', 基本上计算机的所有工作都依赖时钟, 它也代表一台计算机所能计量的最小时间单位, 一般计算机大概在3~4ms左右.

所以你把代码写成这个样子然后指望它立马执行是不可能的:

setTimeout -> console.log 'haha', 0为了证明所言不虚, 我们可以写一个这样的代码, 利用累计任务计算一个平均值:

diff = 0

i = 0

test = ->

if i < 10000

i++

initTime = Date.now()

setTimeout ->

startTime = Date.now()

diff += startTime - finishTime

test()

, 0

test()

# 计算平均延时

console.log diff / i单线程事件驱动确实为JavaScript带来了莫大的优势, 然而不能充分利于CPU也常被人诟病.

在浏览器里, js和UI渲染是互斥的线程, 一旦执行点耗时的逻辑, 页面渲染就卡住了, 必须要等到js跑完. 而这种设计是为了保证交互上逻辑正确性: js触发的UI重绘一定要等到js执行完, 一旦js线程与UI线程并行执行可能导致不可预期的后果.

异步事件又称"任务", 即前文提到的macrotask/microtask.

同步事件即"事件".

没有异步事件那么复杂, 他们的执行会在this tick而不用等到next tick, 就是触发即执行. 同步事件是Event Driven Programming(Pub/Sub设计模式)的一个实现, 不需要额外线程或其他底层机制的辅助便可实现, 如Node里的EventEmitter, 触发的都是同步事件, 触发原理就是普通的JavaScript代码遍历一次事件名字对应的数组中保存的回调函数, 很显然这和其他代码并没有什么两样, 所以是同步的.

除了EventEmitter, 浏览器中的大多数DOM事件(比如click事件)都是同步的, 为此可以在浏览器里做个试验:

a = document.querySelector "#a"

a.onclick = -> console.log "SYNC"

for i in [0..100]

setTimeout ->

console.log "ASYNC"

, 0

a.click()

a.click()

console.log i所有的ASYNC会在整个循环结束之后打印, 而SYNC会在每次循环最开始时打印两次, 然后打印当前迭代次数, 这就是同步事件与异步事件的区别.

简记为: 凡是用纯JavaScript实现的事件都是同步的, 只有底层实现的事件才有异步的可能.

但你可能会说在一个循环执行完之前单击几次鼠标, 难道会在循环中间打印SYNC ? 也就是这样:

a = document.querySelector "#a"

a.onclick = -> console.log "SYNC"

for i in [0..10000]

# 在循环结束之间单击鼠标

console.log i你会发现你的单机并没有生效, 而是在整个循环结束之后打印响应次数的SYNC. 不是说click是同步吗, 为什么会出现这种情况?

看了前面的任务自然会明白.

我们谈到同步事件时讲的是DOM上的事件, 第一个a.click()是DOM API提供的, 或者说是和Node EventEmitter的emit()一样的方式实现的, 由于和普通代码没区别, 肯定在循环中被处理了.

然而真正的单机事件是由操作系统触发, 然后传递给浏览器的, 这属于系统级的事件(task), 所以是异步的. 当浏览器拿到单击事件通知, 会在底层的回调里调用DOM API的click()方法来实现DOM click. 这和Node里的异步/同步事件协作方式别无二致, 所有的异步函数都是靠底层异步事件通知上层的同步事件, 再由同步事件触发当前环境的回调函数.

该怎么写? 首先我们要明确问题出现的根源: 定时器不管当前任务是否执行完毕都会周期性添加任务到队列. 若要解决问题, 就该让定时器在任务执行完毕后在开始计时, 这里使用了另一个计时器setTimeout, 以形似递归的手段解决了问题:

task = =>

setTimeout ->

syncTask()

task()

, 50

task()JavaScript的一个遗憾就是不支持尾递归优化, 这给有情怀的函数式追随者泼了一头冷水. 不过好消息是我们可以同过一个小小的hack手段实现"尾递归":setTimeout.

因为setTimeout的异步性, 当调用结束时(调用会立即结束), 整个函数会释放掉当前堆栈(但是依情况可能保留context对象), 因此无论"递归"调用多少次都不会出现'RangeError: Maximum call stack size exceeded'的错误:

# 普通无限递归调用

recu = ->

console.log 1

recu()

# => RangeError: Maximum call stack size exceeded

# 使用setTimeout的模拟"尾递归"

recu = ->

console.log 1

setTimeout recu, 0

# => 1 1 1 1 .....因为timer触发的回调永远是在nextTick里执行的, 所以这就给了程序流程重新调度的机会.

比如在页面的某个div上添加了click监听器执行taskA, 然后因为某个需求又在其子元素(比如一个按钮)上添加了一个click监听器执行taskB. 要求在click按钮时先执行taskA, 再执行taskB.

DOM上的事件模型有一个冒泡过程, 一般都是先从最深层的子节点触发事件, 事件逐层冒泡, 最后才触发最上层的回调, 冒泡是同步的.

btn.onclick = (e) ->

taskB()

div.onclick = (e) ->

taskA()

# 永远都是先taskB()后taskA()用setTimeout把taskB放到next Tick从而改变了执行流程, 所以先执行taskA了:

btn.onclick = (e) ->

setTimeout taskB, 0

div.onclick = (e) ->

taskA()再举一个实际的例子. 把输入框里输入的英文实时地变成大写.

# 貌似该这么写...

input.onchange = (e) ->

@value = @value.toUpperCase()可是并没有达到预期的效果: 总是在输入下一个字符时才会把前一个转大写. 这是因为onchange事件总是在输入框的value赋值前触发. 知道了原理我们就可以搞定了:

input.onchange = (e) ->

setTimeout =>

@value = @value.toUpperCase()

, 0前面提到的JavaScript单线程带来的问题: 跑脚本时DOM无法及时渲染. 这里有个活生生的例子:

实现背景色随时间的灰度渐变. 还是先来一段理想中的代码:

div.background = "rgb(#{i},#{i},#{i})" for i in [0...255]但是循环导致没空渲染UI, 看到的结果就是开始是白色, 突然变成黑色. 这时next tick就能大展身手了:

# 把js放到next tick里,先让UI渲染占用线程

liner = (i) ->

div.background = "rgb(#{i},#{i},#{i})"

setTimeout liner, 0, ++i

liner 0现在就可以看到灰度的渐变过程了, 这也是Worker出现前早先解决密集任务下cpu负载过高问题的思路: 分割任务.

本来懒得记录这种命令介绍类的日志, 都是Google一大把一大把的文章. 但我对分区一向很谨慎, 为了防止今后重蹈覆辙, 还是决定把分区相关的步骤有条理的记一下.

Q: 如何对设备分区?

A:

fdisk <device>命令搞定. 子命令很简单, 忘记如何操作只需m就行,p是最常用的没有之一:查看设备当前的分区表. 现在fdisk很人性化, 分区时可以输入+N<G|M|K>(比如+2G)来确定分区大小.parted命令更强, 支持2T以上的分区. 当然这是题外话, 简单的分区也是可以的. 子命令同样简单, help或者他的alias:m会告诉你想要的.分区之后如果不想重启, 就手动刷新一下内核分区表(就是从硬盘分区表里重读一遍): partprobe.

Q: 如何建立文件系统?

A: 在使用disk之前, 必须格式化, 即建立操作系统能识别的文件系统.假如已经通过上一步划分了分区/dev/sda9, 这一步操作即可将该分区格式化成ext4:

mkfs.ext4 /dev/sda9

其他格式可以键入mkfs并按两次tab键查看.

one more thing, 格式化分区之前别挂载它.

Q: 如何调整文件系统的大小?

A: 目前我所知道的就是resize2fs.如果在上一步你并没有将整个分区格式化, 这样partition可能留有空余. 想把这部分也利用起来, 就可以:

resize2fs /dev/sda9

后面也可以接参数,表示额外需要的新空间大小:

resize2fs /dev/sda9 [Ns|K|M|G]

注意resize大小永远不能超过partition大小.

允许扩增已挂载的文件系统, 但要减小文件系统必须先卸载.

其余注意事项详见man resize2fs

Q: 如何对格式化之后的分区调整大小?

A: 注意与上面的区别. 如果根分区已满, 并且当初安装系统时手残没有为/usr,/var, /home等目录划分独立挂载点. 其实这个问题隐含了两个其他问题:

如何调整已挂载的根目录大小?

最保险也是最通用的做法是livecd, 在livecd下原有设备根分区是unmounted的, 因此可以当做普通分区一样resize.

如果想折腾一下, 也可以用fdisk, fdisk允许在挂载状态下对设备重新分区:

fdisk /dev/sda

# 记住根目录分区的起始柱面

> p

# 删根目录所在分区

> d

# 如果没有空闲空间那就继续删

...

# 从原来根分区起始处重建分区

> n

# 重设大小...

这样一番折腾, 原有的数据会不会被清掉? 答案是不会, 不然我为何会记录这么脑残的做法...

不过为了以防万一也应该备份一下数据.

之后参照上一步, 调整以下分区上的文件系统大小.

如何调整其他文件系统大小?

上面的步骤对这个完全适用. 除了fdisk, 也可以用parted, 或者建立LVM(逻辑卷管理), 很明显后者的做法是一劳永逸的.

这在parted里很简单, 不用删除分区再重建, 直接一个子命令resizepart搞定分区调整:

parted /dev/sda9

# 出于习惯, 可以先看看当前分区表

> p

# 比如调整分区号为 5 的partition, end参数代表硬盘位置, 表示要扩展到哪里, 可正可负, 比如: 4G, 10%, -5G.

> resizepart 5 <end>

记得先卸载目标分区, 调整之后执行partprobe刷新内核分区表.然后用resize2fs重新调整文件系统大小.

今年外卖平台火遍大江南北.诸如饿了么,美团外卖,百度外卖,淘点点,超人外卖等等等等层出不穷,校园周边小餐馆的生意也做的是风生水起.各种打折,各种送饮料,各种首单立减,真让整日宅在寝室和实验室的家伙欲罢不能啊~

不过呢好日子总会有到头哪一天.随着饮料越送越差,折扣也越来越少,我们开始埋怨吃不到物美价廉的美食了. 于是乎,借着某位室友创业的热情,在另一位猥琐室友的怂恿下,走上了一条"革命之路", 因为当时常送果粒橙, 于是我们为这个计划起名为果粒橙保卫战.

不扯淡了,其实就是"外卖比价". 我们设计应用架构, 分解任务模块, 规划一系列前进流程, 差不多当晚就开始敲代码.

...当然,代码还要靠我来写-_-,这是既苦逼又令人兴奋的工作.(你能理解为什么)

我把应用核心逻辑模块分为两部分, 一块是爬虫,用于抓取各大外卖平台的网页数据;另一块是数据处理,把爬虫爬来的数据做清洗,格式转换和聚类.

架构分为定时更新任务和web服务.

后台更新任务单独启用一个进程,定时(根据正常人的进食时间统计, 设定约每3个小时更新一次)向一组外卖平台网站请求所需数据,经过清洗和转化,分类存储到数据库中.

web服务提供一个面向用户的接口,接收用户查询的地点,返回数据库中整理过的周边餐饮.

爬取数据是个体力活, 你首先要打开控制台看着DOM树一个一个的找父子节点,记id,class,tagname.换句话说写出每家平台通用的CSS path,如果是动态加载的数据,就要找到那个请求地址, 如果数据是JavaScript动态生成的, 你还要模拟执行一次以得出想要的结果. 前台测试通过后,还要用curl之类的工具通过non-browser测试,这是个技术活,因为几乎所有网站都对爬虫做了防范,你要想方设法欺骗web服务器,至于如何做就不谈了(详见之前写的一篇"crawl前端攻防战"), 总之,request模块不适用这个抓取过程, 因此我写了一个简版request专门应付我们要爬的网站server.

得到了原始的html,就可以做数据清洗了,这里使用了Node第三方cheerio模块. 提取必要信息形成一个二维数组,每个元素是一个JSON对象:

[

// platform 1

[

// restaurant 11

{

name: '',

proxy: '',

others: ...

},

// restaurant 12

{

name: '',

proxy: '',

others: ...

}, ...

],

// platform 2

[

// restaurant 21

{

name: '',

proxy: '',

others: ...

},

// restaurant 22

{

name: '',

proxy: '',

others: ...

}, ...

],

...

]这个数据结构的核心字段是name和proxy, 分别标识某个餐馆和对应的外卖平台,用于后期的数据处理.

进行数据处理的下一步:格式化. 因为web服务是依据用户的地点查询获取周边餐饮, 所以我们最重要返回一组周边餐饮信息, 那么考虑设计合适的数据存储schema对查询性能的提升十分重要.

我反反复复设计了几种格式,最终综合格式处理的方便和数据库读写操作的方便,我把schema规定为如下:

{

name1: [proxy1, proxy2, ..],

name2: [proxy1, proxy2, ..],

...

}每次抓取的数据经过处理, 得到如上格式存入数据库中, 这样每次查询时直接抽取周边店名,返回为其代理的外卖平台和每个平台的对这家店的优惠信息.

那么如何有效的转化数据呢? 我设计了一个转化算法. 我们通过爬虫和数据清洗,首先得到那个二维数组, 然后去掉对此步骤不重要的信息, 将二维数组的每个元素映射成对应的name字段的值:

var result = restaurants.map(function (proxy) {

return proxy.map(function (restaurant) {

return restaurant.name;

});

});处理后得到如下格式:

[

[

name1, name2, ...

],

[

name1, name2, ...

],

...

]这样看着就方便多了不是? 然后进行reduce操作:

result.reduce(function (a, p, i, map) {

var o = {};

p.forEach(function (n, j) {

o[n] = [ [i, j] ];

for (var l, m = i + 1; m < map.length; m++)

if ((l = map[m].indexOf(n)) != -1)

o[n].push([m, l]);

});

// 合并

var keys = Object.keys(a);

keys.length && keys.forEach(function (k) {

if (o[k])

o[k] = a[k].length > o[k].length ? a[k] : o[k];

else

o[k] = a[k];

});

return o;

}, {});上面这个函数是整个算法的核心. 最外层reduce整个result数组. 每次reduce调用会新建一个JSON对象, 对于每个子数组, 也就是包含一个平台下所有餐馆名字的数组, 遍历他们, 将不同的名字和对应在二维数组中的位置保存在外层建立的JSON对象里, 并循环后面的子数组, 如果子数组中包含重名的元素,也就是同一家店,也把它的位置push到JSON对象的对应名字的数组里. 在这轮reduce的最后, 合并上一次reduce的结果: 向JSON对象中添加不存在的name, 对于已存在的name, 选取数组长度较大的保存, 最后把这个JSON对象作为这轮reduce的结果返回.

这样, 经过几次reduce, 就筛选出所有店家和他们在原始二位数组中所在的位置:

{

name1: [[x1, y1], [x2, y2], ...],

name2: [[x1, y1], [x2, y2], ...],

...

}最后把位置替换成详细信息:

for (var i in result)

result[i] = result[i].reduce(function (arr, b) {

arr.push(restaurants[b[0]][b[1]]);

return arr;

}, []);就得到了我们想要的格式:

{

name1: [proxy1, proxy2, ..],

name2: [proxy1, proxy2, ..],

...

}整个算法代码如下:

function normalize (restaurants, callback) {

var result = restaurants.map(function (proxy) {

return proxy.map(function (restaurant) {

return restaurant.name;

});

}).reduce(function (a, p, i, map) {

var o = {};

p.forEach(function (n, j) {

o[n] = [ [i, j] ];

for (var l, m = i + 1; m < map.length; m++)

if ((l = map[m].indexOf(n)) != -1)

o[n].push([m, l]);

});

// 合并

var keys = Object.keys(a);

keys.length && keys.forEach(function (k) {

if (o[k])

o[k] = a[k].length > o[k].length ? a[k] : o[k];

else

o[k] = a[k];

});

return o;

}, {});

for (var i in result)

result[i] = result[i].reduce(function (arr, b) {

arr.push(restaurants[b[0]][b[1]]);

return arr;

}, []);

return callback(result);

};但是随着我们观察解析结果, 发现有的商家在不同平台上注册的店名是不一样的! 举个栗子: 在饿了么上名为"辣婆婆川味馆"的一家店, 到了美团上是"辣婆婆川菜馆", 而事实上这两个都是同一家,只是注册的名字不同罢了. 那么问题就来了: 通过我们上面的算法无法识别这些名字上的差异, 最终会将诸如"川菜馆"和"川味馆"视为两家店.

这属于字符串近似匹配. 说来也巧, 正在我寻找解决方案时, 算法分析的最后一课恰好提到了"文本的近似匹配问题". PPT里提供了三种思路, 为了尽快实现, 我简单的看了一下基于编辑距离的近似匹配原理.

何为编辑距离? 简单说就是 "由字符串A变换到字符串B需要的最少步数"--wikipadia. 比如:

A = "abcbab"

B = "abcad"

这个变换是单个字符的"添加,剔除,修改", 那么从A到B最少需要两次变换, 描述如下:

function computeEditd(p, t) {

var plen = p.length + 1;

var tlen = t.length + 1;

var i, j;

var matrix = new Array(plen);

// 初始化矩阵

for (i = 0; i < plen; i++)

matrix[i] = new Array(tlen + 1);

// 动态规划方法填充矩阵

for (i = 0; i < plen; i++)

for (j = 0; j < tlen; j++)

if (i == 0)

matrix[i][j] = j;

else if (j == 0)

matrix[i][j] = i;

else

matrix[i][j] = Math.min.apply(null, [

matrix[i][j - 1] + 1,

matrix[i - 1][j] + 1,

(function () {

if (p[i] == t[j])

return matrix[i - 1][j - 1];

else

return matrix[i - 1][j - 1] + 1;

})()

]);

return matrix[p.length][t.length];

};由于满足"优化子结构"与"重叠子问题", 因此算法属于动态规划策略的应用.

采用这个方法修改原有算法:

function normalize(restaurants, callback) {

var result = restaurants.map(function (proxy) {

return proxy.map(function (restaurant) {

return restaurant.name;

});

}).reduce(function (a, p, i, map) {

var o = {};

p.forEach(function (n, j) {

o[n] = [ [i, j] ];

for (var l, m = i + 1; m < map.length; m++) {

// 近似匹配

var likely = map[m].reduce(function (tuple, e, l) {

// 计算并更新编辑距离

var newEditd = editdUpdate(computeEditd(e, n), tuple.editd);

tuple.pair = newEditd < tuple.editd ? [m, l] : tuple.pair;

tuple.editd = newEditd;

return tuple;

}, { editd: Infinity });

// 找到其他组中的近似元素

if (likely.editd < 6)

o[n].push(likely.pair);

}

});

// 合并

var keys = Object.keys(a);

keys.length && keys.forEach(function (k) {

if (o[k])

o[k] = a[k].length > o[k].length ? a[k] : o[k];

else

o[k] = a[k];

});

return o;

}, {});

console.log(result);

for (var i in result)

result[i] = result[i].reduce(function (arr, b) {

arr.push(restaurants[b[0]][b[1]]);

return arr;

}, []);

return callback(result);

};这里面仍有一个问题, 既然新的算法是根据编辑距离来判定商家的, 那究竟如何定义editd的下限? 这个没有固定标准, 取决于实际测试, 根据解析结果手动调整min_editd的大小. 运行了修改后的程序, 果然很多"有绰号"的餐馆都各自归为一类了, 但又发现了新的问题: 有的店名本身就很短, 这样的话如果低于edited, 两家不同的店就会自动被判为同一家店. 还有, 某些店属于那种连锁机构, 比如"枫林黄米饭(工大店)", "枫林黄米饭(贵新店)", 他们本身就差两个字, 这样也很容易被归为同一家, 可是按照地点的不同又不属于同一家. 看来我们的算法还需要进一步改进. 但是就算是改进, 也只能解决第一种问题, 第二个问题不是那么简单就能解决的, 这涉及到了一个智能识别的问题, 甚至还需要人工参与调整. 由于时间关系暂时也没有进一步研究.

经过数据处理阶段的数据, 就可以将其存入数据库了. 我选用leveldb作为数据持久化方案.一是因为小巧,对系统资源占用很少;二是读性能颇高.如何将格式化的数据存入leveldb? 我仍是按照查询性能优先的原则设计了存储方案.:

{

key: location-restaurantName,

value: [proxy1, proxy2, ...]

}

因为value中的值不是经常变化的(与同一家餐馆合作的外卖平台也就那么几家, 基本上不会变, 变化的是各平台的优惠政策),所以直接保存在value的数组里.

到此为止, 整个后台定时任务模块就设计完了.

Web服务上, 我使用了比较熟悉的express框架提供用户接口. 最初的打算是让用户自己输入查询地点, 直接传到server执行查询逻辑, 但这个方法的弊端逐渐显露出来. 一次测试中, 我输入了一个新的查询地点, 按正常的程序逻辑来说, 这一请求首先会到达数据库, 如果未在数据库中找到该地点, 则调用爬虫模块, 执行"抓取-清洗-格式化"流程, 然后把结果数据先返回给客户端, 随后异步写入leveldb.

这一过程看似合情合理: 采用类似DNS服务器的原理, 根据用户的请求缓存新的信息. 但查询某些学校时程序会crash, 有两种情况:

由于周边信息是通过对应平台使用的地图服务获取的, 而这些平台的位置查询服务均是按选项提供的, 也就是说他会对你的输入做近似匹配, 并提供几个地点数据库中相似结果供你选择, 这样就避免了无效输入导致的错误结果. 但是对我们这些靠爬取数据为生的家伙来说, 我们往往会忽视无效输入的后果: 我们潜意识认为地图API会提供给我们需要的一切信息! 而用户输入可能不准确, 当我们用这些不准确的结果调用API时, 就会得到"空结果", 空结果在外卖平台网页端上的呈现为"未找到"等等错误提示. 如果我们对这样一个网页执行"抓取-清洗-格式化", 那么在清洗的过程中就会crash!

我想干脆也模仿那些外卖平台那样, 提供选择性查询, 对于查询结果的差别, 取并集就可以了. 但暂时也是没那工夫, 也怕由此衍生出更多未知的问题. 后来还是启用了HTTP服务器集群, 采用那种经典的"Master-Slaver"架构监听crash情况并平滑重启, 貌似将来也能成为个备选方案啥的~.

有一段时间我几乎每个三小时刷一次, 看看三大外卖主力有木有什么新优惠政策, 心想再做一个trending系统就更好了, 看看外卖优惠哪家强? 找ctheyvs来帮忙啊~

当时列出的还有稳定性,安全性测试以及新功改进/添加什么的, 都还没开始. 前端页面让室友来写, 这都一个多月了还没搞定这让我情何以堪... 我也是醉啦~

跟我料想的差不多, 大多数人都是三分钟热血, 在热血中豪情壮志,指点山河,激扬文字,舍我其谁. 但三分钟过后血压又下来了.. 这尼玛, 哎. 不过也无所谓喽, 我这个人呢很随性, 向来对很多事都无所谓的啦. 不是什么原则问题, 爱干嘛干嘛吧~.

但毕竟这也算一个酷酷的玩意儿, 里面也涉及到不少好玩的东西和技术, 涨涨经验还是不错的嘛~~~ 你说是不?

这是机智的面试官问的第三个问题~

我当时回答的比较含糊,因为毕竟一个网络协议的内容如此之复杂,之前也并没有过于关注掩码这东西究竟起什么作用。出于被自己熟悉领域难住的羞愧,面试后立马去翻看RFC,找到好长一大段的描述。

由于目前网络上还没有关于WebSocet各方面介绍与考量十分详尽的文章(当然英文版的RFC除外),这里我说一下那个神奇的Masking Key是做什么的吧。

首先不要把它与IP网络中的子网掩码弄混,绝壁不是一个概念,后者是用来划分子网的, 而前者是考虑到网络安全问题而设计的。

WebSocket协议规范里讲:“为了避免迷惑网络中介(如代理服务器),以及涉及到安全问题,客户端必须mask所有送给服务器的frame。”

不明白怎么回事?没关系,在此之前先了解下网络上针对基础设施的攻击,然后才能明白掩码的设计道理。

通过WebSocket协议成为被攻击对象的,除了终端设备之外还有其他部分的web基础设施,比如代理服务器就可能成为攻击的对象。

随着websocket协议被开发出来,一项针对代理服务器的攻击(污染那些广泛部署的缓存代理服务器)实验也开始进行。

一般形式的攻击是跟被攻击者控制的服务器建立连接,并构造一个类似WebSocket握手一样的UPGRADE请求,随后通过UPGRADE建立的连接发送看起来就像GET请求的frame去获取一个已知资源(在攻击场景中可能是一个点击跟踪脚本或广告服务网络中的资源)。

之后远程服务器会返回某些东西,就像对于这个伪造GET请求的响应,并且这个响应会被很多广泛部署的网络中间设备缓存,从而达到了污染缓存服务器的目的。对于这个攻击的产生的效应,可能一个用户被诱导访问受攻击者操控的服务器,攻击者就有可能污染这个用户以及其他共享相同缓存服务用户的缓存服务器,并跨域执行恶意脚本,破坏web安全模型。

为了避免面这种针对中间设备的攻击,以非HTTP标准的frame作为用户数据的前缀是没有说服力的,因为不太可能彻底发现并检测每个非标准的frame是否能够被非HTTP标准的中间设施识别并略过,也不清楚这些frame数据是否对中间设施的行为产生错误的影响。

对此,WebSocket的防御措施是mask所有从客户端发往服务器的数据,这样恶意脚本(攻击者)就没法获知网络链路上传输的数据是以何种形式呈现的,所以他没法构造可以被中间设施误解为HTTP请求的frame。

这就是掩码存在的原因。

本来到这里就该结束了, 但是协议很负责的深入说明了掩码选择上的要求~

客户端必须为发送的每一个frame选择新的掩码,要求是这个掩码无法被提供数据的终端应用(即客户端)预测。

算法的选择上,为了保证随机性,可以借助密码学中的随机数生成器生成每个掩码。

倘若使用相同的掩码会有什么后果呢?

假设每次发送frame使用了相同的掩码或下一个掩码如何选择被猜出的话,攻击者就可以发送经过mask后类似HTTP请求的frame(做法很简单:攻击者以希望在网络链路上显示的形式构造数据,然后用下一个掩码mask再发出去)。

至于如何用掩码mask原始数据,在前面的 学习WebSocket协议—从顶层到底层的实现原理(修订版) 中已经说过了——按位做循环异或运算.

除此之外,另一个要求是一旦传输开始,客户端必须不准再修改传输的内容,否则攻击者将会发送一个用已知数据(如全0)初始化的frame,并通过第一部分数据的回执(经过mask的数据)计算本次使用的掩码,然后修改将要发送的frame使之mask后表现的是一个HTTP请求,原理同前面所讲,不再赘述。

上面所描述的安全模型重点关注的是客户端发送类HTTP请求的frame给服务器,所以仅仅需要mask从客户端到服务器的数据,反之则没有mask,但是为了完成请求,前提是客户端必须能够伪造请求。因此,并不强制要求mask双向通信,只要保证一方的数据是经过mask的即可。

尽管掩码提供了保护,但不符合规定的HTTP代理服务器仍是那些“不使用掩码的客户端-服务器”攻击对象!

所有内容归结为一句话:为防止攻击者获知网络链路中传输的原始数据,提供不可预测的掩码至关重要。

涉及源码

src/node_main.cc

src/node.h (src/node.cc)

src/node.js

src/env.h

这篇日志的诞生纯属偶然,我当初只是想寻找NPM上处理底层网络的模块用来处理ARP协议,搜索了半天并没有发现合适的,最贴近的也就是raw_socket模块,但它只能用来处理IP协议上层和ICMP数据报.然后我就开始各种Google各种Baidu,未果.于是想自己扩充一下这个底层功能,便查找C/C++ addon的文档,这就一不小心"误入歧途"了,从学习addon到研究模块加载最后成了源码阅读.

也好,在这个时候从设计和编码的角度重审Node也别有一番体会.

拿来Node的源代码,熟悉源码构建编译的童鞋一眼就会发现src,lib目录.这表示Node的源码结构很清晰,以下是源码目录的主要结构:

deps/ Node核心功能的依赖,包括V8引擎源码,libuv源码,openssl,npm等等lib/ JavaScript核心模块(*.js),如http.js,net.js等src/ Node架构的核心源代码以及C++核心模块/内置模块(*.cc | *.h)tool/ 包含Node的项目构建工具gyp,js2c.py等,用来编译源码生成二进制文件,预处理工作等node.gyp 重要的构建配置文件common.gyp 同样是一个配置文件为了了解Node工作流程,首先进入src目录,找到node_main.cc文件.整个文件的最后几行包含着令人倍感亲切的int main()主函数,进程就从这里开始了:

// UNIX

int main(int argc, char *argv[]) {

return node::Start(argc, argv);

}

#endif我将按照Node进程的真正流程一步步说明,因此下面代码中的嵌套有些地方并不是真实的代码结构,可以通过阅读我的注释明白情况.

接下来是src/node.cc文件,包含了主要的执行逻辑,node_main.cc中调用的Start(argc, argv)函数就是在这里面实现的:

// 源码3581行处:Start函数,这个函数做一些初始化主程序环境变量,配置v8环境,libuv事件循环等基本工作

int Start(int argc, char** argv) {

// ...

// ...

// Hack around with the argv pointer. Used for process.title = "blah".

argv = uv_setup_args(argc, argv);

// This needs to run *before* V8::Initialize(). The const_cast is not

// optional, in case you're wondering.

int exec_argc;

const char** exec_argv;

// 源码 3601行:调用Init.注释里说该函数的调用要在V8::Initialize()之前.

Init(&argc, const_cast<const char**>(argv), &exec_argc, &exec_argv);

// 源码 3360行:声明了Init函数,它接受了初始传递的参数长度,参数指针等.这个函数就是具体的初始化函数

void Init(int* argc,

const char** argv,

int* exec_argc,

const char*** exec_argv) {

// 这里是一些初始化libuv函数的操作.

// Initialize prog_start_time to get relative uptime.

prog_start_time = uv_now(uv_default_loop());

// Make inherited handles noninheritable.

uv_disable_stdio_inheritance();

// init async debug messages dispatching

// FIXME(bnoordhuis) Should be per-isolate or per-context, not global.

uv_async_init(uv_default_loop(),

&dispatch_debug_messages_async,

DispatchDebugMessagesAsyncCallback);

uv_unref(reinterpret_cast<uv_handle_t*>(&dispatch_debug_messages_async));

// 还有几个初始化V8以及处理传入参数的函数

// ...

// ...

// 源码3610行:Init函数执行完毕,执行V8::Initialize()函数,并进入启动的最后阶段

V8::Initialize();

{

Locker locker(node_isolate);

HandleScope handle_scope(node_isolate);

Local<Context> context = Context::New(node_isolate);

// 重要的变量env,代码里很多地方都要用到这个变量.

// 通过createEnvironment函数创建了env对象

Environment* env = CreateEnvironment(

node_isolate, context, argc, argv, exec_argc, exec_argv);

// 源码 3534行:声明了CreateEnvironment函数

Environment* CreateEnvironment(Isolate* isolate,

Handle<Context> context,

int argc,

const char* const* argv,

int exec_argc,

const char* const* exec_argv) {

HandleScope handle_scope(isolate);

Context::Scope context_scope(context);

// 其实在这里创建了env对象

Environment* env = Environment::New(context);

uv_check_init(env->event_loop(), env->immediate_check_handle());

uv_unref(

reinterpret_cast<uv_handle_t*>(env->immediate_check_handle()));

uv_idle_init(env->event_loop(), env->immediate_idle_handle());

// Inform V8's CPU profiler when we're idle. The profiler is sampling-based

// but not all samples are created equal; mark the wall clock time spent in

// epoll_wait() and friends so profiling tools can filter it out. The samples

// still end up in v8.log but with state=IDLE rather than state=EXTERNAL.

// TODO(bnoordhuis) Depends on a libuv implementation detail that we should

// probably fortify in the API contract, namely that the last started prepare

// or check watcher runs first. It's not 100% foolproof; if an add-on starts

// a prepare or check watcher after us, any samples attributed to its callback

// will be recorded with state=IDLE.

uv_prepare_init(env->event_loop(), env->idle_prepare_handle());

uv_check_init(env->event_loop(), env->idle_check_handle());

uv_unref(reinterpret_cast<uv_handle_t*>(env->idle_prepare_handle()));

uv_unref(reinterpret_cast<uv_handle_t*>(env->idle_check_handle()));

if (v8_is_profiling) {

StartProfilerIdleNotifier(env);

}

Local<FunctionTemplate> process_template = FunctionTemplate::New(isolate);

// 然后在这里定义了process类

process_template->SetClassName(FIXED_ONE_BYTE_STRING(isolate, "process"));

// 这里着重注意.因为后面的调js主文件(src/node.js)时传入的就是这个process对象

Local<Object> process_object = process_template->GetFunction()->NewInstance();

// 这里也很重要!以后process对象都是通过env调用的

env->set_process_object(process_object);

// 紧接着这里对process对象进行细节配置

SetupProcessObject(env, argc, argv, exec_argc, exec_argv);

// ...

// 源码2586行:声明了SetupProcessObject函数,你会在这个函数中发现熟悉的身影,没错想就是Node环境中的process对象的那些属性和方法

void SetupProcessObject(Environment* env,

int argc,

const char* const* argv,